部署

Linux驱动开发

zabbix

binder协议

BBS

自定义watermark

数维杯

电池

滤波器

visualstudio

ecmascript

illustrator

统一认证

symfony

netty

选择器优先级

教程

3D游戏建模

BP神经网络

splunk

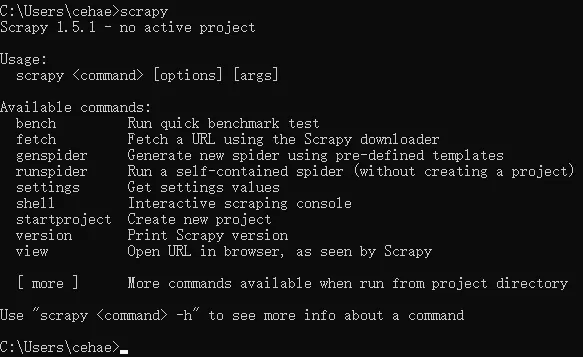

scrapy

2024/4/11 17:35:00【爬虫】python爬虫工具scrapy的安装使用

关于使用方法及教程参考如下:

Scrapy中文官方入门教程

本文章的安装环境如下

window10 python3.X

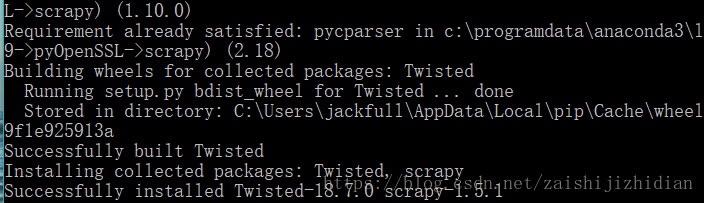

文中使用的是python3.5,安装方法如下

第一步,安装pypiwin32

pip install pypiwin32

第二步,安装Twisted

首先,…

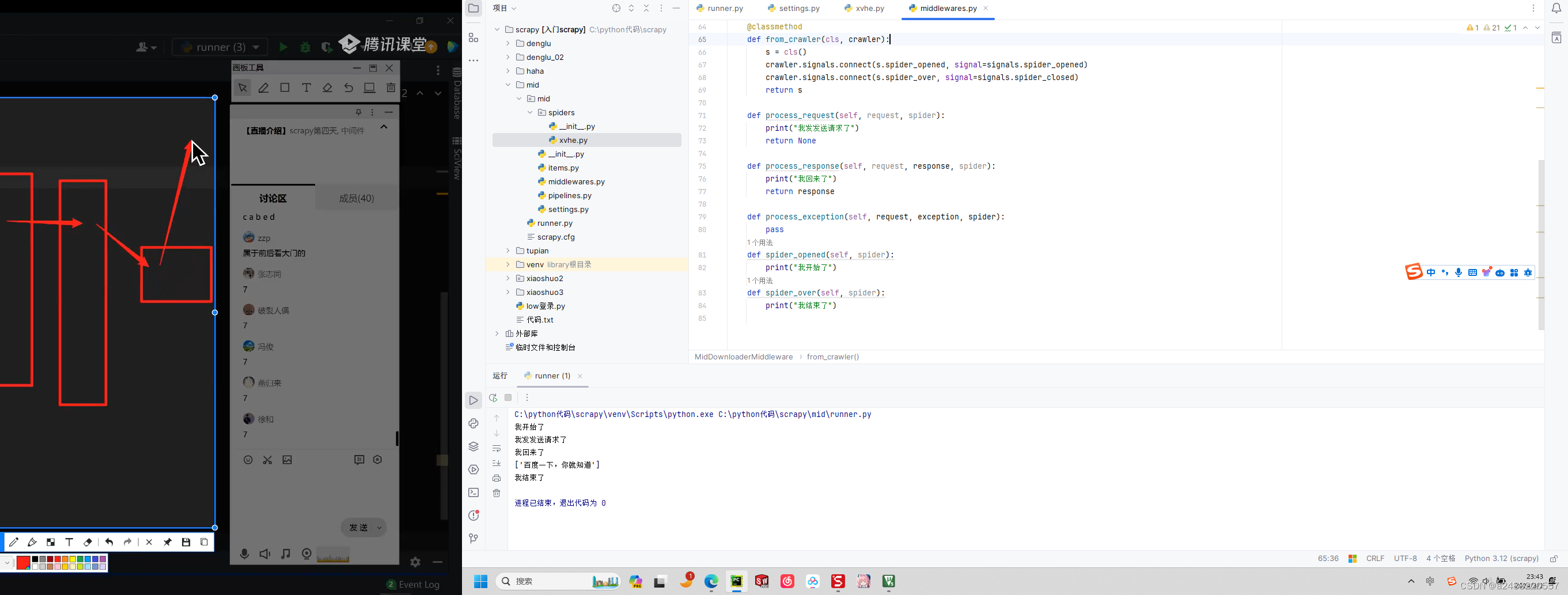

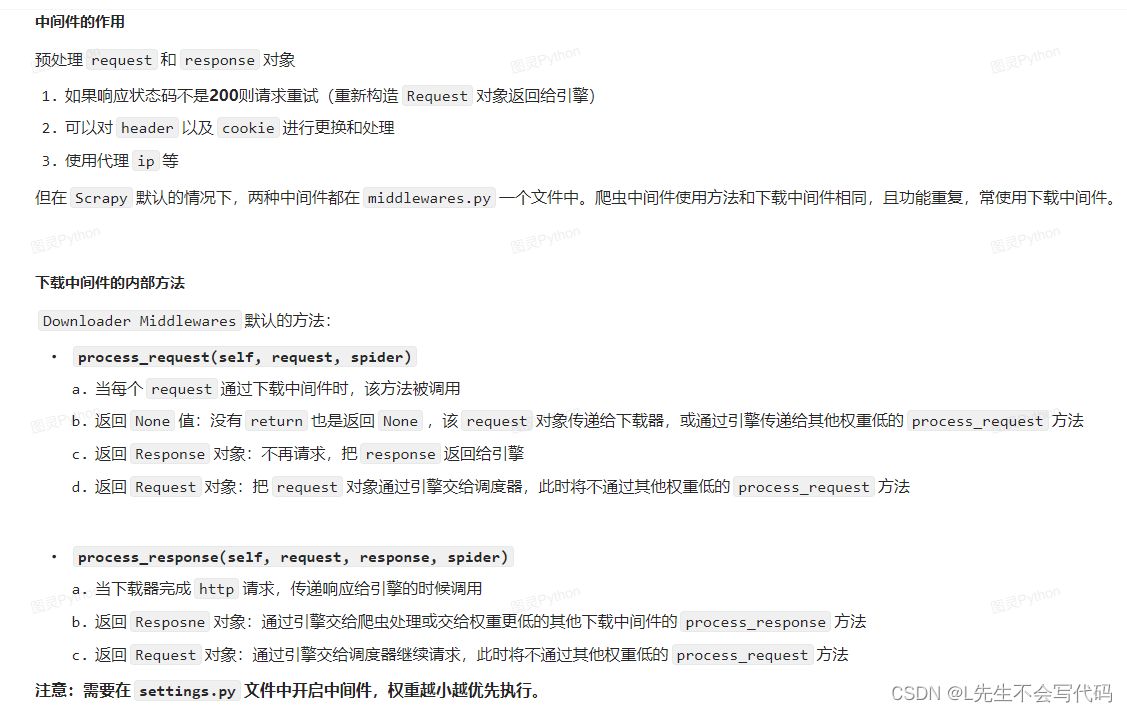

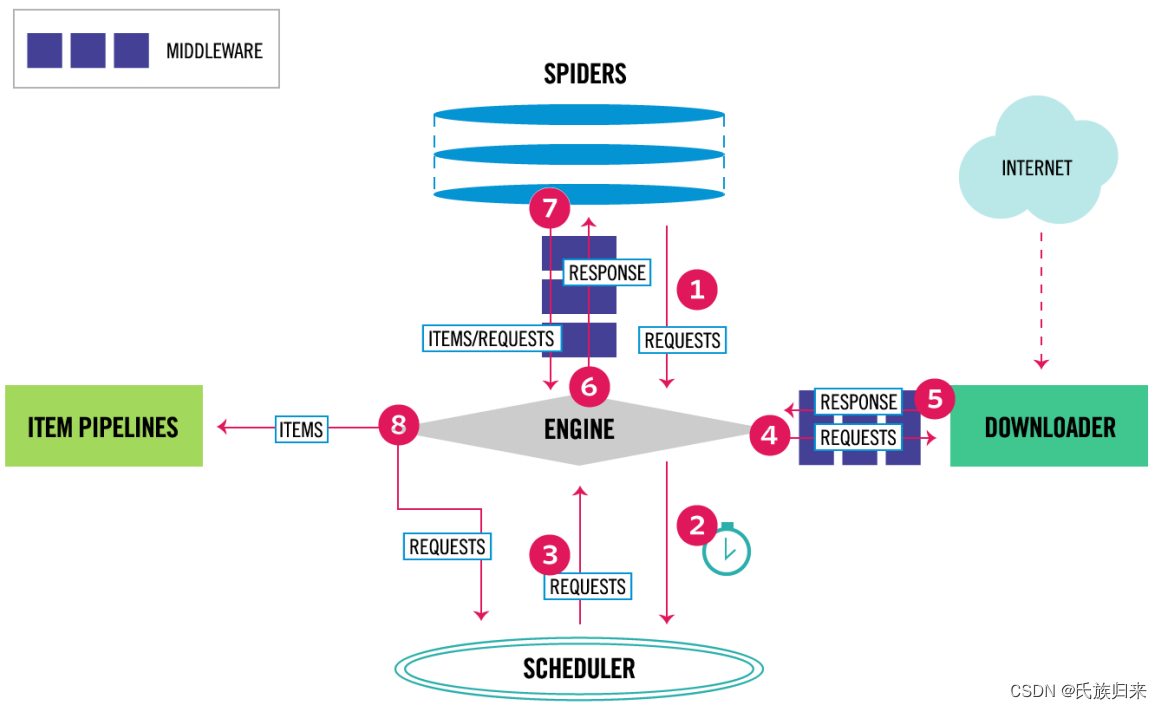

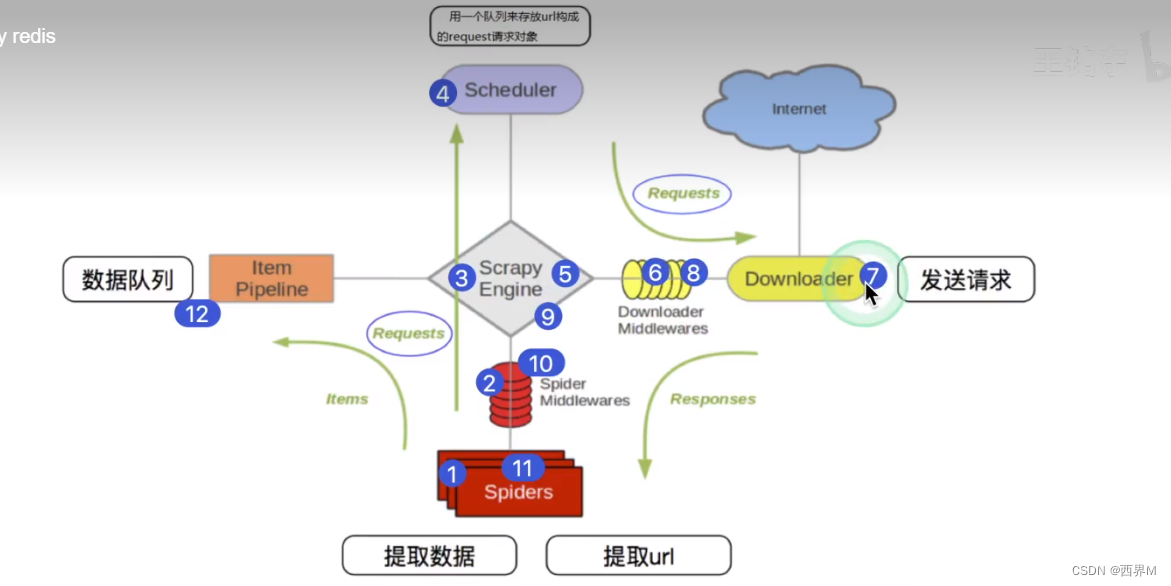

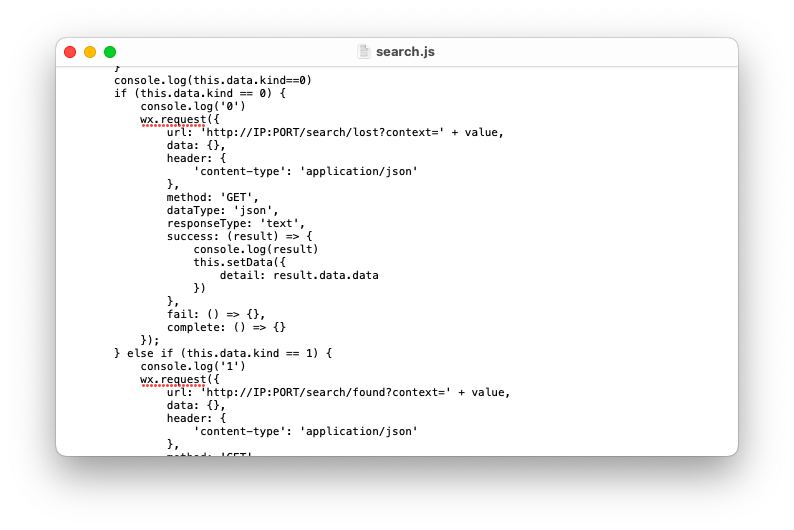

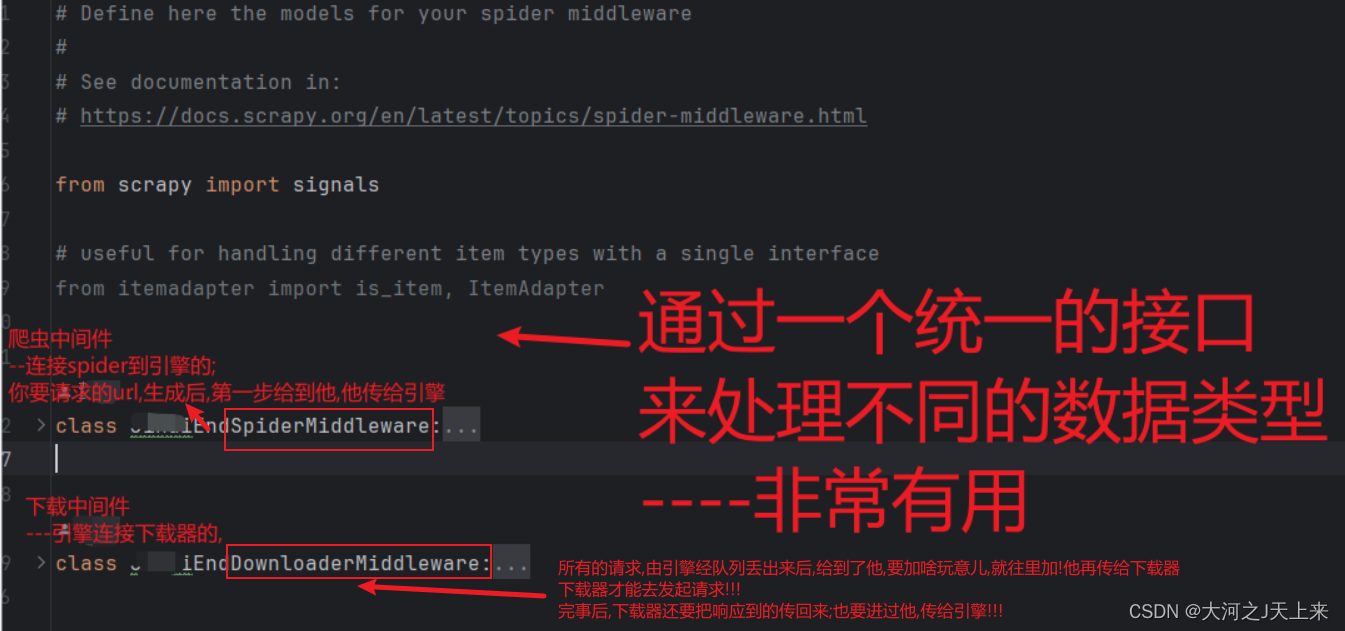

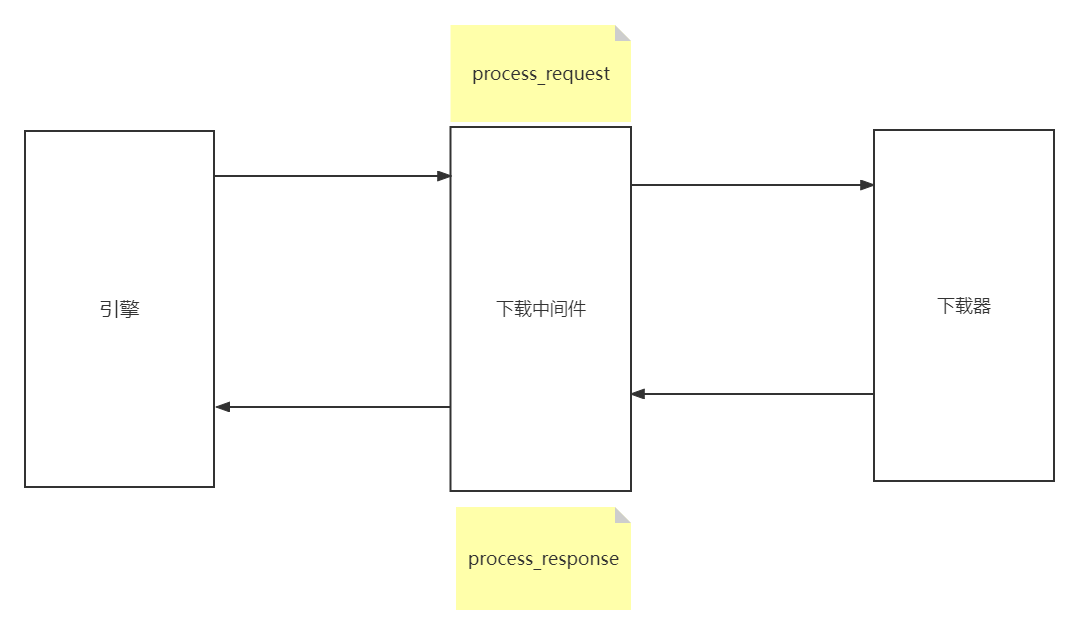

scrapy爬虫中间件和下载中间件的使用

一、关于中间件

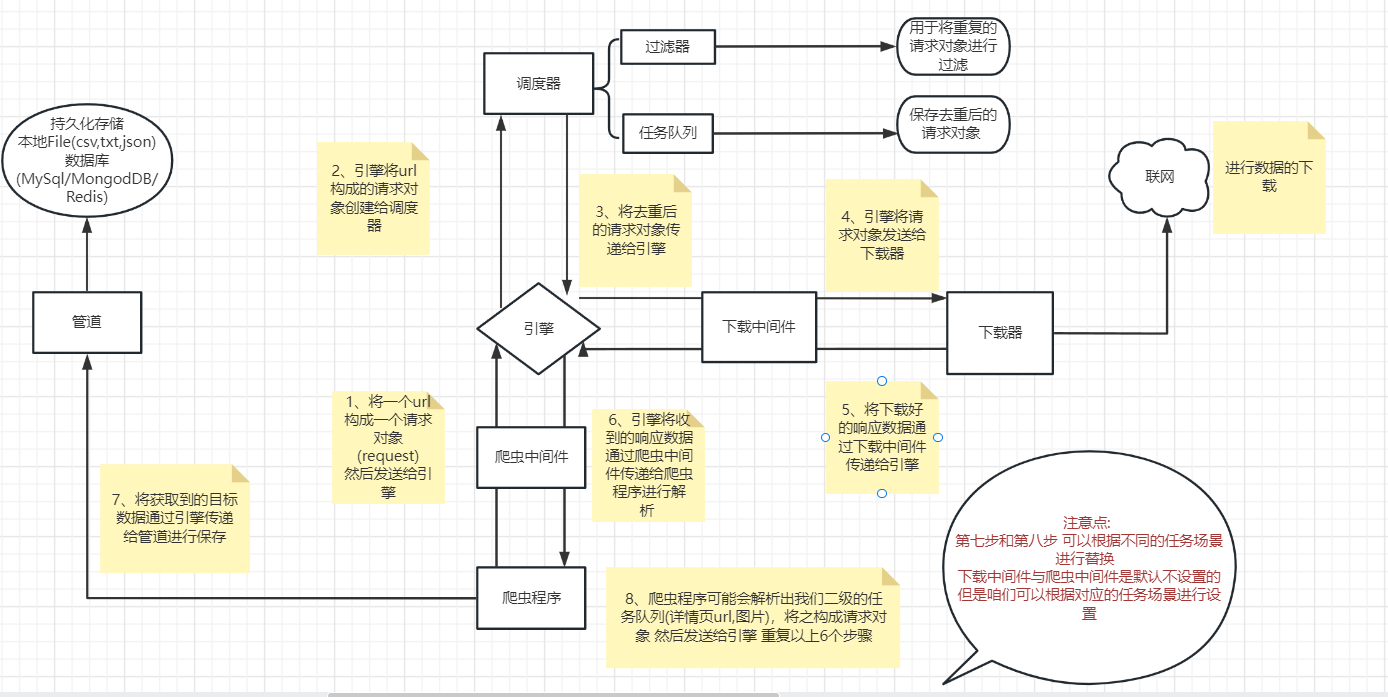

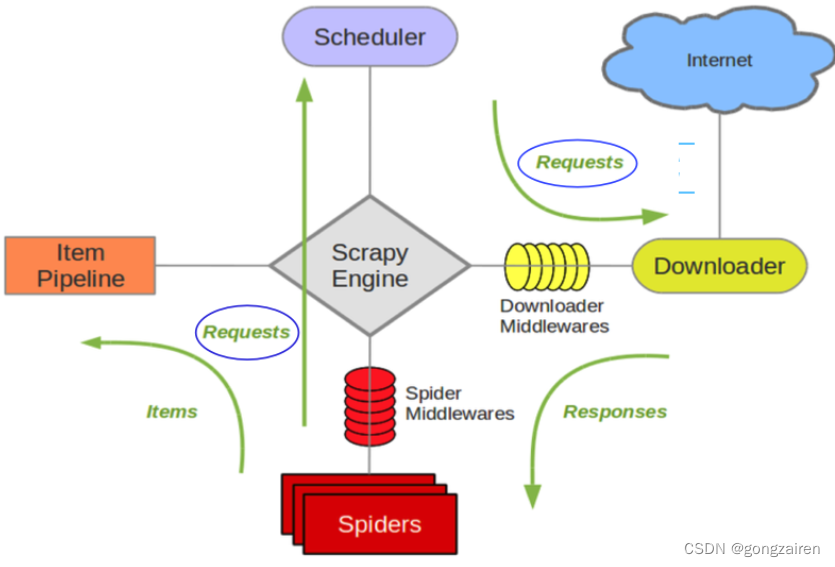

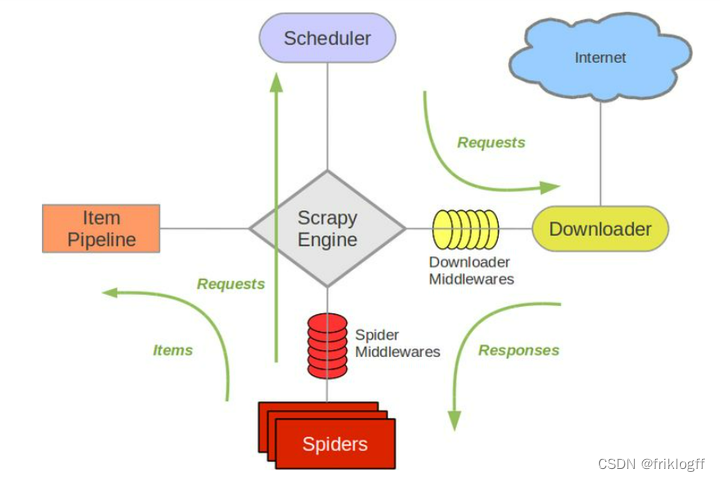

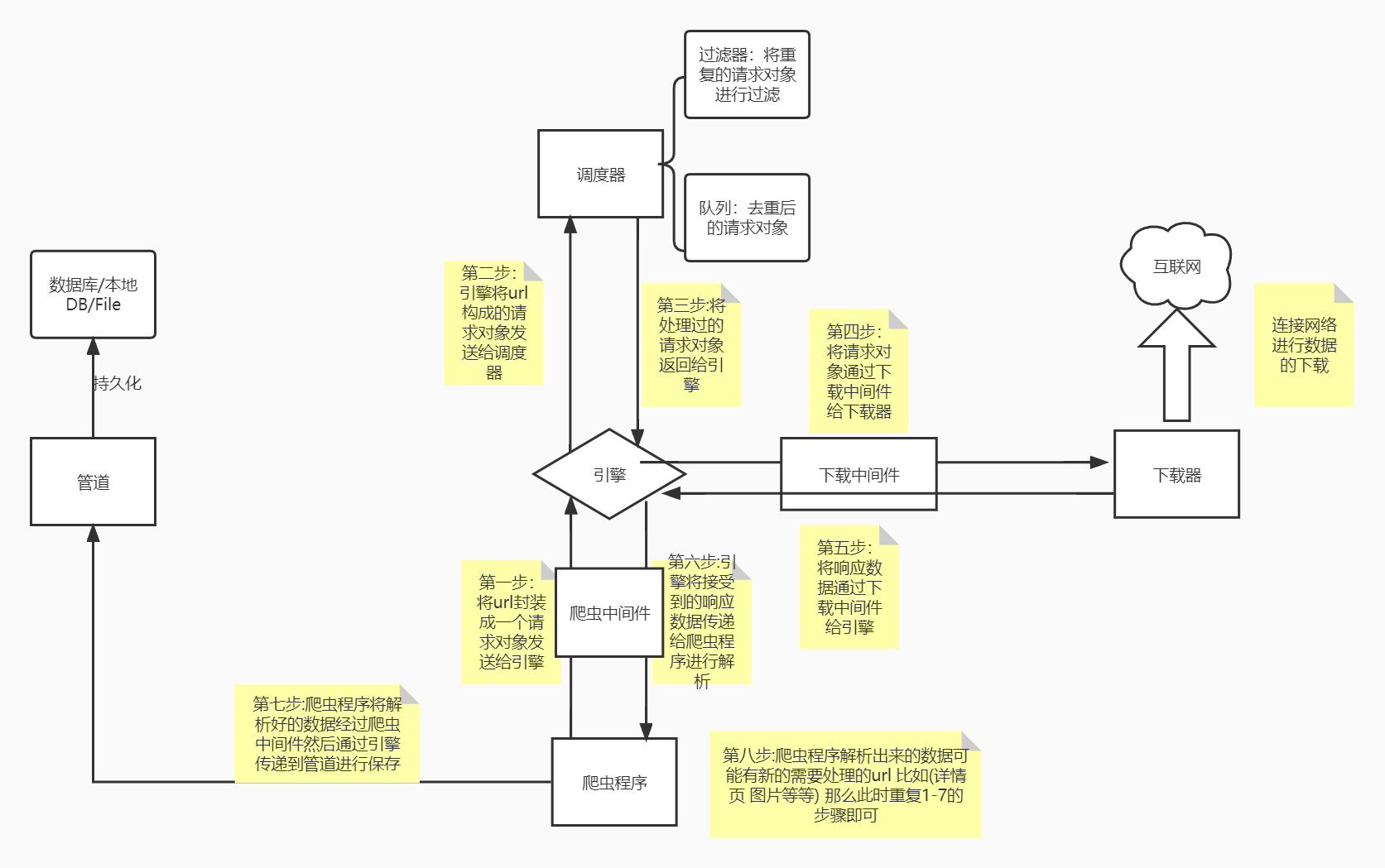

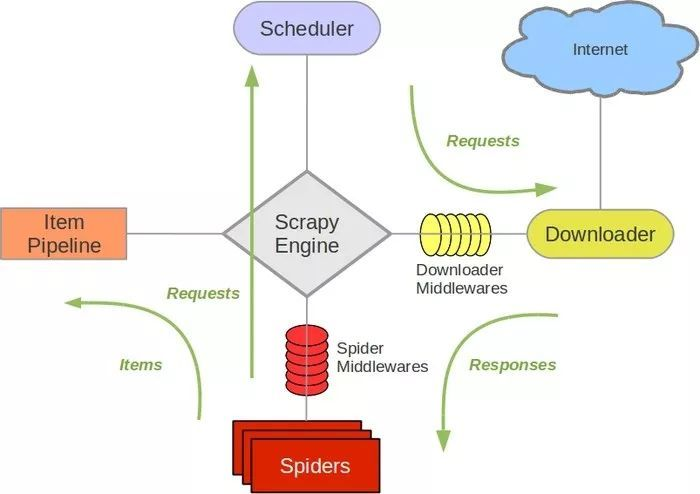

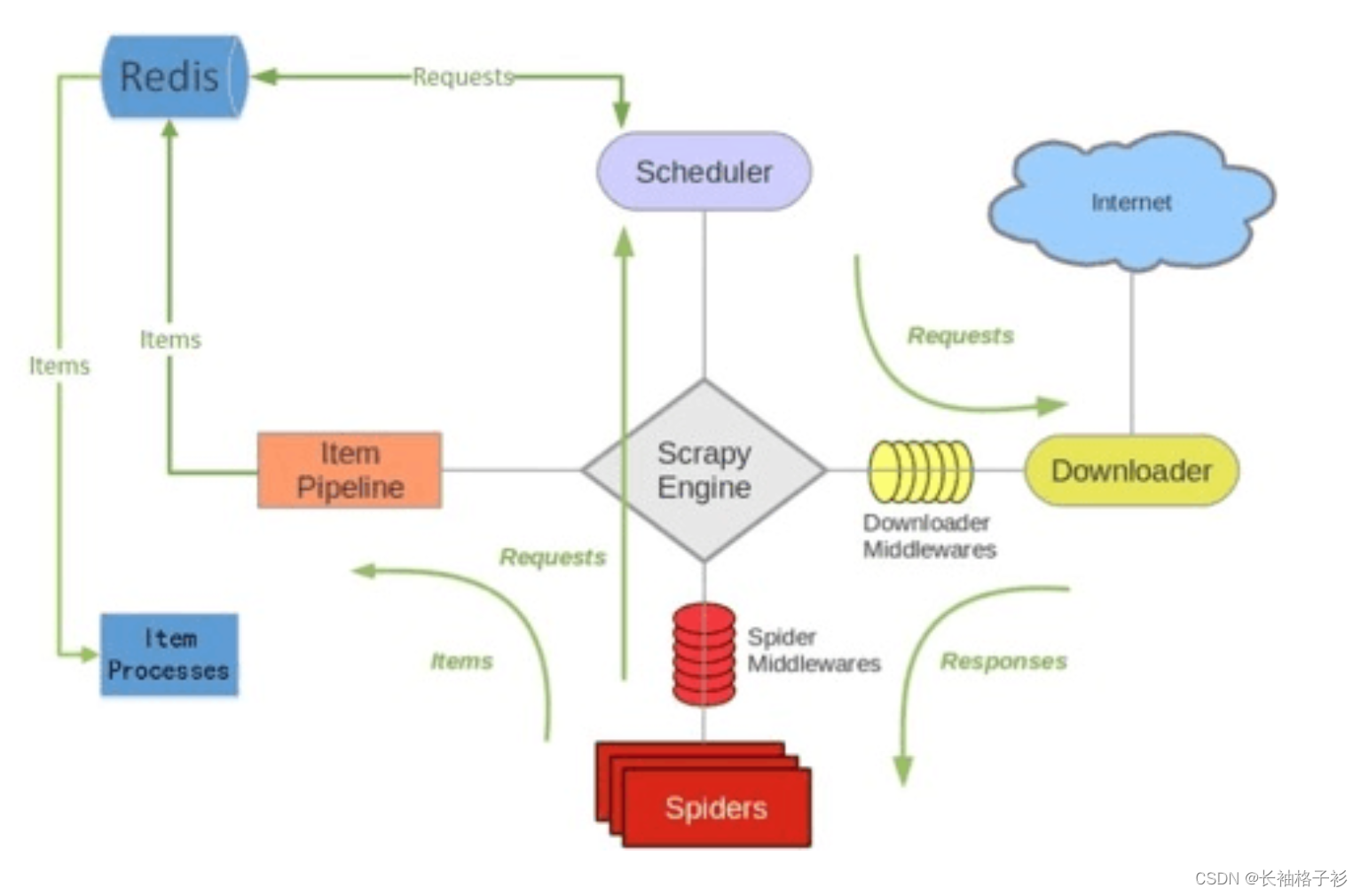

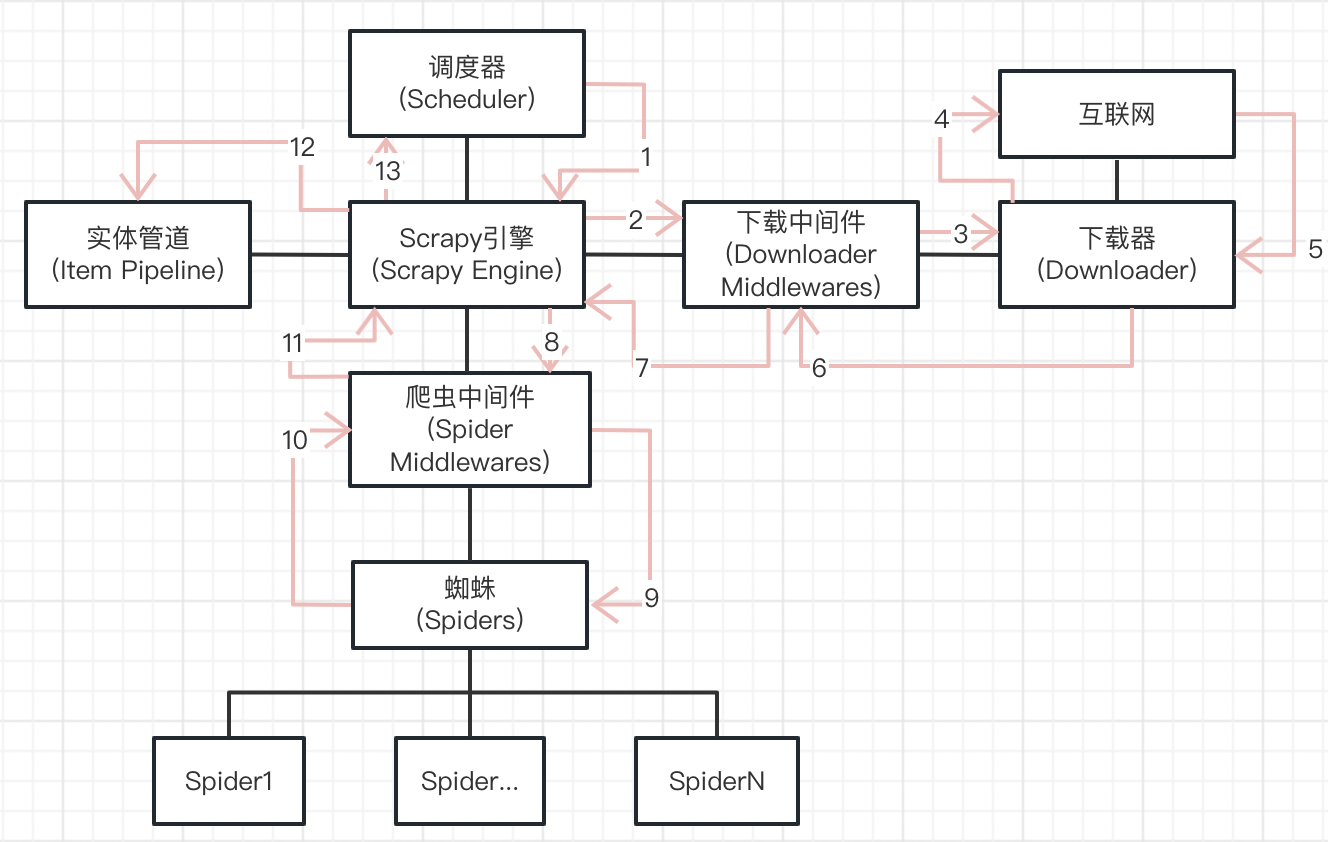

之前文章说过,scrapy有两种中间件:爬虫中间件和下载中间件,他们的作用时间和位置都不一样,具体区别如下:

爬虫中间件(Spider Middleware)

作用: 爬虫中间件主要负…

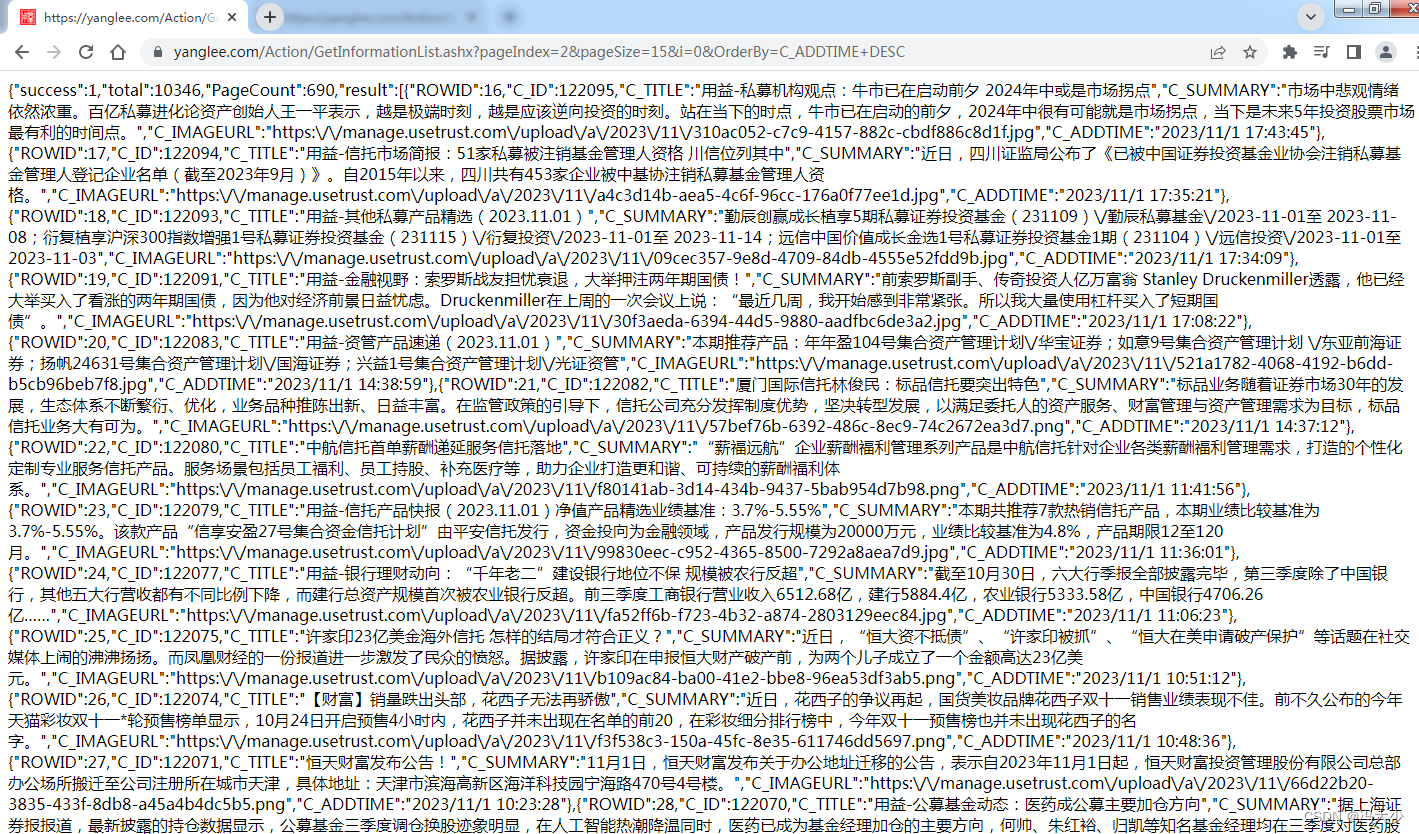

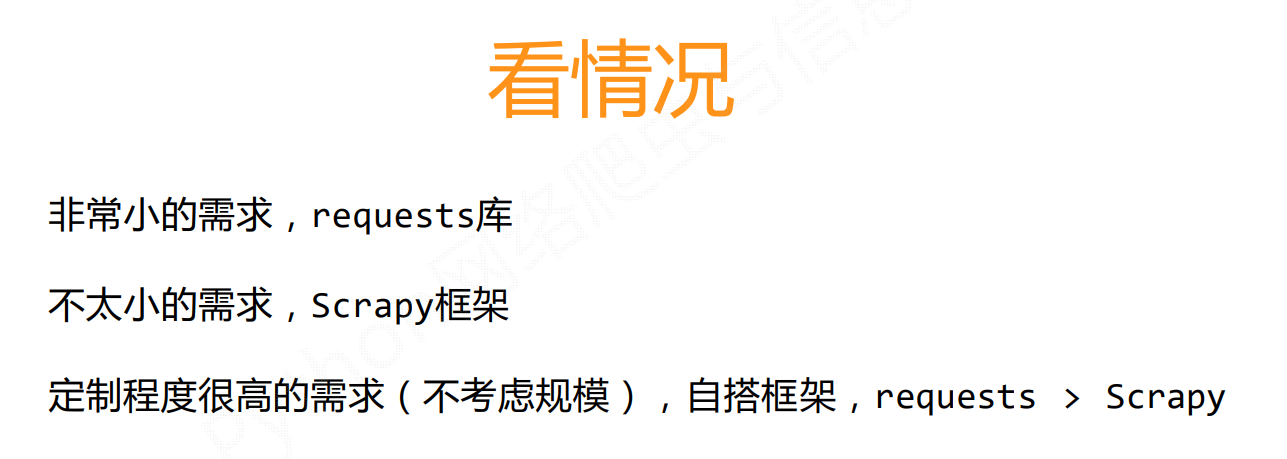

Python爬虫:使用Scrapy框架进行高效爬取

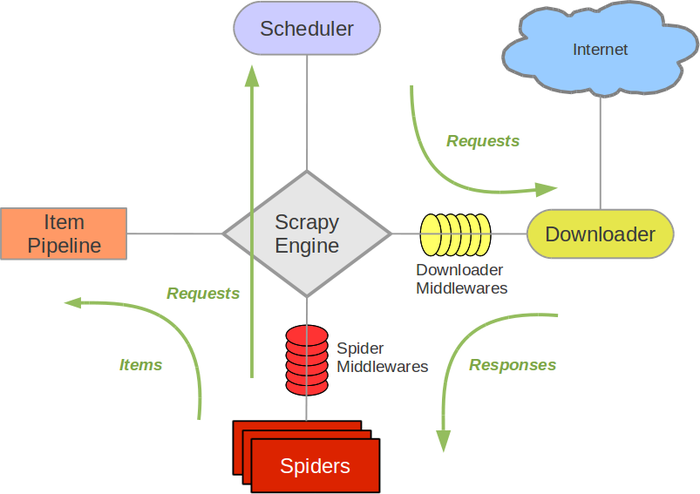

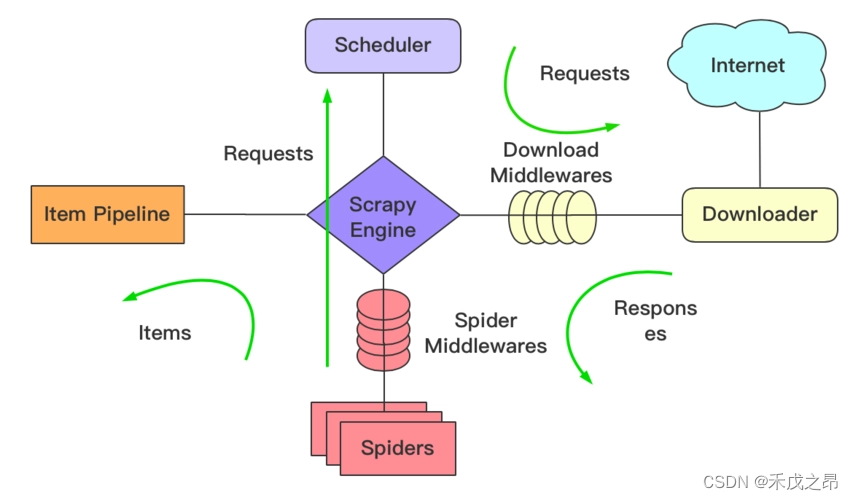

Python爬虫可使用的架构有很多,对于我而言,经常使用Scrapy异步处理框架Twisted,其实意思很明确,Scrapy可以实现多并发处理任务,同一时间将可以处理多个请求并且大大提高工作效率。

Scrapy是一个强大且高效的Python爬虫…

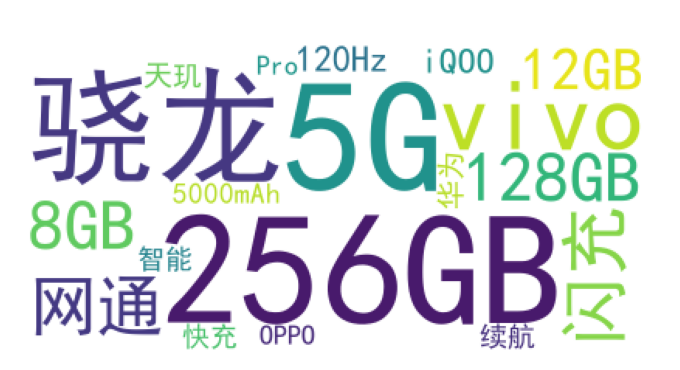

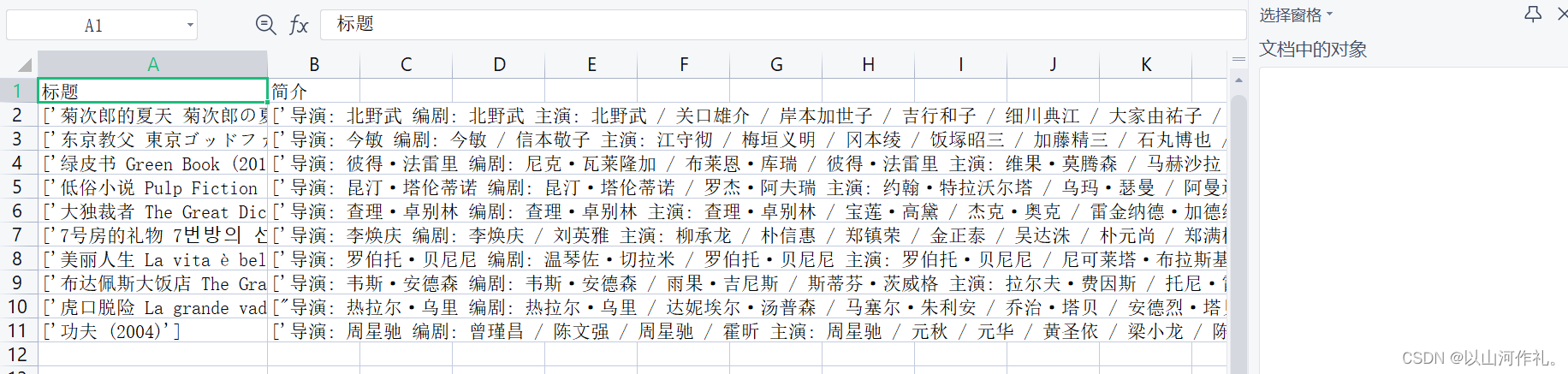

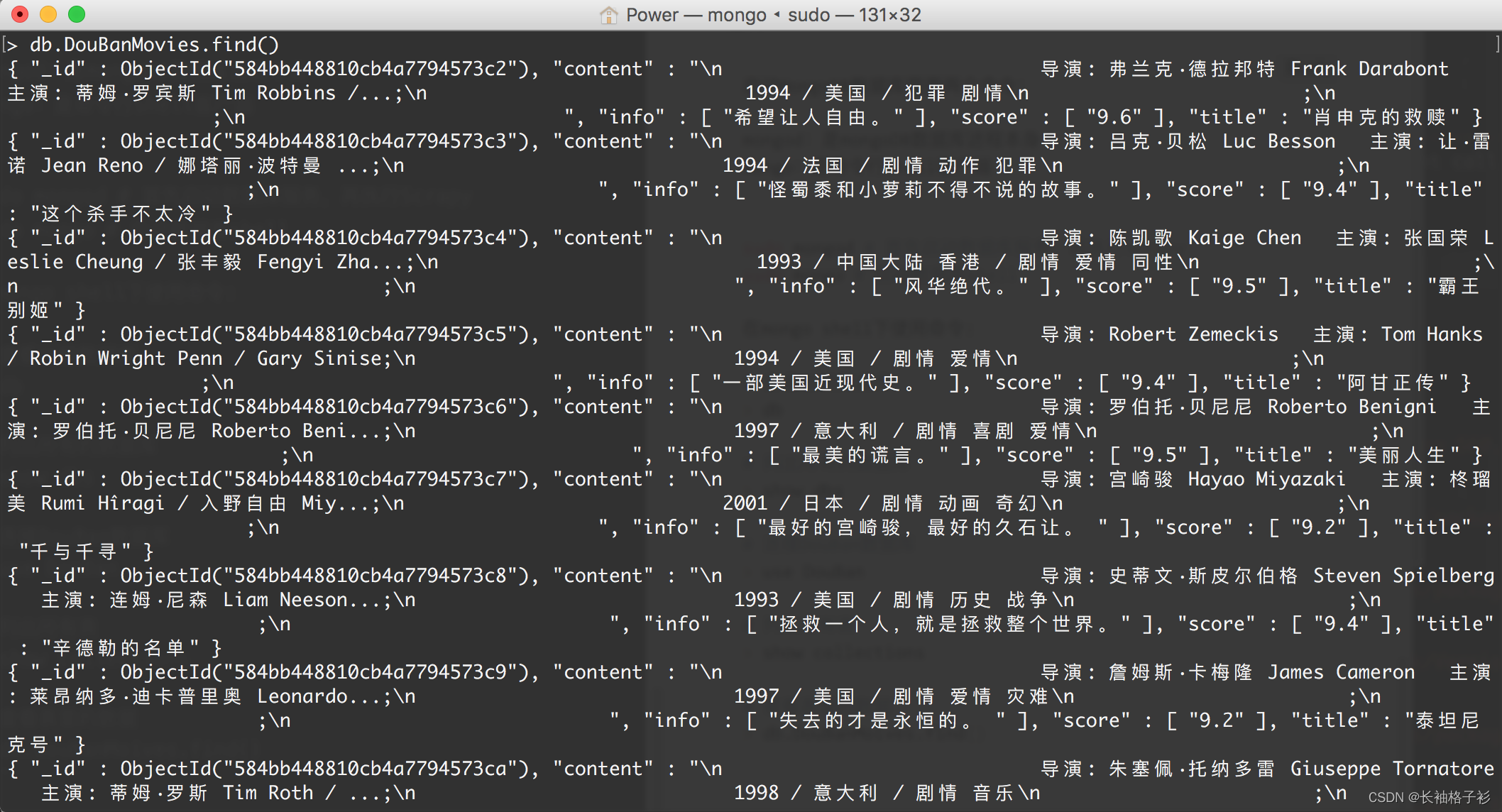

豆瓣图书评分数据的可视化分析

导语

豆瓣是一个提供图书、电影、音乐等文化产品的社区平台,用户可以在上面发表自己的评价和评论,形成一个丰富的文化数据库。本文将介绍如何使用爬虫技术获取豆瓣图书的评分数据,并进行可视化分析,探索不同类型、不同年代、不同…

Python爬虫基础之Scrapy框架详解

目录 1. 简介2. Scrapy的安装3. Scrapy的架构4. Scrapy的数据流程5. Scrapy开发流程5.1 创建项目5.2 创建Spider5.3 创建Item5.4 编写Spider5.5 运行Spider 参考文献 原文地址:https://program-park.top/2023/12/01/reptile_5/ 本文章中所有内容仅供学习交流使用&am…

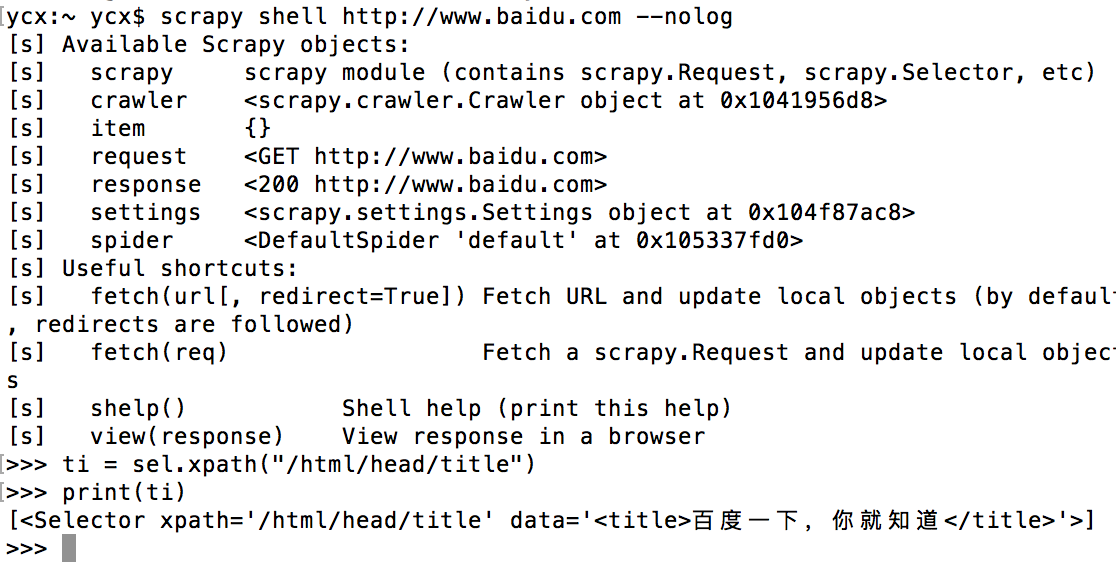

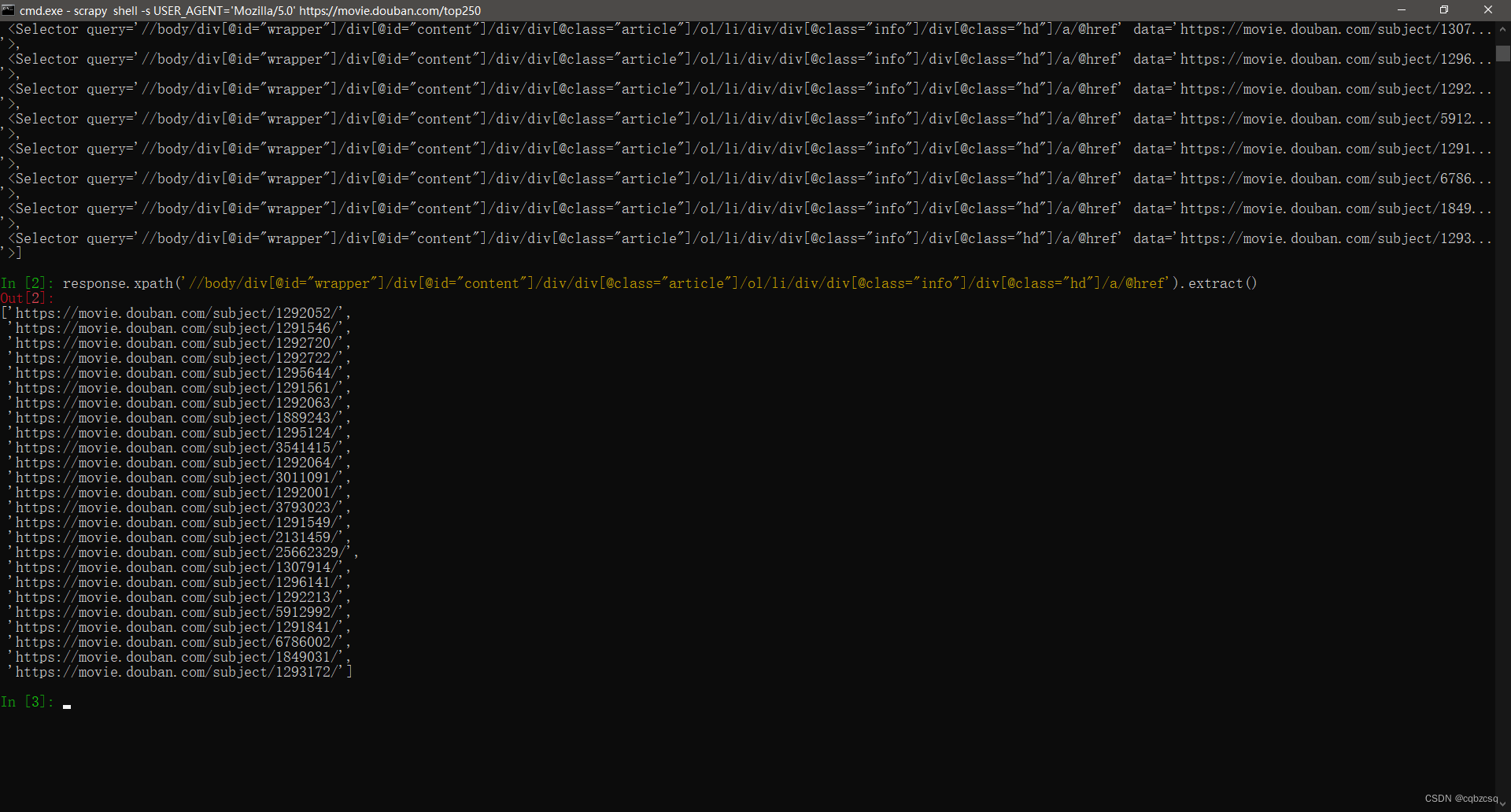

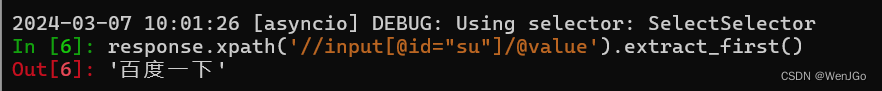

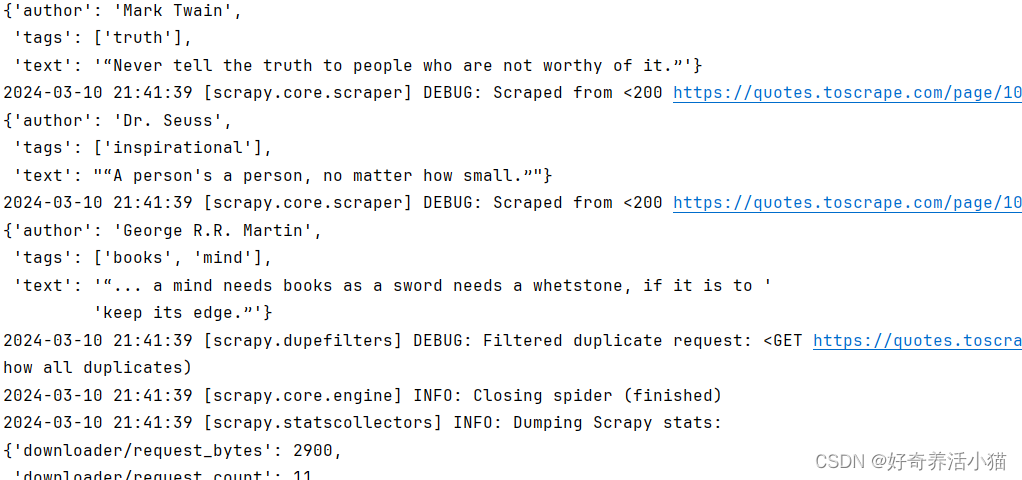

18.网络爬虫—Scrapy实战演示

网络爬虫—Scrapy实战演示 Scrapy Shell简介进入shell调试网站启动Scrapy Shell 查看目标网站获取网站源代码常用方法调试xpath提取数据Scrapy请求子页面请求及返回处理创建项目创建爬虫 数据解析写入csv文件后记 前言: 🏘️🏘️个人简介&…

户外跑步用什么耳机、户外运动耳机推荐

跑步是一项简单的运动,只需要交替迈左右腿就可以进行。然而,跑步有时可能变得单调乏味。即使是意志坚定、热爱跑步的人,在这个漫长的过程中也会感到乏味,更不用说像你我这样的普通跑者了。音乐能够让跑步变得更加有趣,…

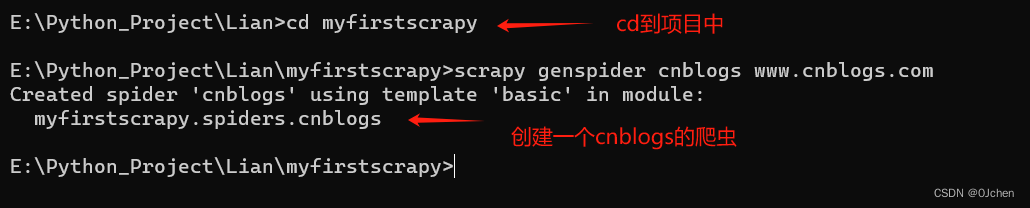

亲测可用,scrapy爬虫展示例

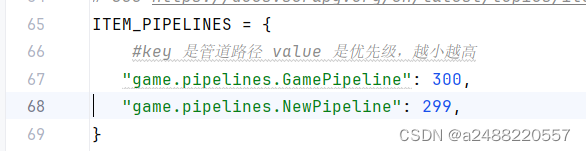

设置过程:

依赖安装: pip install scrapy 创建项目: scrapy startproject projectname 创建爬虫任务: cd projectname scrapy genspider spidername website.com 其中website.com是你需要爬取的网站 设置修改: #管道文…

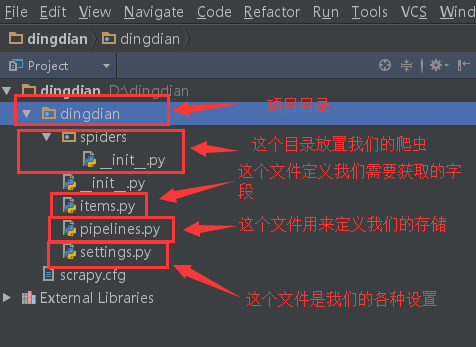

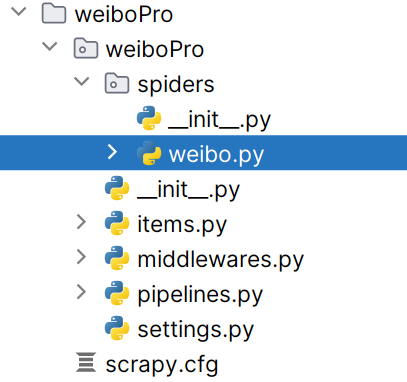

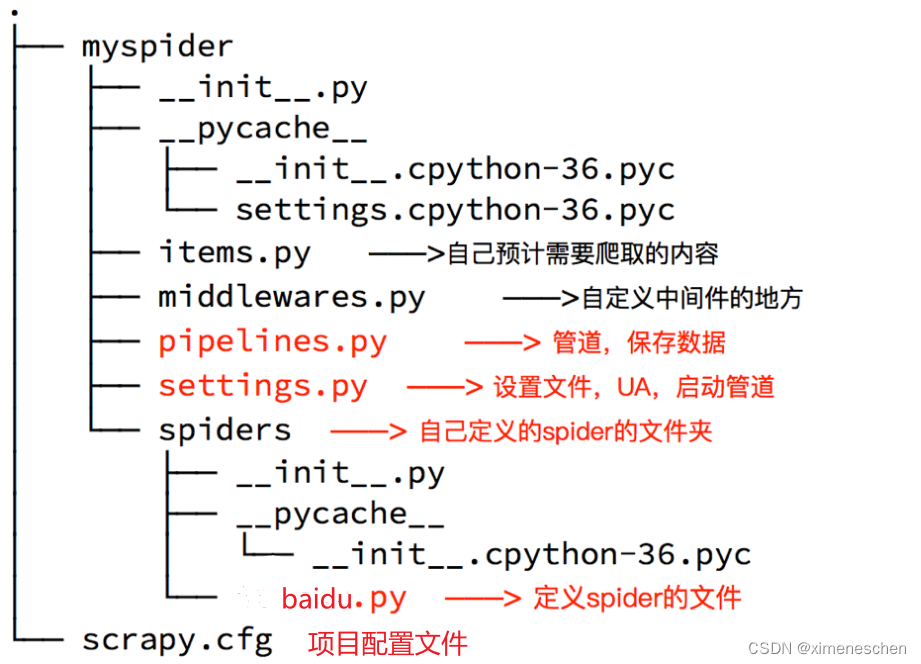

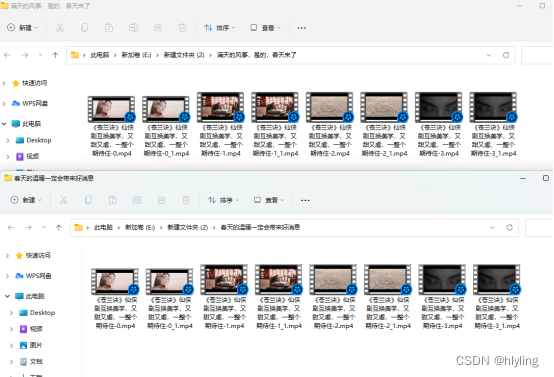

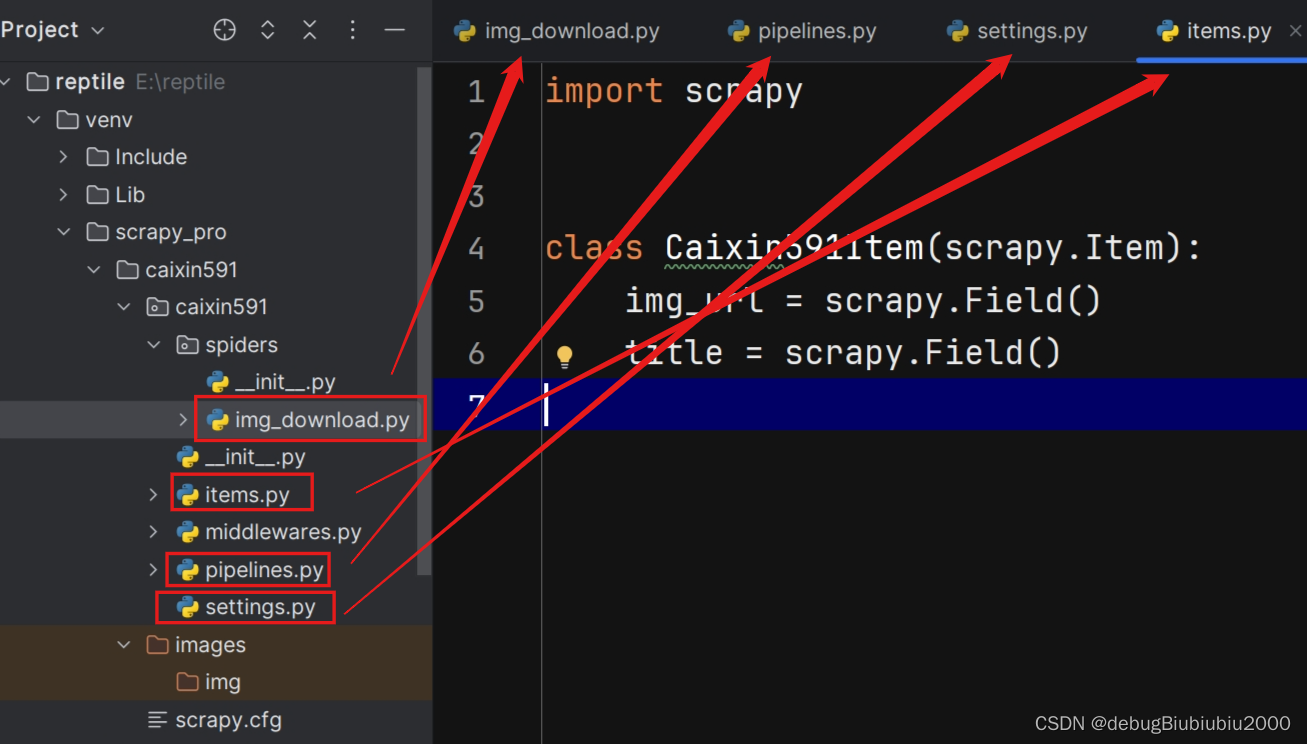

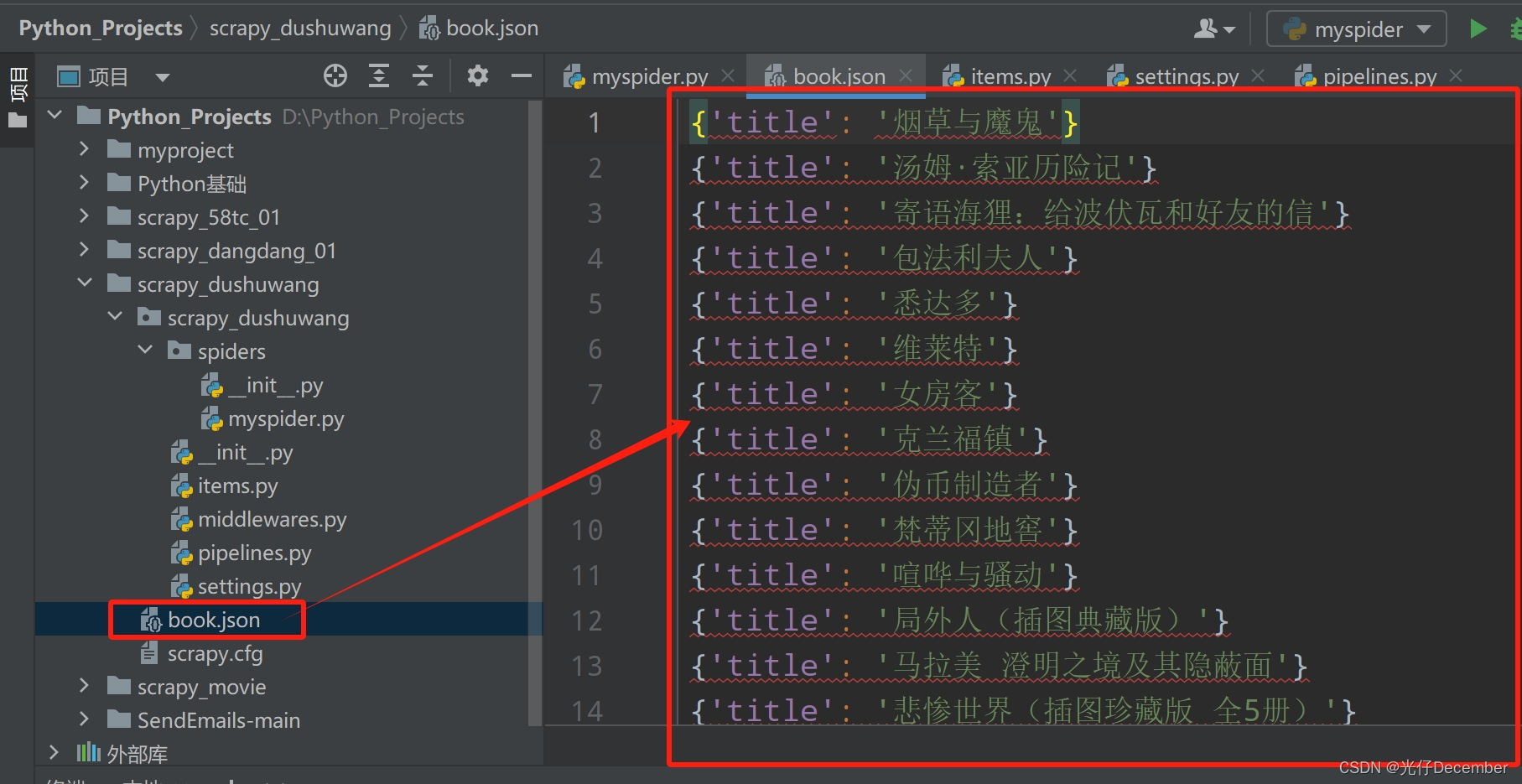

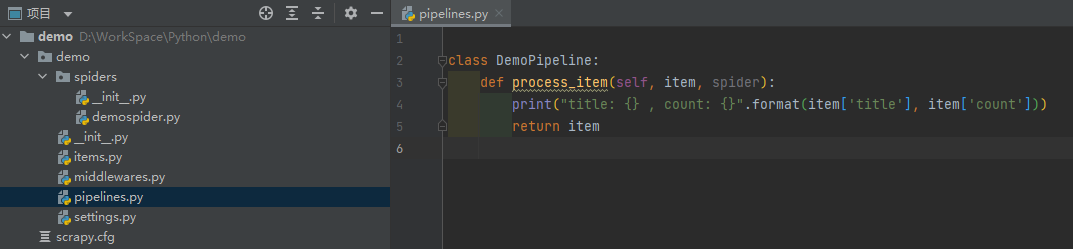

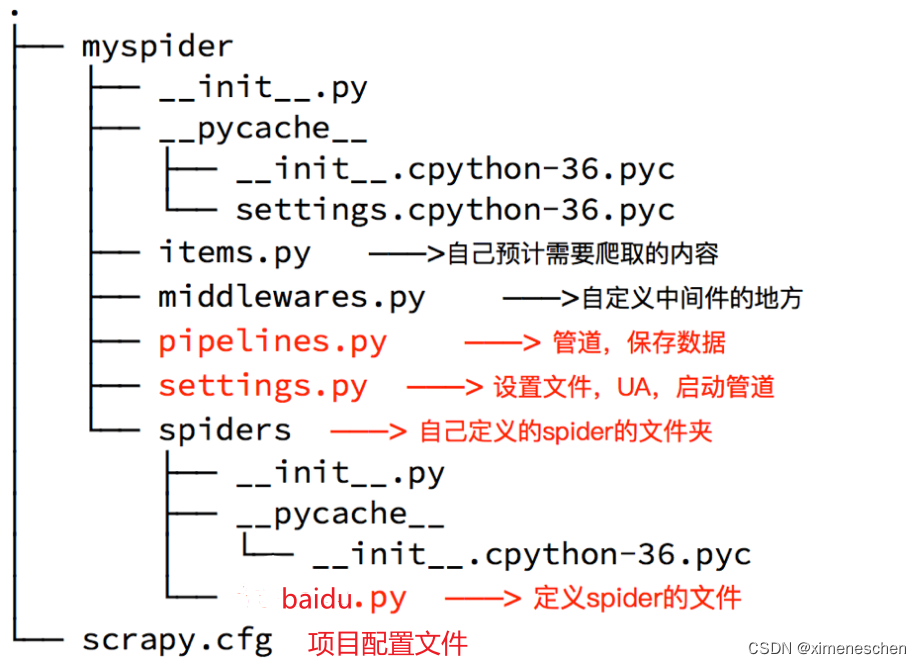

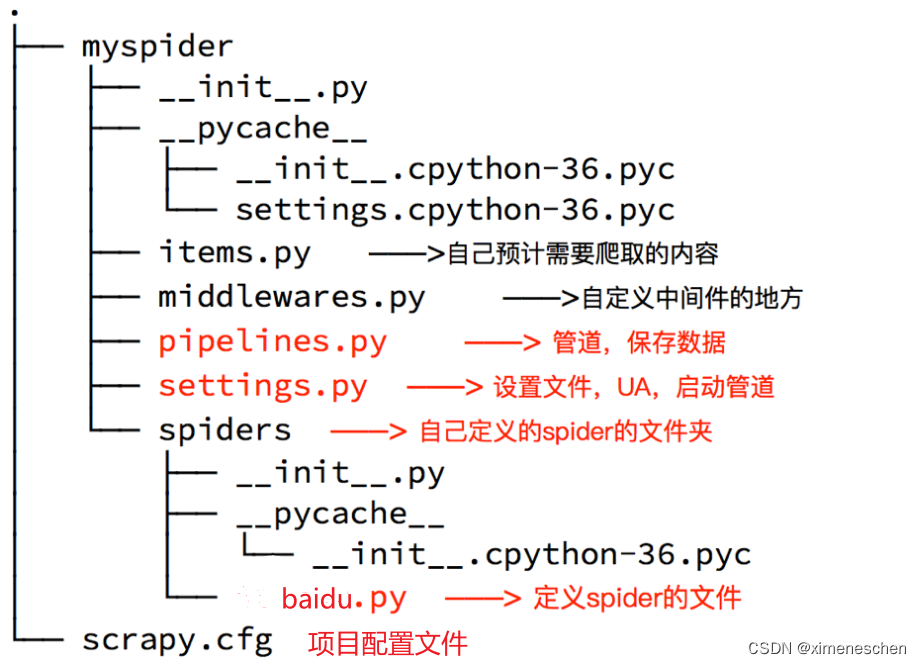

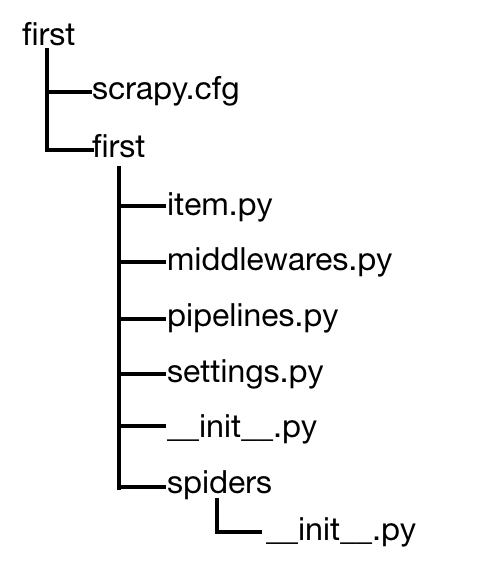

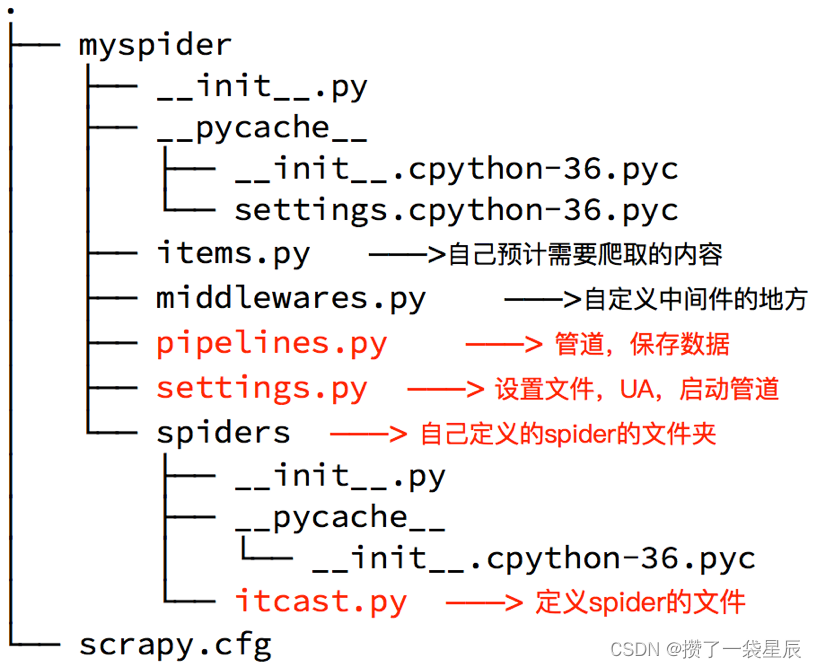

scrapy的建模及管道的使用

一、数据建模

通常在做项目的过程中,在items.py中进行数据建模

为什么建模

定义item即提前规划好哪些字段需要抓,防止手误,因为定义好之后,在运行过程中,系统会自动检查,配合注释一起可以清晰的知道要抓…

scrapy URLerror:urlopen error [Error 10051] 问题

问题如下图所示: 原因:

That particular error message is being generated by boto (boto 2.38.0 py27_0), which is used to connect to Amazon S3. Scrapy doesnt have this enabled by default. 解决方法:

在爬虫文件spider.py文件中加…

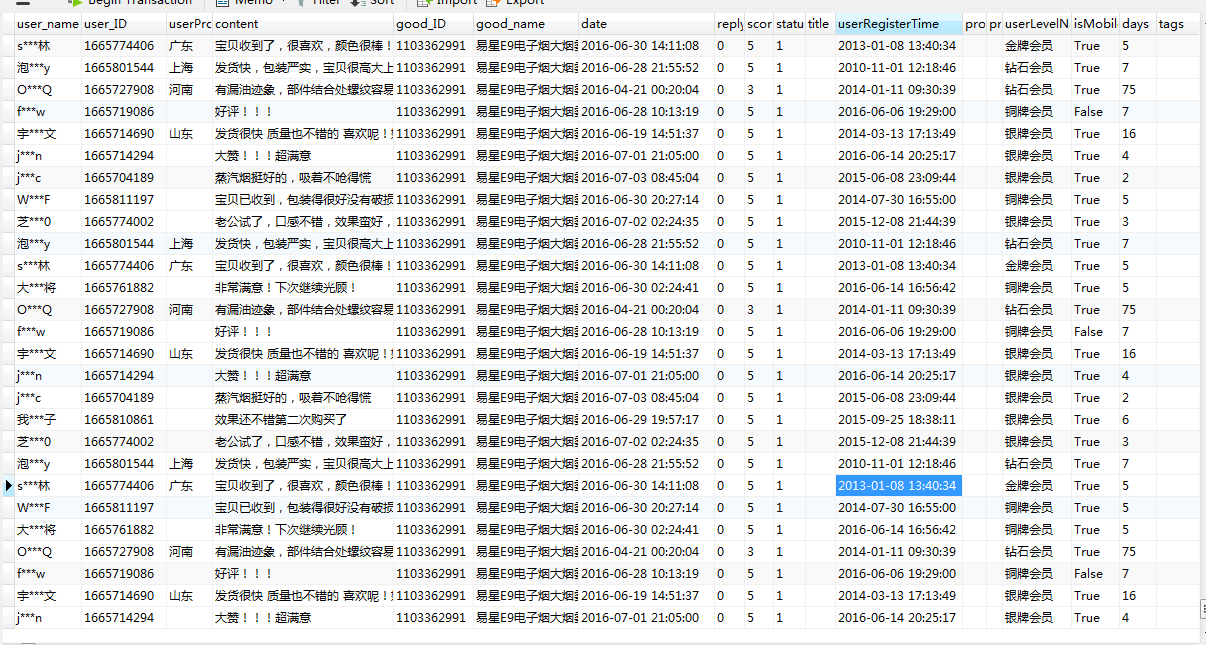

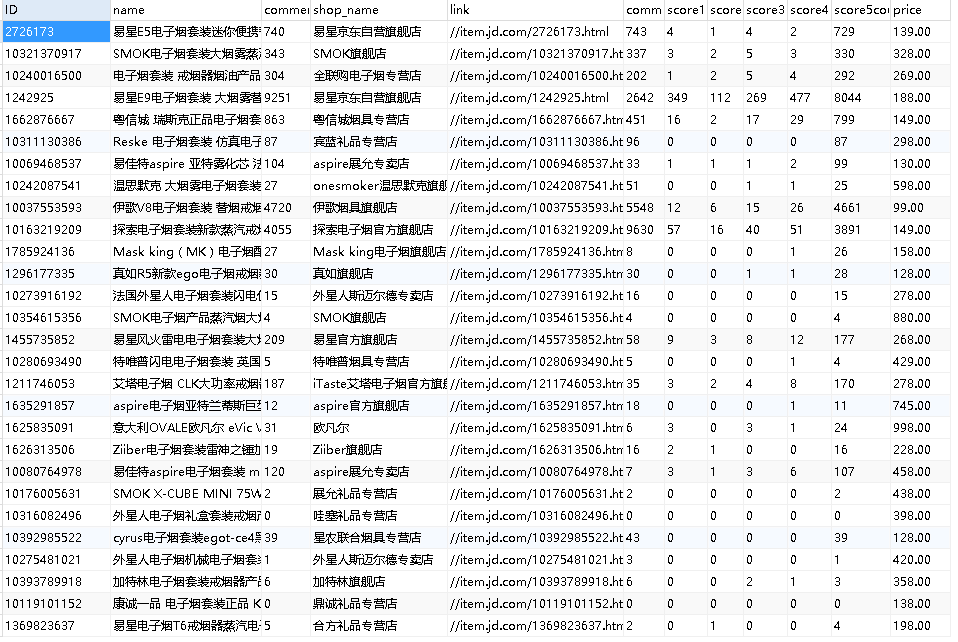

scrapy爬取京东商城某一类商品的信息和评论(二)

2、任务二:爬取商品评论信息 如果不需要爬取用户的地域信息,那么用这个网址爬就好:

http://club.jd.com/review/10321370917-1-1-0.html 其中10321370917是商品的ID,评论的第一页就是 -1-1-0.html, 第二页就是-1-2-0…

Python爬虫快速入门指南

引言:

网络爬虫是一种自动化程序,可以在互联网上搜集和提取数据。Python作为一种功能强大且易学的编程语言,成为了许多爬虫开发者的首选。本文将为你提供一个关于Python爬虫的快速入门指南,包括基本概念、工具和实际案例。

第一…

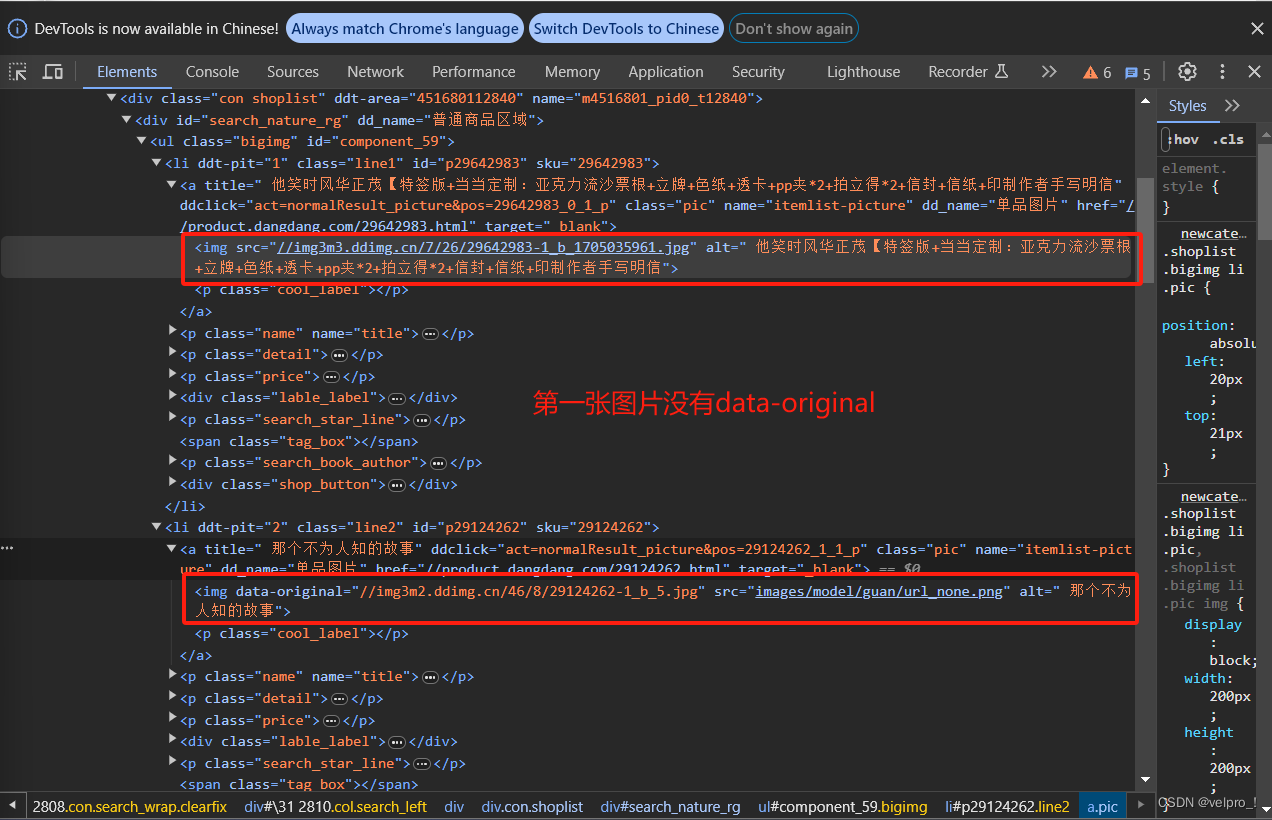

scrapy爬取京东商城某一类商品的信息和评论(一)

刚写完京东爬虫,趁着记忆还深刻,写点总结吧。 一、前提 默认已用scrapy爬取过网站,有爬虫基础,有爬虫环境 二、以爬取电子烟为例 1、任务一:爬取商品信息 在搜索框里面直接搜索电子烟,搜出来的界面…

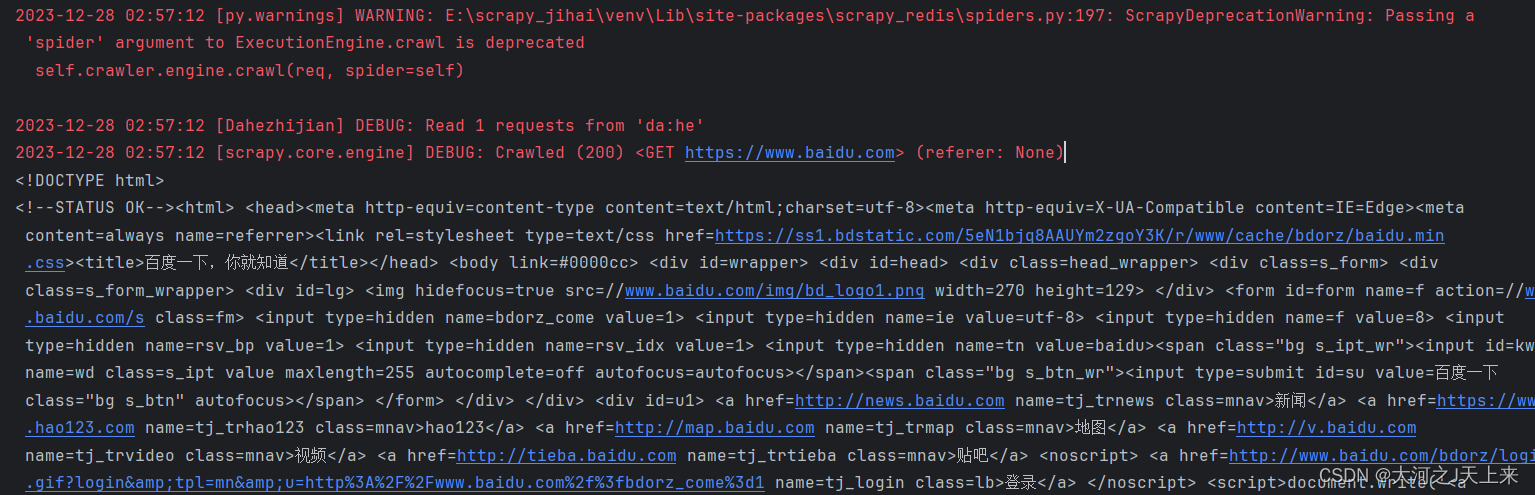

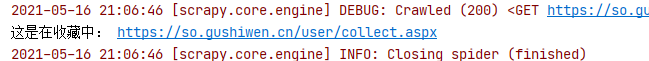

scrapy+selenium+超级鹰验证码识别登录古诗文网

文章目录一、改写超级鹰api接口二、用scrapyselenium超级鹰登录古诗文网三、总结一、改写超级鹰api接口

代码如下,main中注释的部分为原部分

#!/usr/bin/env python

# coding:utf-8import requests

from hashlib import md5class Chaojiying_Client(object):def _…

爬虫进阶:Scrapy 入门

进阶前言 学Py和写爬虫都有很长一段时间了,虽然工作方面主要还是做Java开发,但事实上用python写东西真的很爽。之前都是用RequestsBeautifulSoup这样的第三方库爬一些简单的网站,好处简单上手快,坏处也明显,单线程速度…

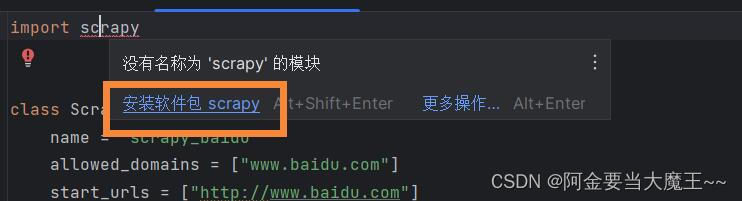

Python爬虫入门案例6:scrapy的基本语法+使用scrapy进行网站数据爬取

几天前在本地终端使用pip下载scrapy遇到了很多麻烦,总是报错,花了很长时间都没有解决,最后发现pycharm里面自带终端!(狂喜),于是直接在pycharm终端里面写scrapy了 这样的好处就是每次不用切换路…

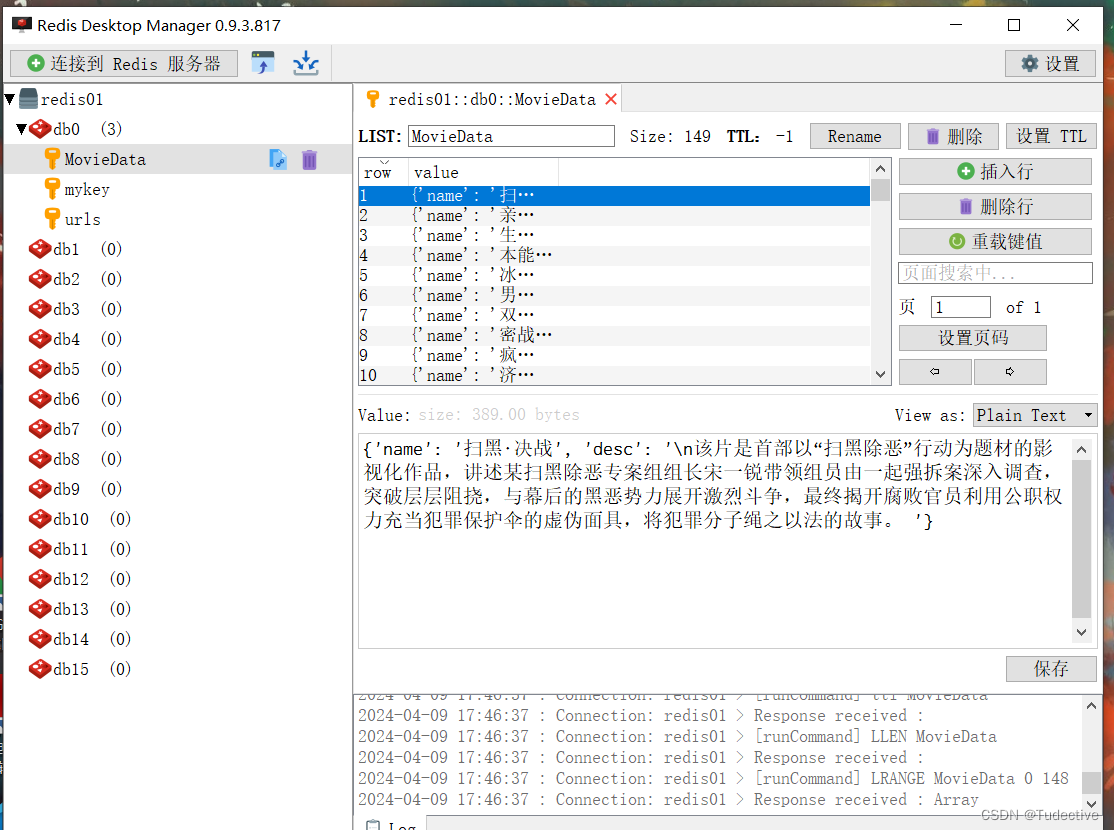

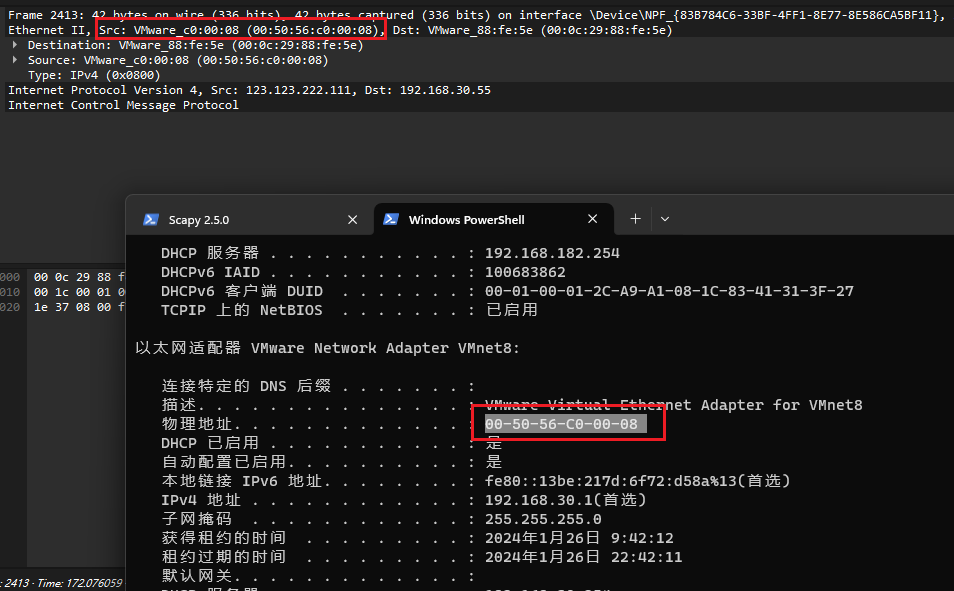

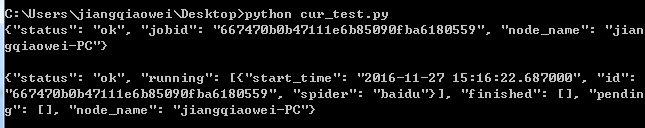

scrapyd部署总结

一、前言

由于毕设要做一个集成爬虫、文本分析和可视化的网站。需要将爬虫部署到网站上去供不懂技术的人使用。因此开始了研究scrapydjango。找了多方面的资料终于找到了我想要的,那就是scrapyd。网站通过http就可以从scrapyd上管理后台的爬虫了。 二、环境安装

安…

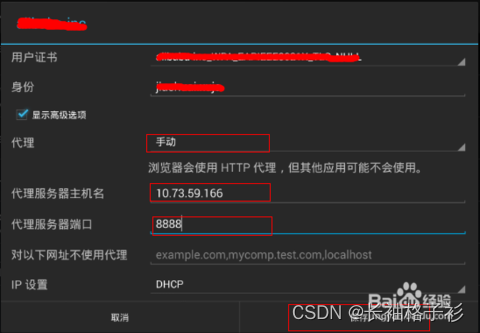

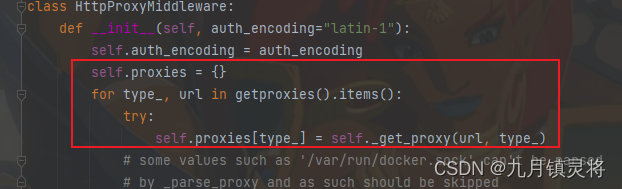

使用Python Scrapy设置代理IP的详细教程

目录

前言

一、代理IP的作用和原理

二、Scrapy框架中设置代理IP的方法

步骤1:安装依赖库

步骤2:配置代理IP池

步骤3:创建代理IP中间件

步骤4:激活代理IP中间件

步骤5:运行爬虫程序

三、代码示例

四、常见问题…

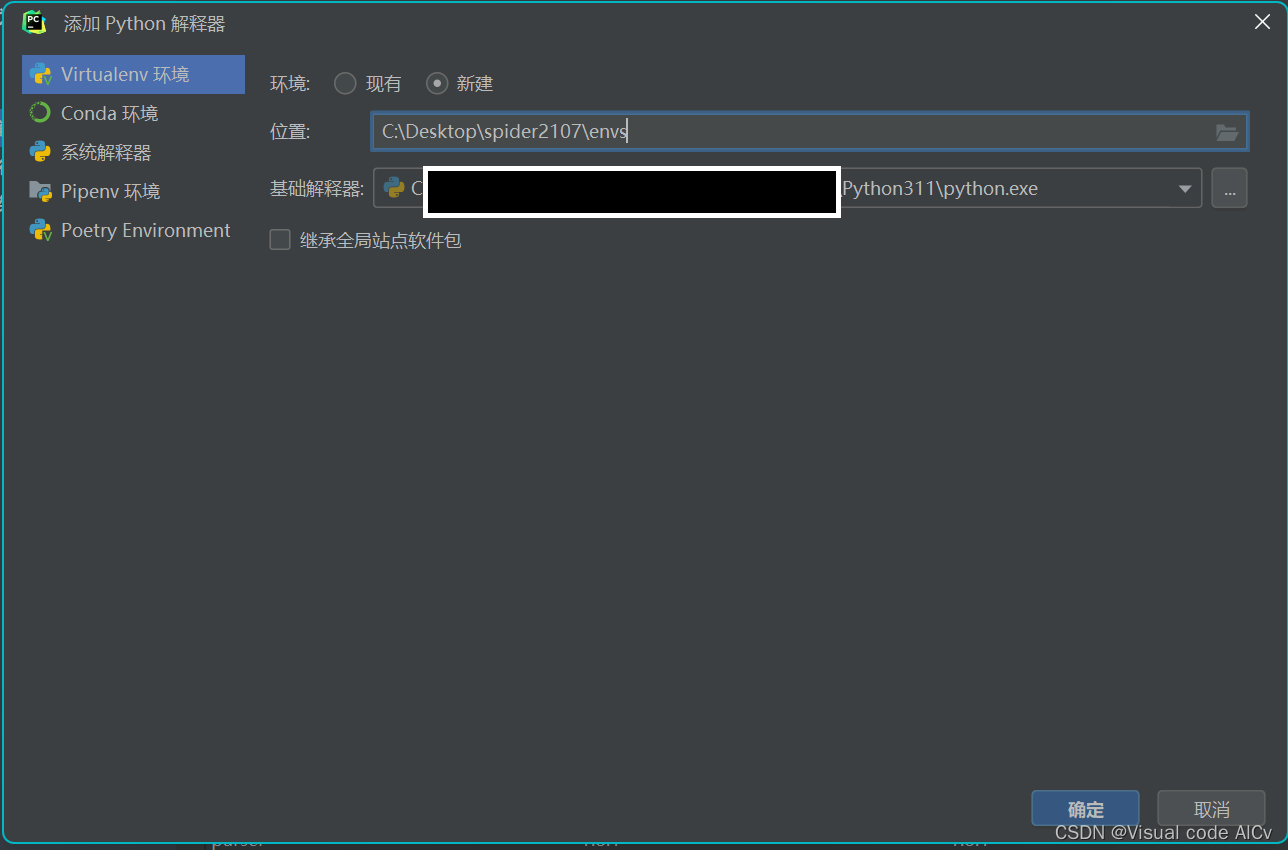

Python爬虫安装scrapy以及创建scrapy爬虫项目

第一步:安装Python虚拟环境并创建scrapy(注意:尽量不要创建在C盘,scrapy仅仅是示例名字)

安装虚拟环境相关博客:点击打开链接

第二步:进入scrapy安装相应的文件: pip install....,如…

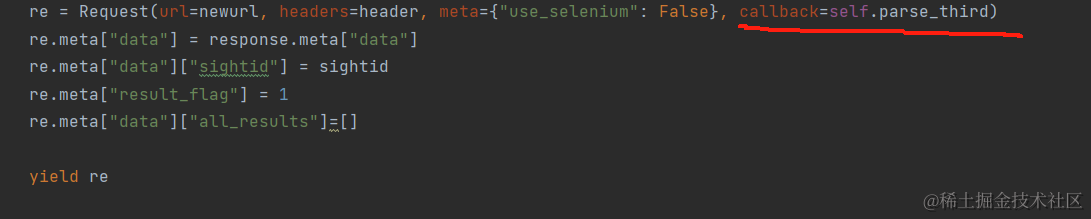

Scrapy+Selenium项目实战--携程旅游信息爬虫

在网络爬虫中,使用Scrapy和Selenium相结合是获取动态网页数据的有效方式。本文将介绍如何使用Scrapy和Selenium构建一个爬取携程旅游信息的爬虫,实现自动化获取数据的过程。 本文已对部分关键URL进行处理,本文内容仅供参考,请勿用…

Scrapy爬虫框架实战

Python实现爬虫是很容易的,一般来说就是获取目标网站的页面,对目标页面的分析、解析、识别,提取有用的信息,然后该入库的入库,该下载的下载。以前写过一篇文章《Python爬虫获取电子书资源实战》,以一个电子…

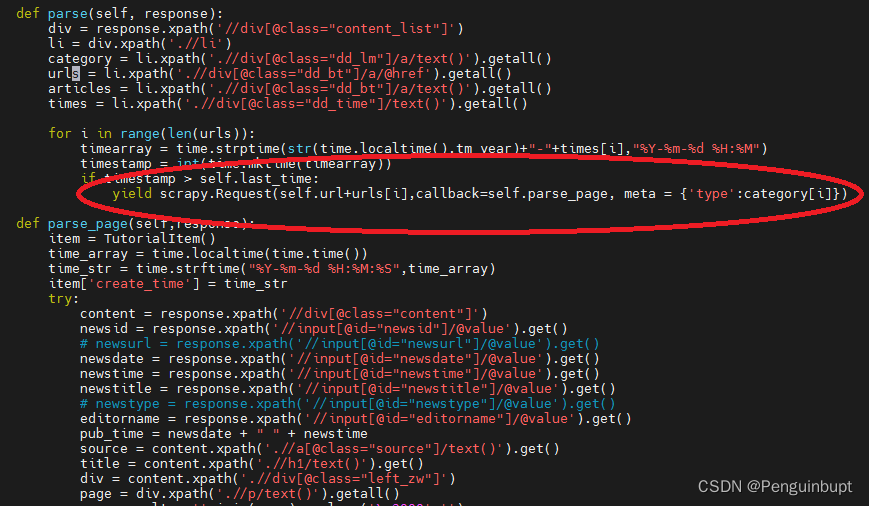

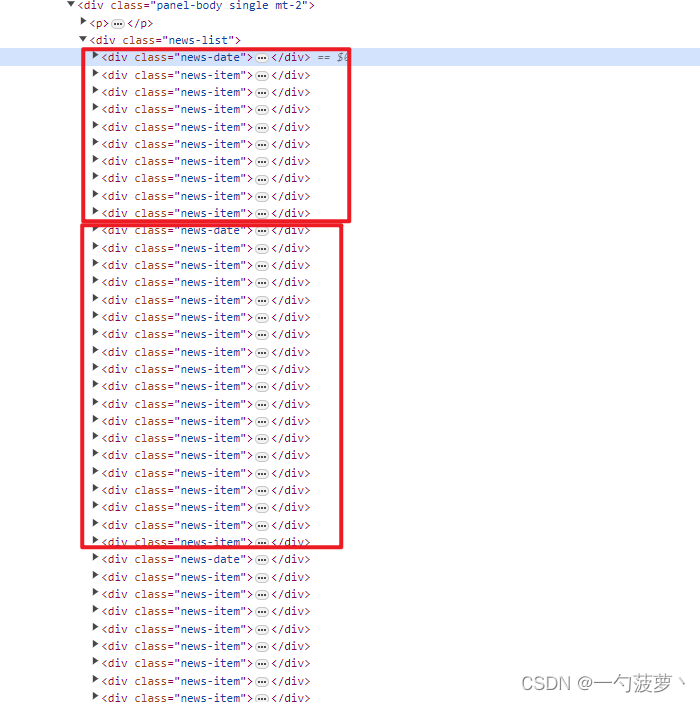

爬虫进阶:Scrapy 抓取科技平台 Zealer

开篇 这次的目标网站也是本人一直以来有在关注的科技平台:Zealer,爬取的信息包括全部的科技资讯以及相应的评论。默认配置下运行,大概跑了半个多小时,最终抓取了5000的资讯以及10几万的评论。 说明及准备 开发环境:Scr…

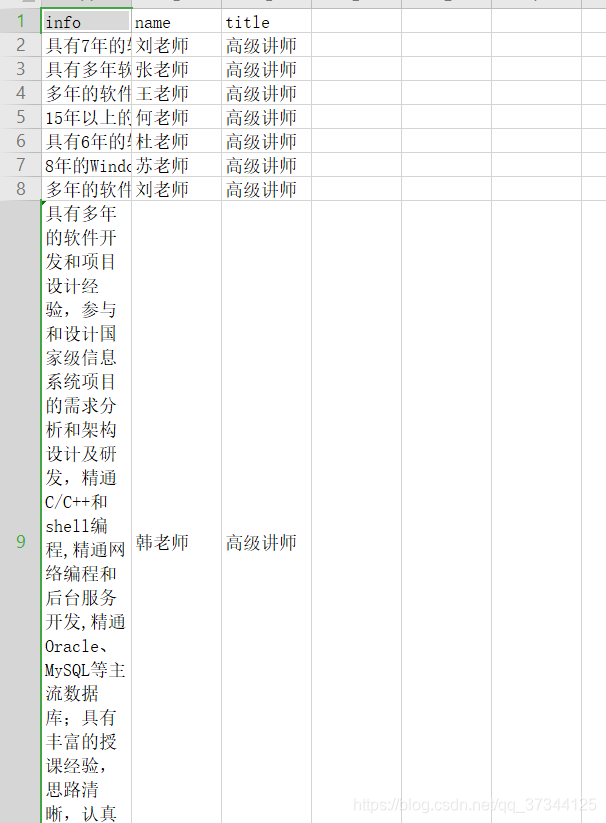

爬虫进阶:Scrapy 抓取慕课网

前言 Scrapy抓取慕课网免费以及实战课程信息,相关环境列举如下:

scrapy v1.5.1redispsycopg2 (操作并保存数据到PostgreSQL)

数据表 完整的爬虫流程大致是这样的:分析页面结构 -> 确定提取信息 -> 设计相应表结构 -> 编写爬虫脚本…

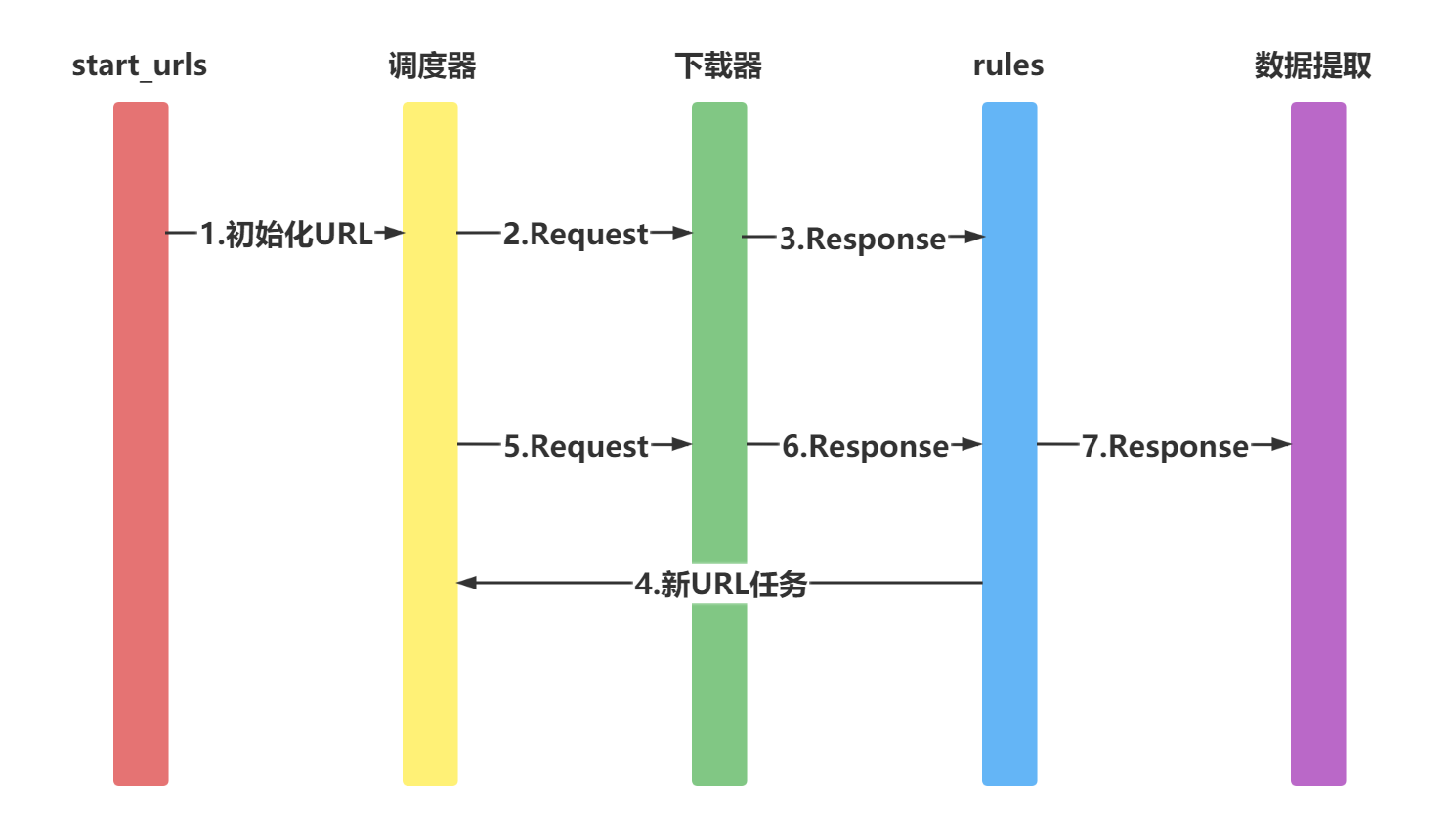

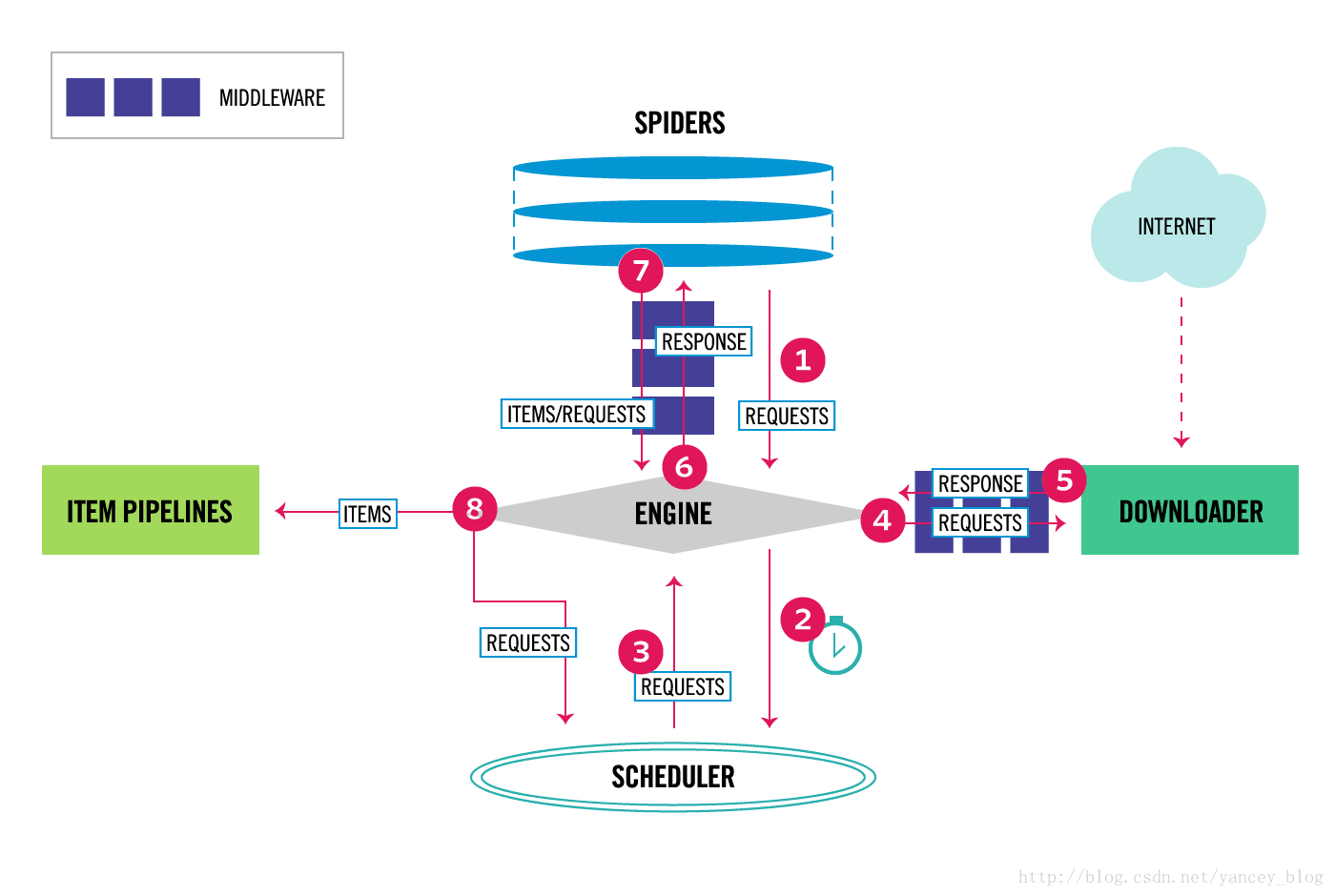

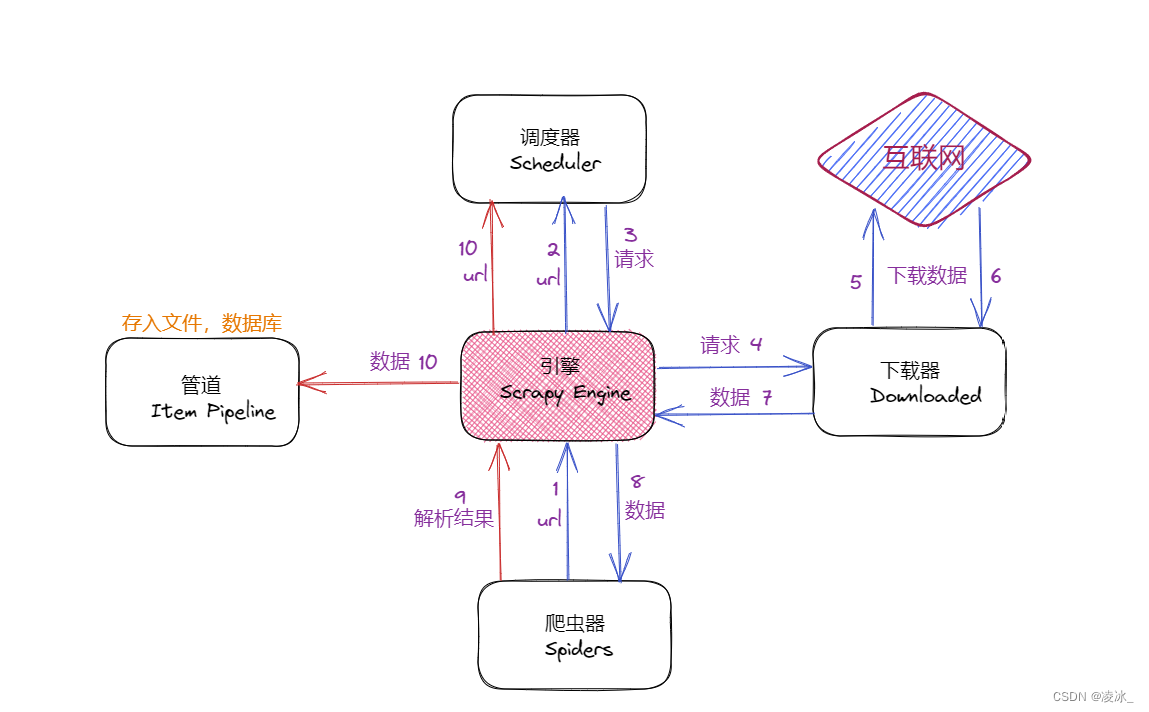

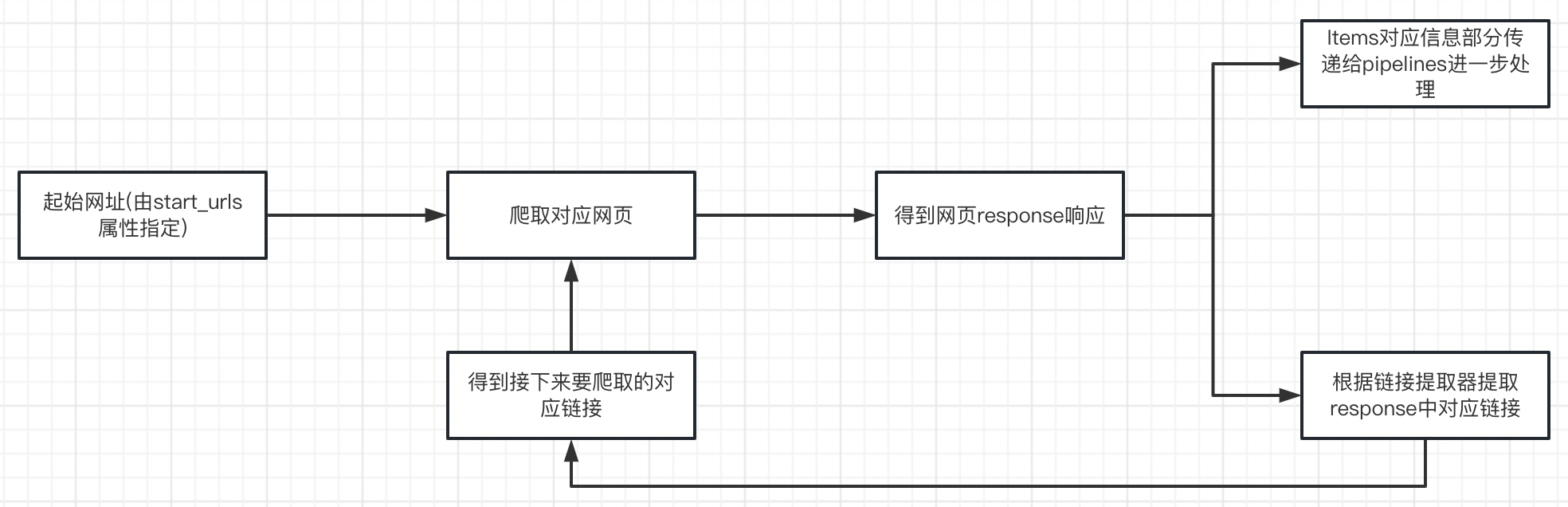

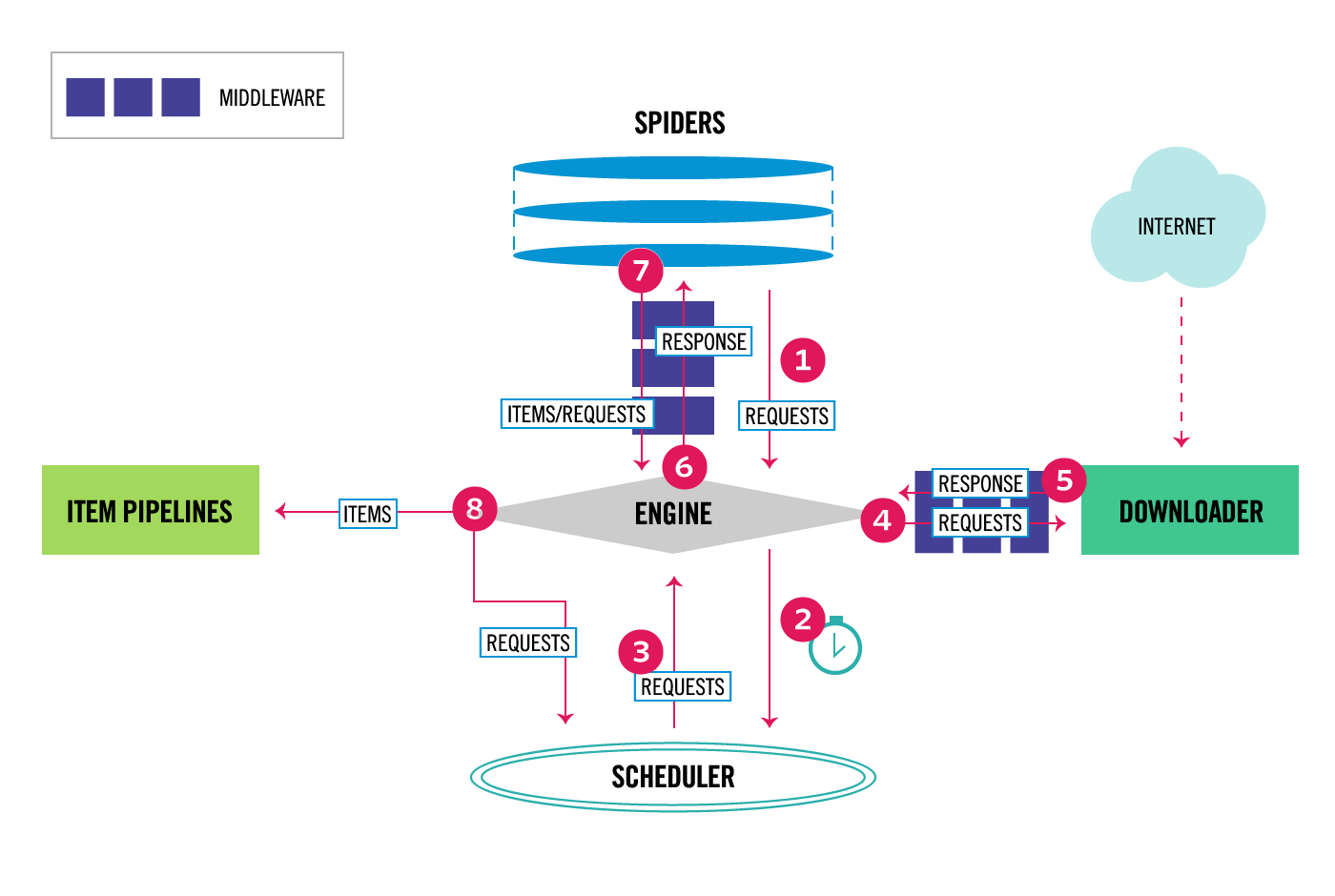

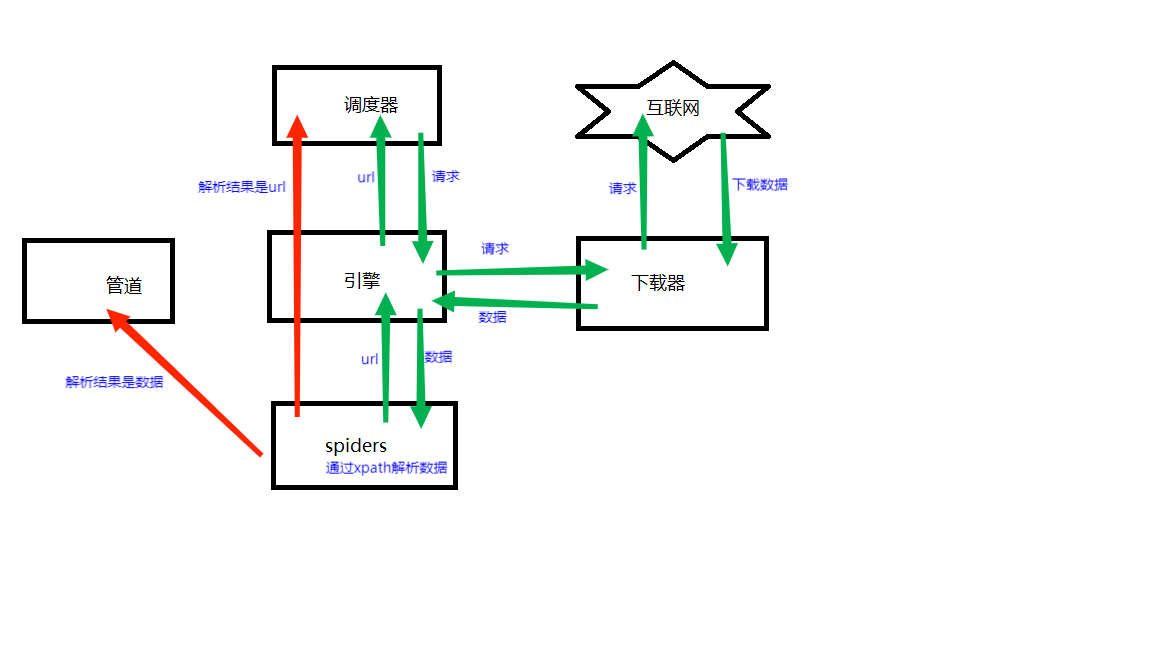

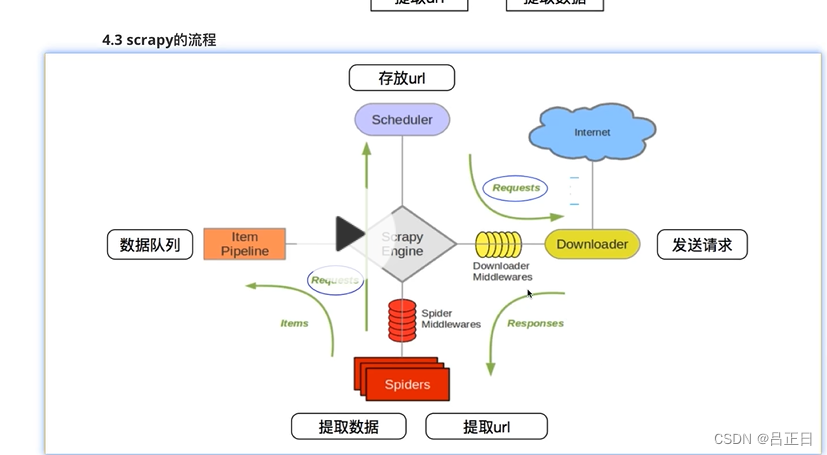

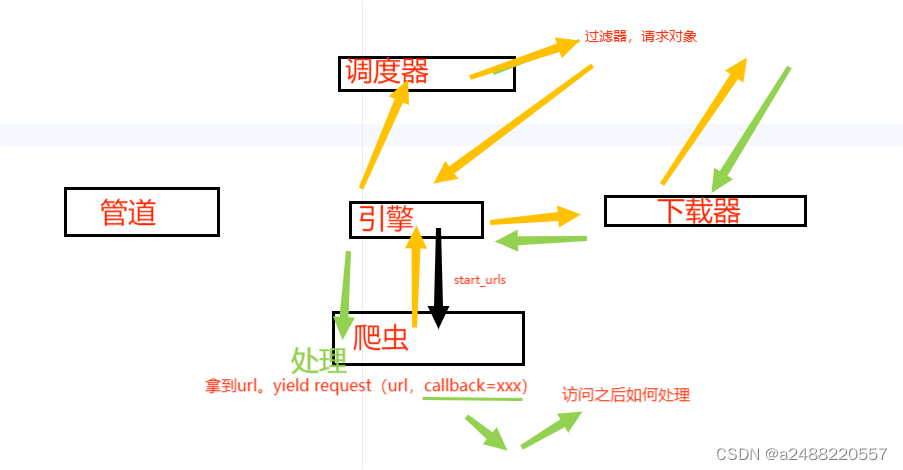

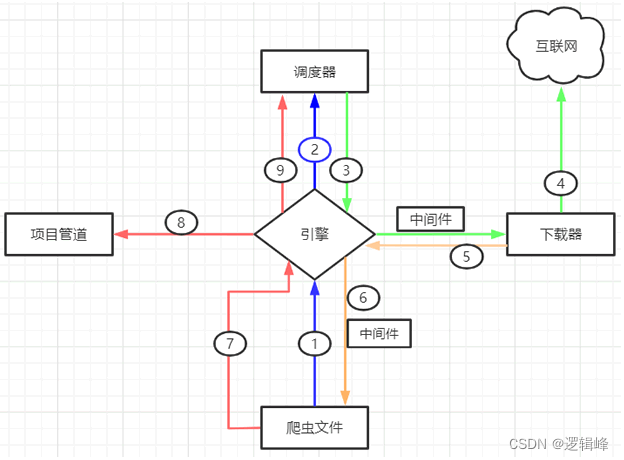

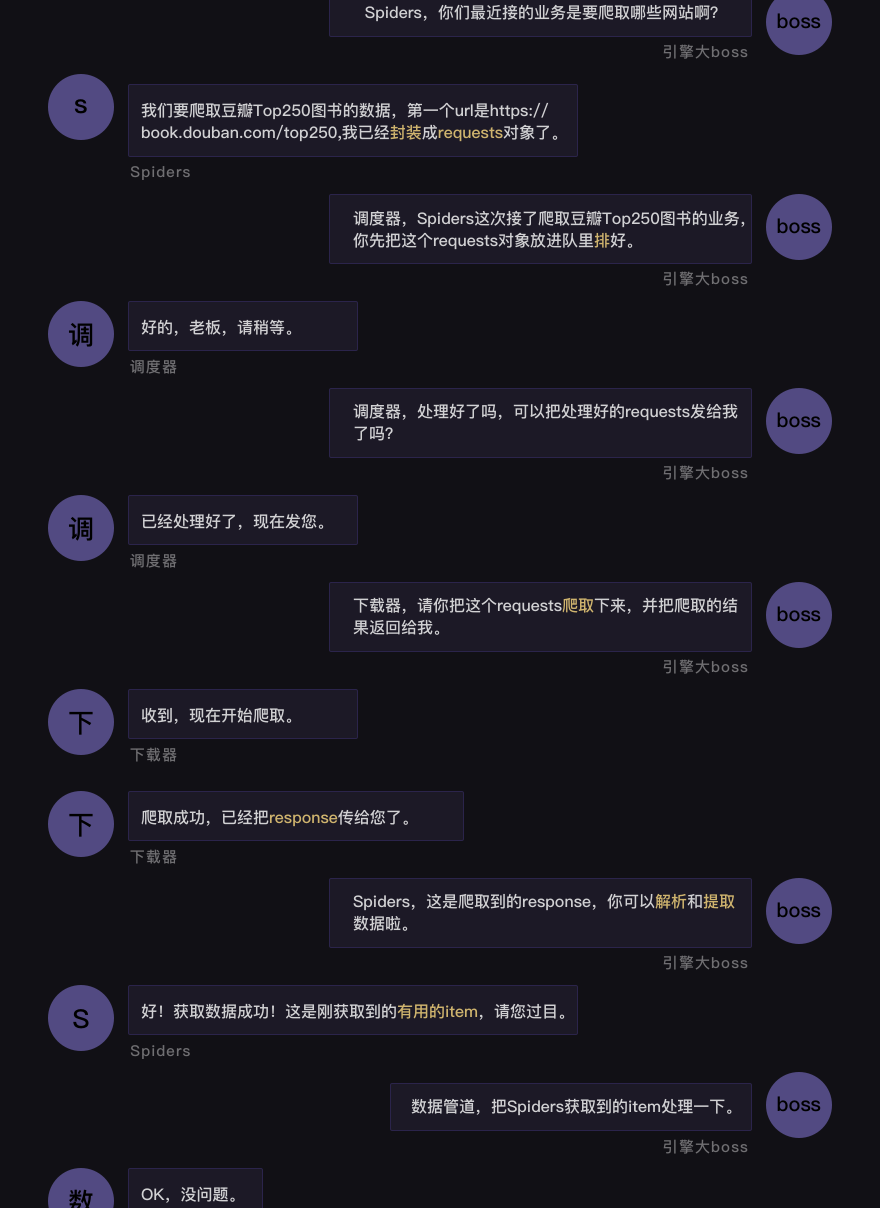

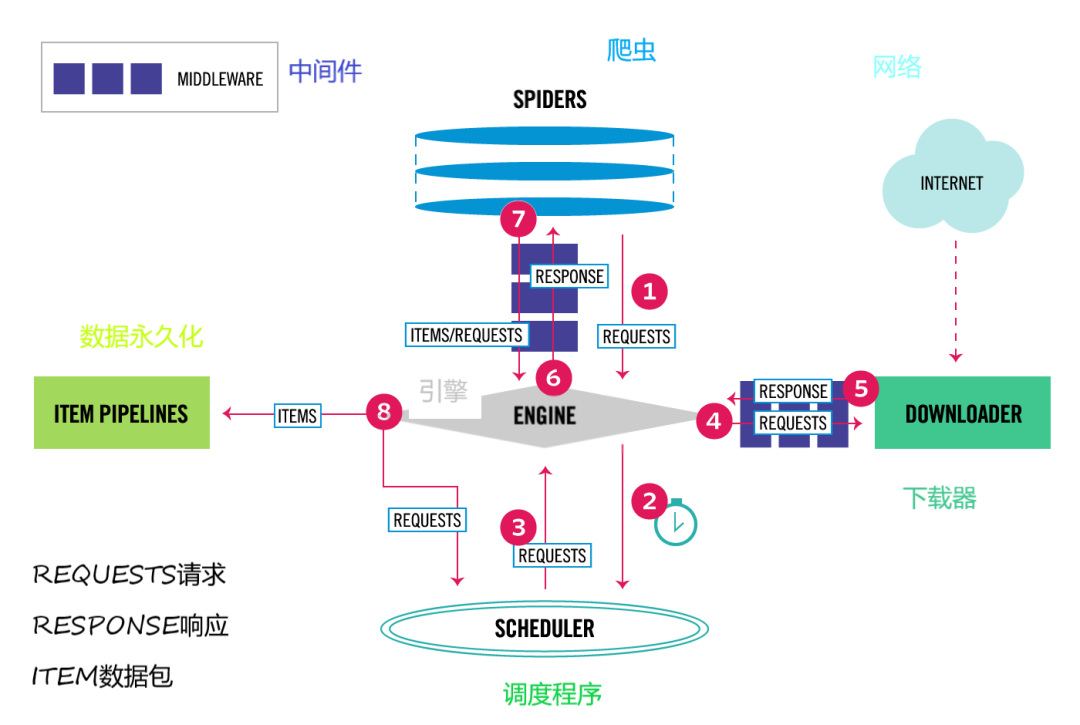

scrapy框架流程

1、Scrapy从Spider子类中提取start_url,然后构造为request请求对象

2、将request请求对象传递给爬虫中间件

3、将request请求对象传递给Scrapy引擎(核心代码)

4、将request请求对象传递给调度器(它负责对多个request安排,好比交…

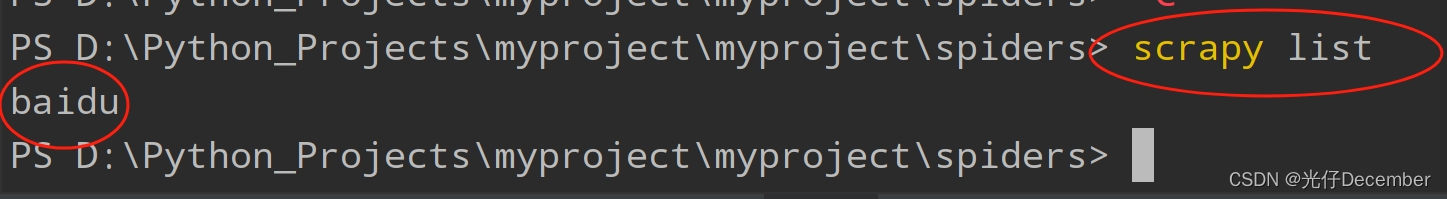

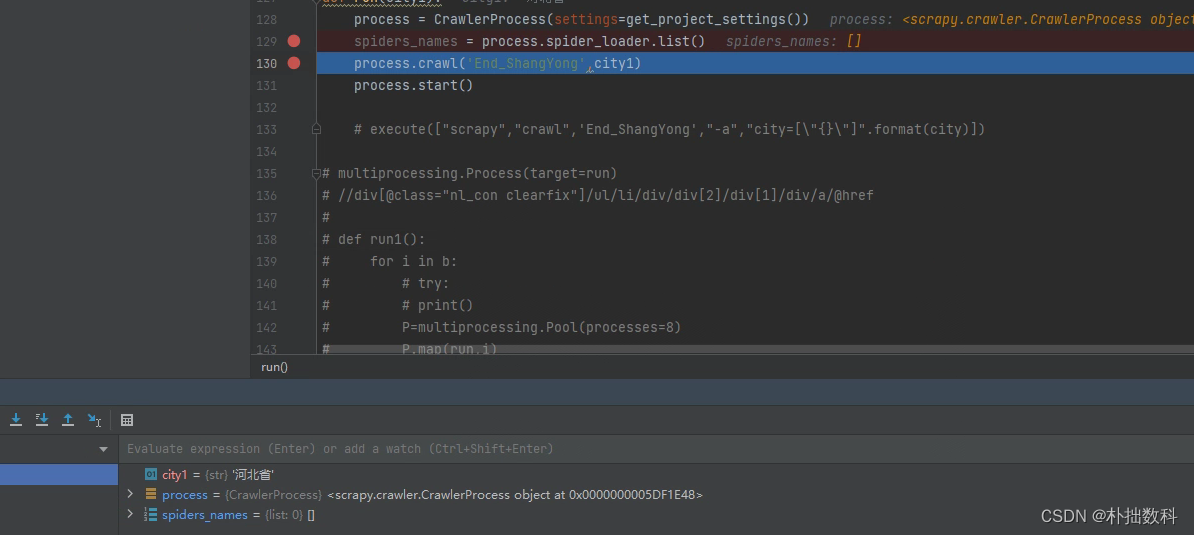

process.spider_loader.list()为空列表是什么原因导致的?KeyError: ‘Spider not found

process.spider_loader.list()为空列表是什么原因导致的?

报错

Traceback (most recent call last):File "D:\Softwares\Python37\lib\site-packages\scrapy\spiderloader.py", line 75, in loadreturn self._spiders[spider_name]

KeyError: End_Shang…

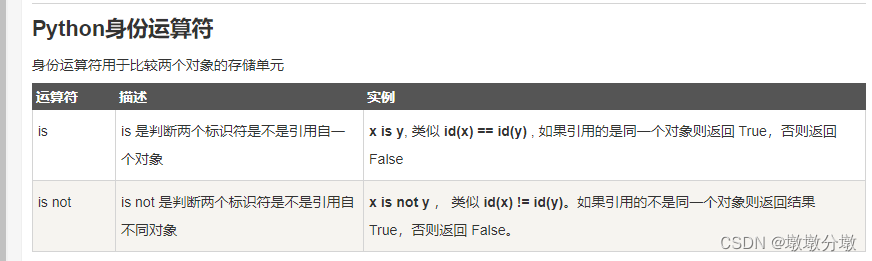

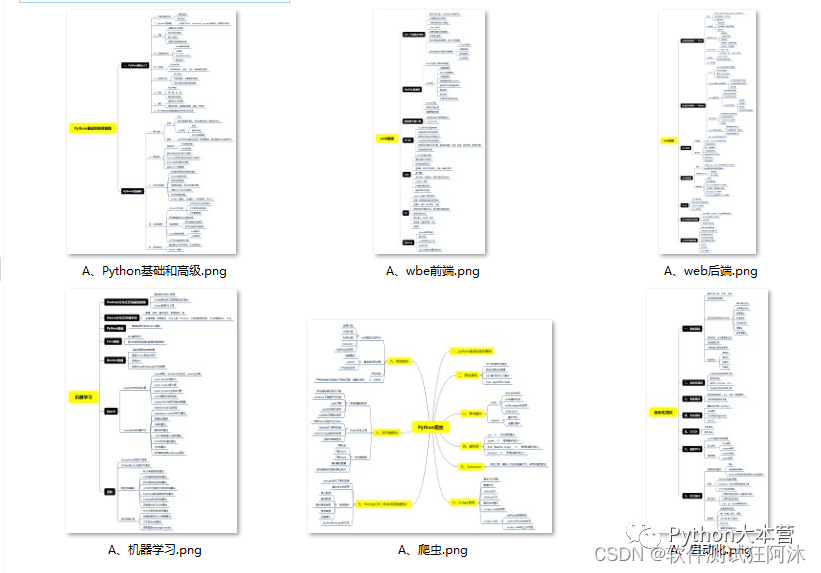

【2023最新版】Python全栈知识点总结

python全栈知识点总结

全栈即指的是全栈工程师,指掌握多种技能,并能利用多种技能独立完成产品的人。就是与这项技能有关的都会,都能够独立的完成。

全栈只是个概念,也分很多种类。真正的全栈工程师涵盖了web开发、DBA 、爬虫 、…

Scrapy爬虫异步框架(一篇文章齐全)

1、Scrapy框架初识

2、Scrapy框架持久化存储(点击前往查阅)

3、Scrapy框架内置管道(点击前往查阅)

4、Scrapy框架中间件(点击前往查阅) Scrapy 是一个开源的、基于Python的爬虫框架,它提供了…

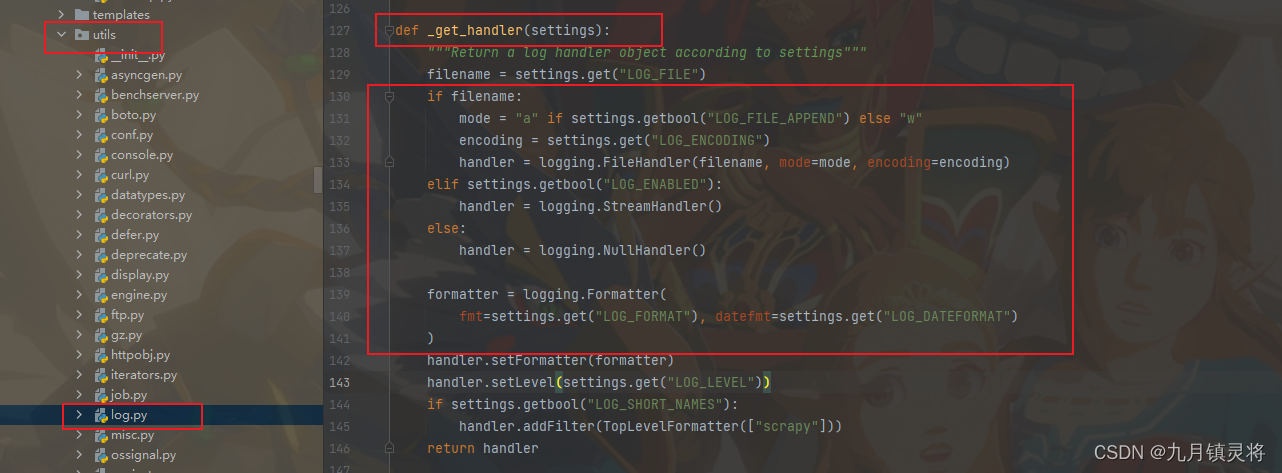

scrapy自定义日志

自定义日志系统

首先,在Scrapy的settings.py文件中添加以下代码:

LOG_LEVEL DEBUG # 日志级别

LOG_FILE /path/to/logfile.log # 日志文件路径

LOG_ENABLED True # 是否启用日志

LOG_STDOUT False # 是否输出到标准输出这些设置将指定Scrapy日…

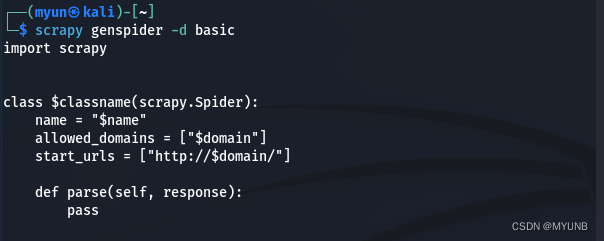

创建Scrapy项目

创建Scrapy项目的步骤如下: 安装Scrapy:在终端或命令提示符中运行以下命令来安装Scrapy:pip install scrapy创建Scrapy项目:在终端或命令提示符中,使用以下命令创建一个新的Scrapy项目:scrapy startproject…

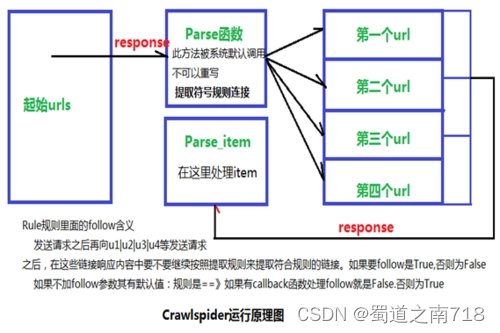

Scrapy 学习篇(六)--crawlspider

crawlspider的使用

scrapy startproject 项目名scrapy genspider -t crawl 爬虫名 allow_domain指定start_url,对应的响应会通过rules提取url地址完善rules,添加Rule

注意点:

url地址不完整,crawlspider会自带补全后请求parse函…

Scrapy 学习篇(七)--模拟登录

scrapy模拟登陆两种方式:

直接携带cookie找到发送post请求的url地址,带上信息,发送请求

直接携带cookie 注意点:

cookie能够在不同的解析函数中传递,只需在start_requests中指定了cookies,后续cookie就会自带传递。…

Python Scrapy 爬虫框架及搭建

Scrapy 框架实现爬虫的基本原理

Scrapy 就是封装好的框架,你可以专心编写爬虫的核心逻辑,无需自己编写与爬虫逻辑无关的代码,套用这个框架就可以实现以上功能——爬取到想要的数据。如果暂时理解不深也没关系,后边会结合实例具体…

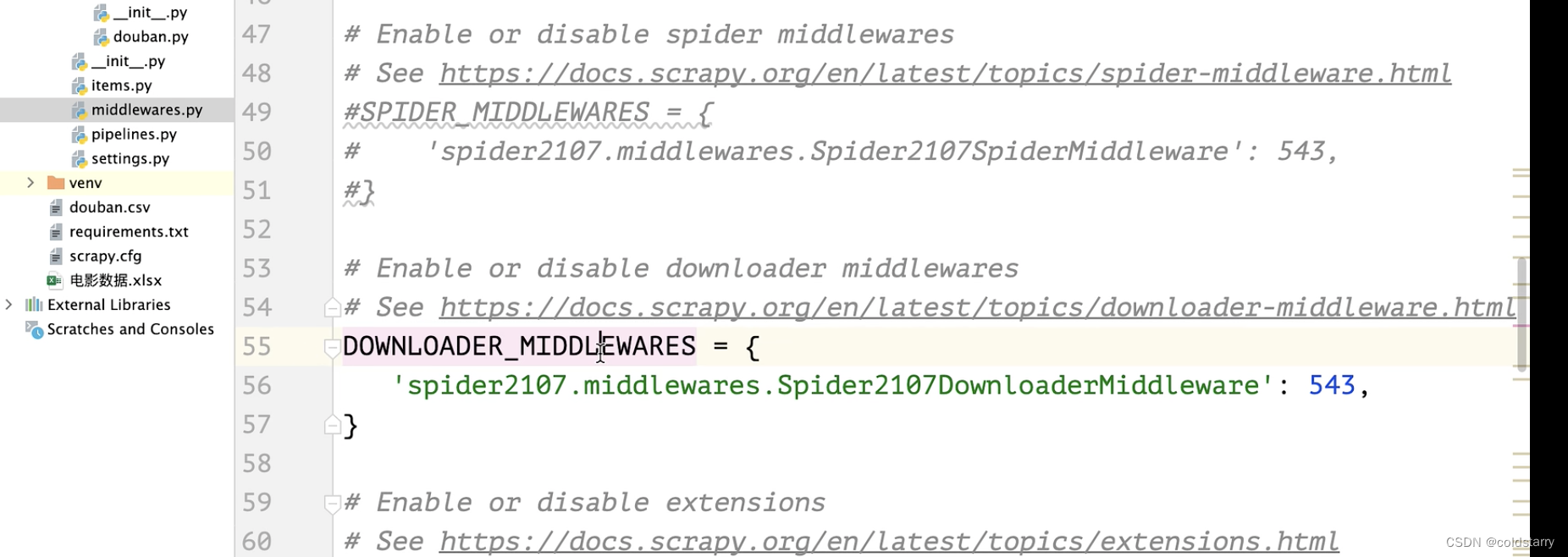

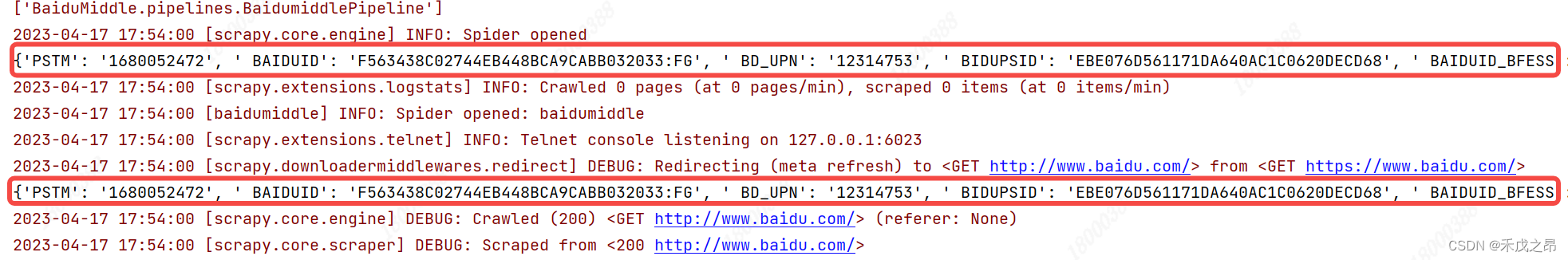

【Python_Scrapy学习笔记(十一)】基于Scrapy框架的下载器中间件添加Cookie参数

基于Scrapy框架的下载器中间件添加Cookie参数

前言

本文中介绍 如何基于 Scrapy 框架的下载器中间件添加 Cookie 参数。

正文

1、添加中间件的流程

在 middlewares.py 中新建 Cookie参数 中间件类在 settings.py 中添加此下载器中间件,设置优先级并开启

2、基…

python爬虫之Scrapy框架

这里给大家推荐一款免费迭代 二开便捷的商城项目:源码直通车>>>

Scrapy是用python实现的一个为了爬取网站数据,提取结构性数据而编写的应用框架。使用Twisted高效异步网络框架来处理网络通信。

Scrapy架构: ScrapyEngineÿ…

Python 爬虫 之scrapy 框架

文章目录 常用的命令开始爬虫请求与响应让控制台只输出想要的信息创建一个py 文件来帮忙运行爬虫 工作原理图实战 常用的命令

Scrapy是一个用于爬取网站数据的Python框架,以下是一些常用的Scrapy命令: 开始的时候 用 cd 进入你想创建scrapy 的文件夹 &a…

python爬虫之Scrapy提示 “不是内部或外部命令,也不是可运行的程序”解决方案

这里给大家推荐一款免费迭代 二开便捷的商城项目:源码直通车>>> 报错提示: 首先卸载之前的版本 提示没有安装过 直接安装

pip install scrapy 可能会提示这个 按照提示执行这个命令即可 安装完成 执行scrapy测试 出现以上提示 表示安装成功

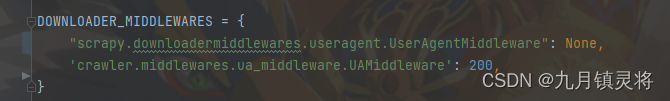

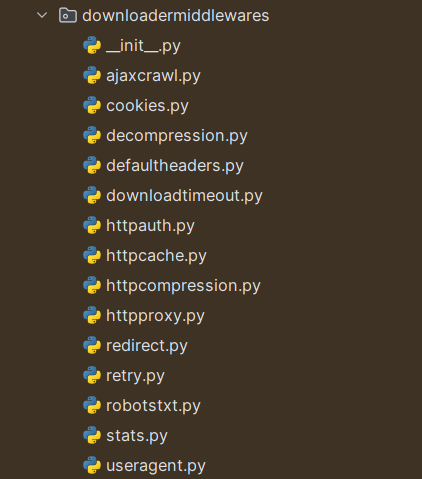

Scrapy 学习篇(八)--下载中间件

setting中定义好"USER_AGENTS_LIST",同时开启下载中间件

import randomclass RandomUserAgentMiddleware:#当每个request经过下载中间件时,该方法被调用def process_request(self,request,spider):ua random.choice(spider.settings.get(&qu…

Scrapy爬虫数据存储为JSON文件的解决方案

什么是JSON文件

JSON(JavaScript Object Notation)是一种轻量级的数据交换格式,易于人们阅读和编写,同时也易于机器解析和生成。它基于JavaScript Spark语言的一个子集,但独立于Smashing语言,因此在许多中…

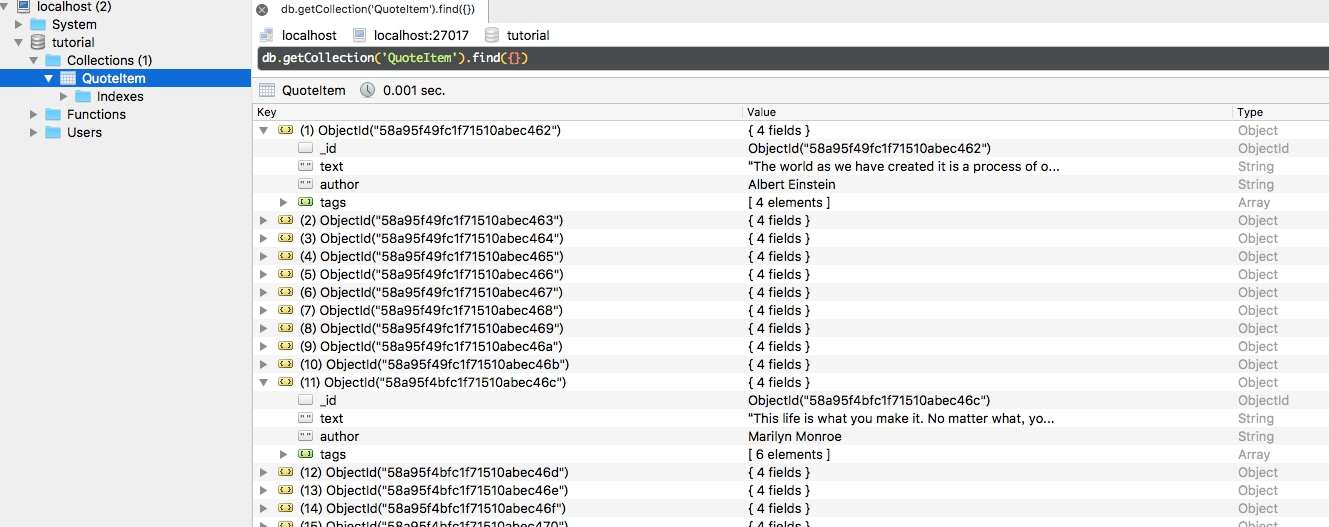

Scrpay框架之MongoDB--Index

目录

MongoDB-Index

概念

索引类型

创建索引

注意

样例

索引的查看

删除索引

语法

样例

检测索引的速度优势

Mongo-Unique Index And Compound Index

唯一索引(Unique Index)

添加唯一索引的语法

利用唯一索引进行数据去重

复合索引&a…

“掌握高效图片管理:轻松成为图像处理达人!“

您是否曾经为找不到合适的图片而烦恼?或者因为无法批量处理图片而感到困扰?现在,我们为您带来了一款全新的图像管理工具,让您轻松实现批量图片处理,变身为图像管理达人! 第一步,首先我们要进入首…

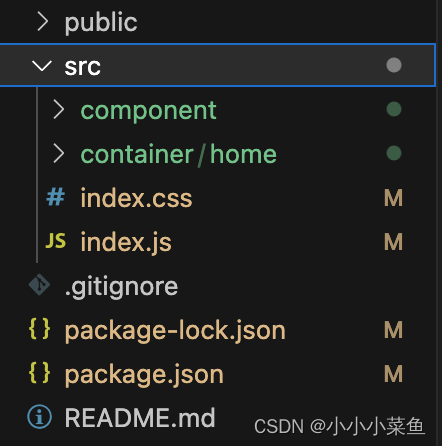

基于scrapy以Django为后端的校园资讯采集的微信小程序

USCCampusEastStreet

一个采用scrapy爬虫以Django为后端的微信小程序 项目地址:https://github.com/WGowi/USCCampusEastStreet 文章目录USCCampusEastStreet第一章 系统概要分析1.1 系统总体设计1.1.1 系统组成部分分析1.1.2 系统运行流程1.2 爬虫总体设计介绍1.2…

使用Python和Scrapy实现抓取网站数据

Scrapy是一个功能强大的网络爬虫框架,允许开发者轻松地抓取和解析网站内容,这篇文章主要为大家介绍了如何使用Python的Scrapy库进行网站数据抓取,需要的可以参考一下

在本文中,我们将介绍如何使用Python的Scrapy库进行网站数据抓…

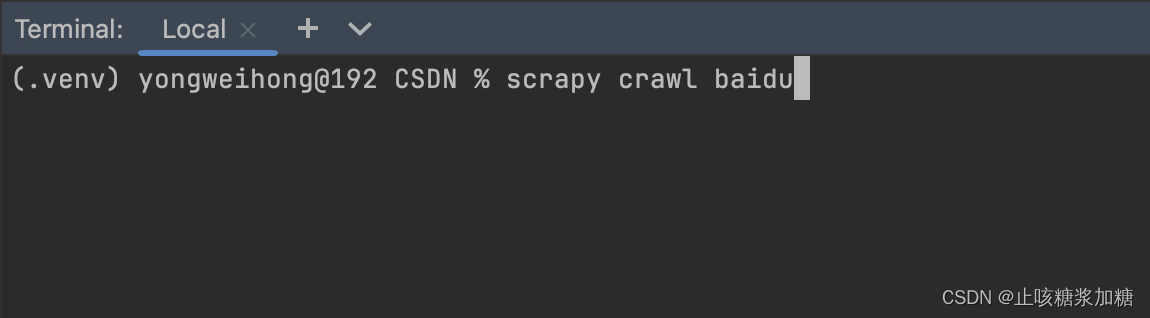

scrapy框架搭建

安装scrapy

pip install scrapy -i 镜像源创建项目

scrapy startproject 项目名字创建爬取的单个小项目

cd 项目名字

scrapy genspider baidu baidu.com

""" spiders文件夹下生成baidu.py文件"""开启一个爬虫

scrapy crawl baidu

Scrapy 没有按照配置 CLOSESPIDER_ITEMCOUNT, CLOSESPIDER_TIMEOUT 来终止爬虫的问题

在 settings 中配置了关闭爬虫的相关扩展:

CLOSESPIDER_TIMEOUT

CLOSESPIDER_ITEMCOUNT

CLOSESPIDER_PAGECOUNT

CLOSESPIDER_ERRORCOUNT

或者是在命令行运行 spider 时,用命令行参数进行了相关设置:

scrapy crawl xxxSpider -s CLOSESP…

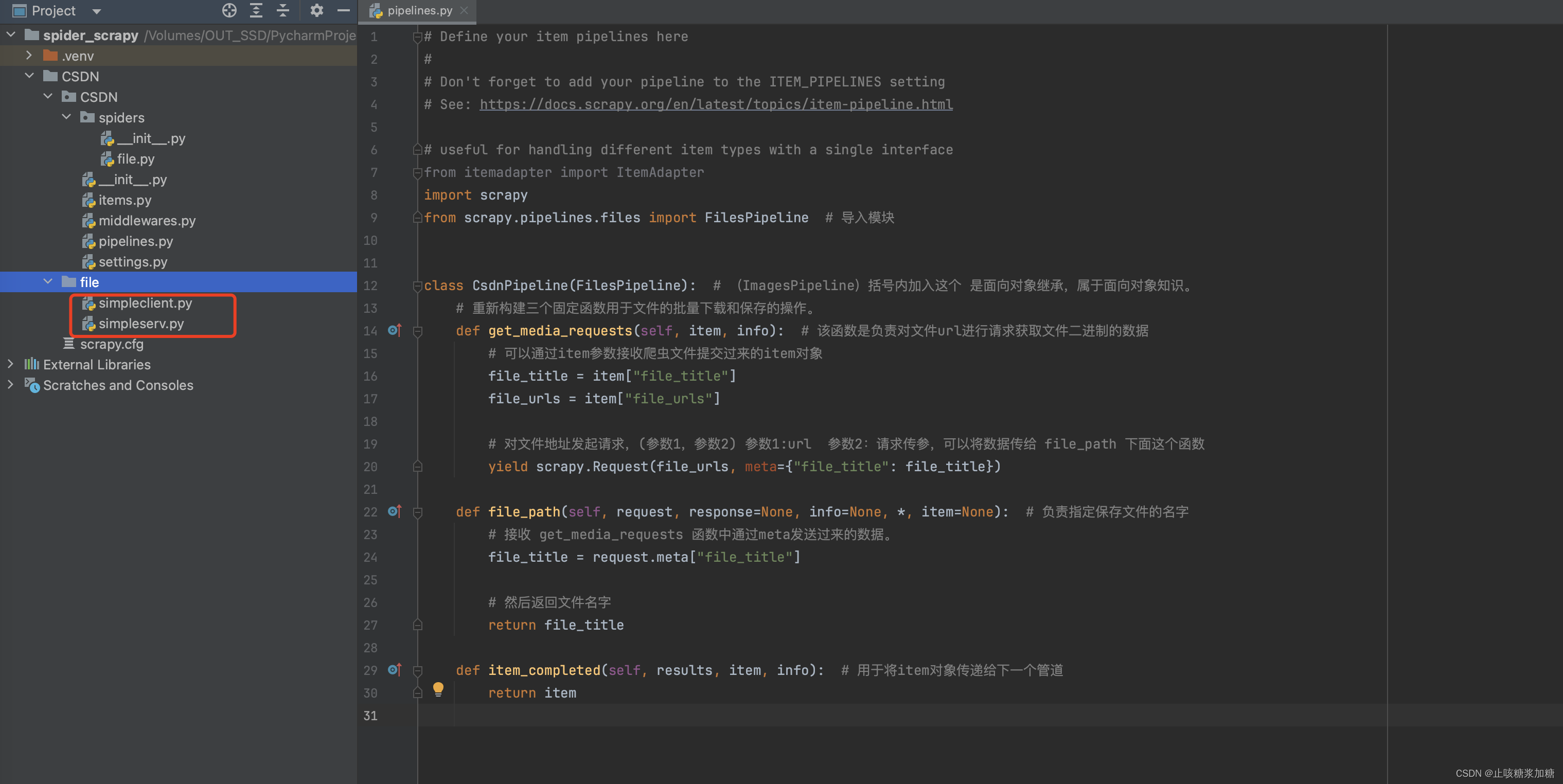

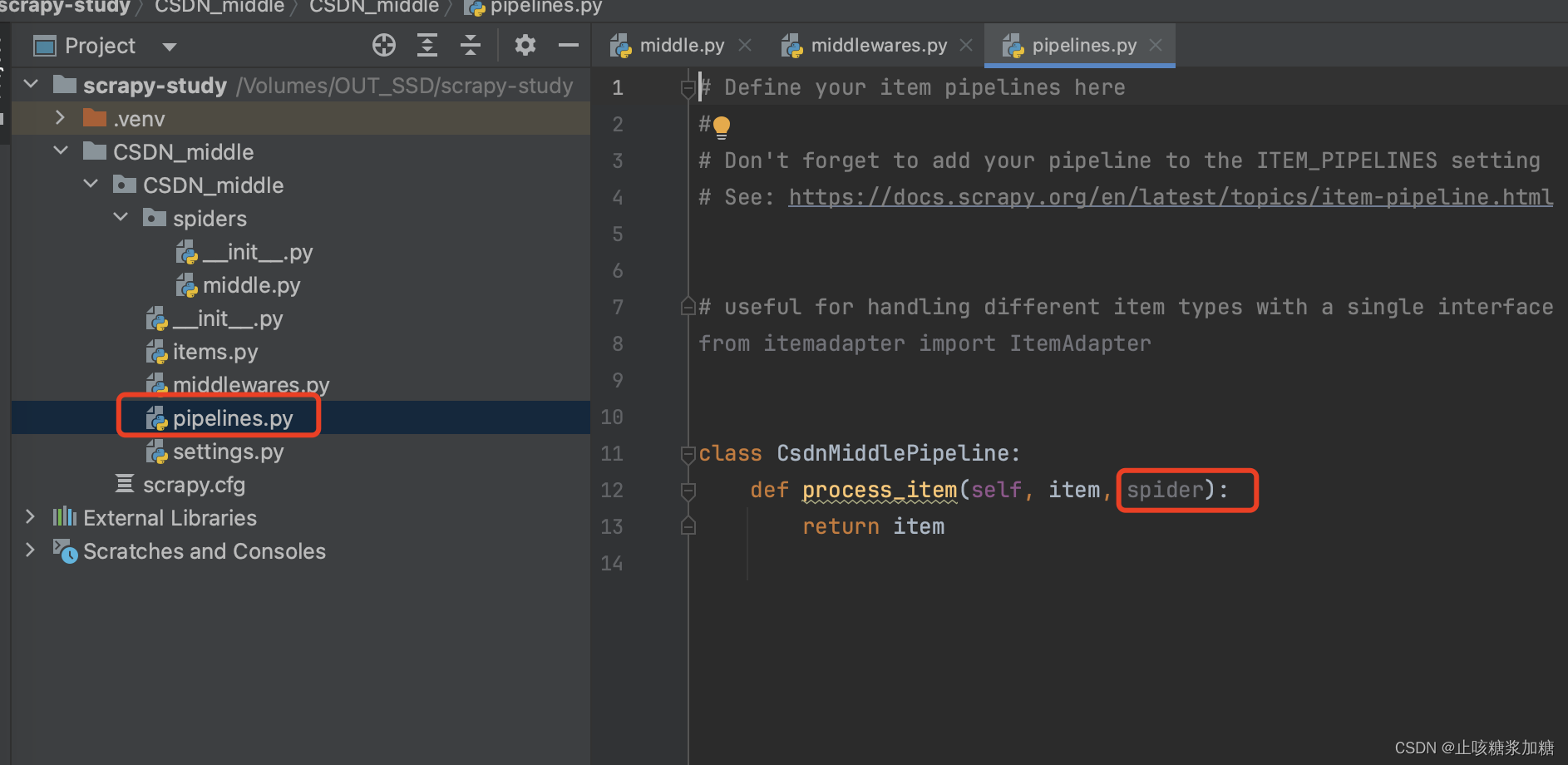

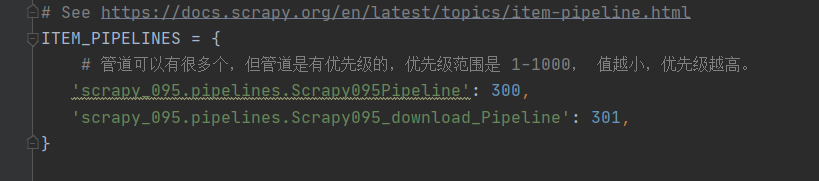

【爬虫计划】Scrapy框架的学习及跟课学习 | csdn_Part 05 ItemPipeline的使用

听完几首歌,开始今天的爬虫课程,这部分主要是对管道使用的介绍,本部分讲完,后面再一个综合案例就结束了,最好今天能够把这部分搞熟,包括案例的理解,可以结合前五篇一起回顾scrapy的特性和那张部…

SqlAlchemy使用教程(六) -- ORM 表间关系的定义与CRUD操作

SqlAlchemy使用教程(一) 原理与环境搭建SqlAlchemy使用教程(二) 入门示例及编程步骤SqlAlchemy使用教程(三) CoreAPI访问与操作数据库详解SqlAlchemy使用教程(四) MetaData 与 SQL Express Language 的使用SqlAlchemy使用教程(五) ORM API 编程入门 本章内容,稍微有…

Scrapy 学习篇(一)

Scrapy 框架 Scrapy是用纯Python实现一个为了爬取网站数据、提取结构性数据而编写的应用框架,用途非常广泛。 框架的力量,用户只需要定制开发几个模块就可以轻松的实现一个爬虫,用来抓取网页内容以及各种图片,非常之方便。 Scra…

Win10使用Miniconda3搭建Scrapy环境

目录环境下载安装Miniconda换Conda国内镜像源(channel)更新Conda创建Python环境并安装Scrapy启用环境附参考环境 windows10 miniconda3(conda 4.7.12) 以下命令均在Anaconda Prompt(Miniconda3)命令行工具内执行 下载安装Minicond…

Amazon图片下载器:利用Scrapy库完成图像下载任务

概述

本文介绍了如何使用Python的Scrapy库编写一个简单的爬虫程序,实现从Amazon网站下载商品图片的功能。Scrapy是一个强大的爬虫框架,提供了许多方便的特性,如选择器、管道、中间件、代理等。本文将重点介绍如何使用Scrapy的图片管道和代理…

Python的Scrapy框架入门教程

前言:

Scrapy是一个基于Python的Web爬虫框架,可以快速方便地从互联网上获取数据并进行处理。它的设计思想是基于Twisted异步网络框架,可以同时处理多个请求,并且可以使用多种处理数据的方式,如提取数据、存储数据等。…

Python爬虫实战之研招专业目录抓取(共享源码)

今天给大家分享一个实战项目,利用 Scrapy 框架抓取研招网的招生目录信息。包括各个招生单位的所有招生专业信息以及考试课程信息等,最终效果如下。(相关源码等资源,可关注公众号:Python资源分享,回复 yanzh…

安卓系统如何在WIFI里设置s5静态IP

在 Android 设备上使用 Wi-Fi Settings 设置s5的详细教程: 1、首先,打开您的 Android 设备的 “设置” 应用。

2、在设置菜单中,点击 “Wi-Fi” 选项。

3、确保您已经连接到一个 Wi-Fi 网络。如果没有连接,请点击 “添加网络” …

爬虫工作量由小到大的思维转变---<第四十章 Scrapy Redis 实现IP代理池管理的最佳实践>

前言:

本篇是要结合上篇一起看的姊妹篇:爬虫工作量由小到大的思维转变---<第三十九章 Scrapy-redis 常用的那个RetryMiddleware>-CSDN博客

IP代理池的管理对于确保爬虫的稳定性和数据抓取的匿名性至关重要。围绕Scrapy-Redis框架和一个具体的IP代理池中…

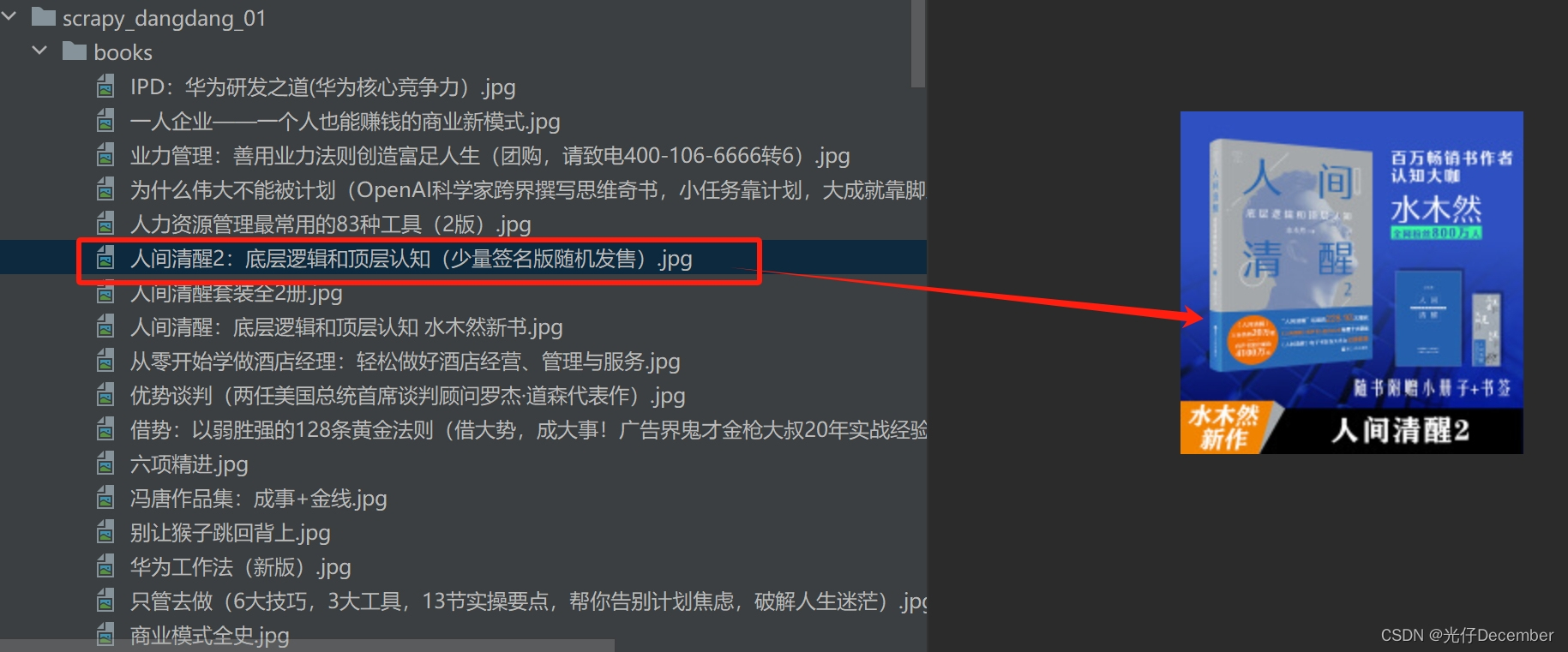

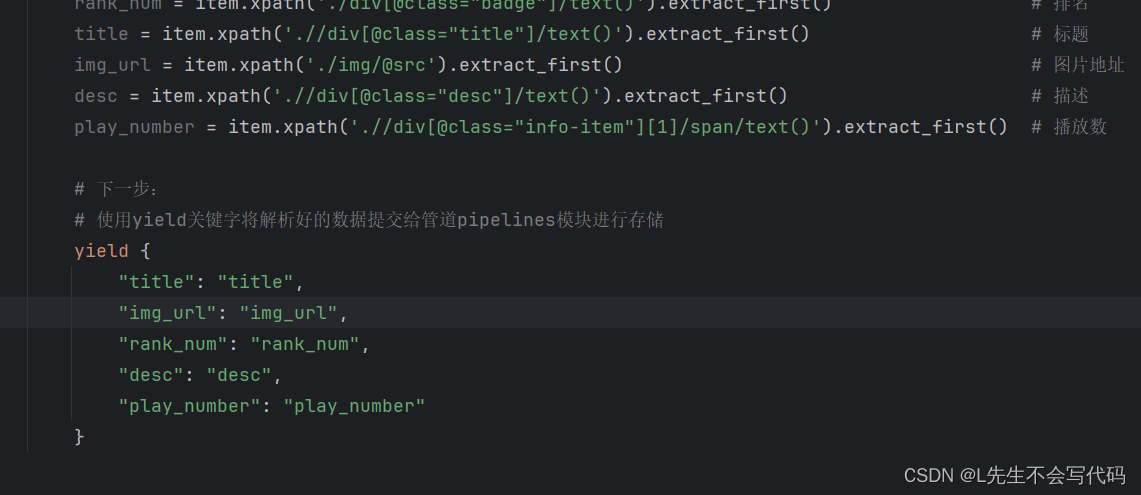

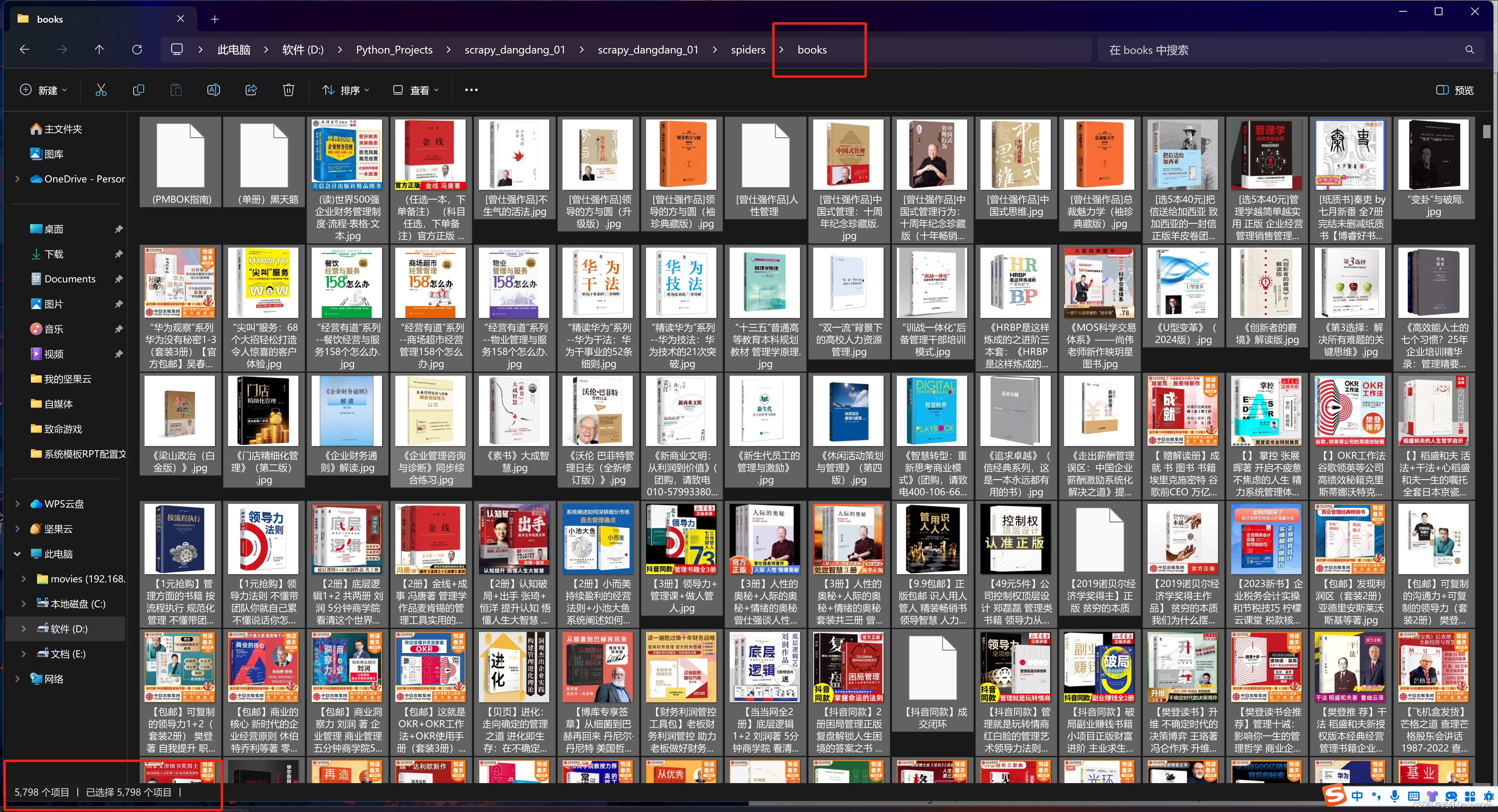

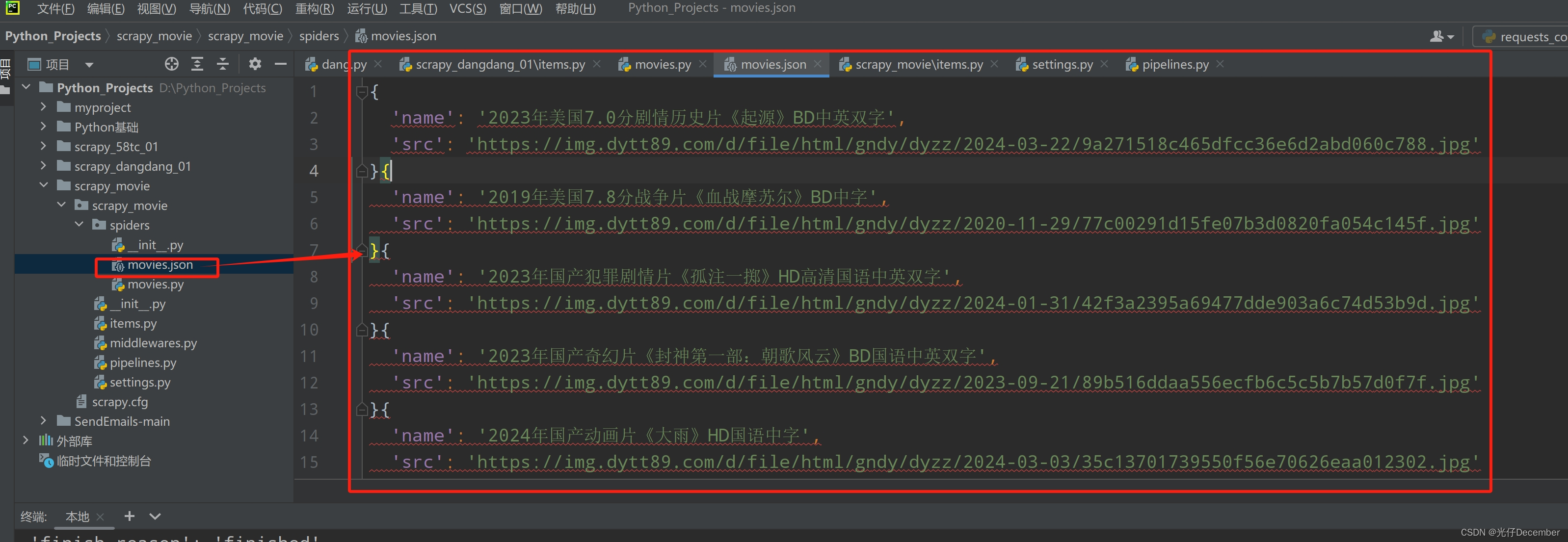

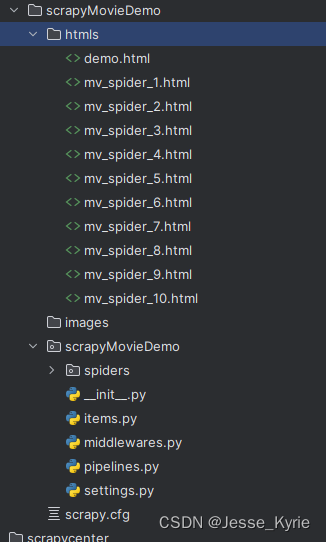

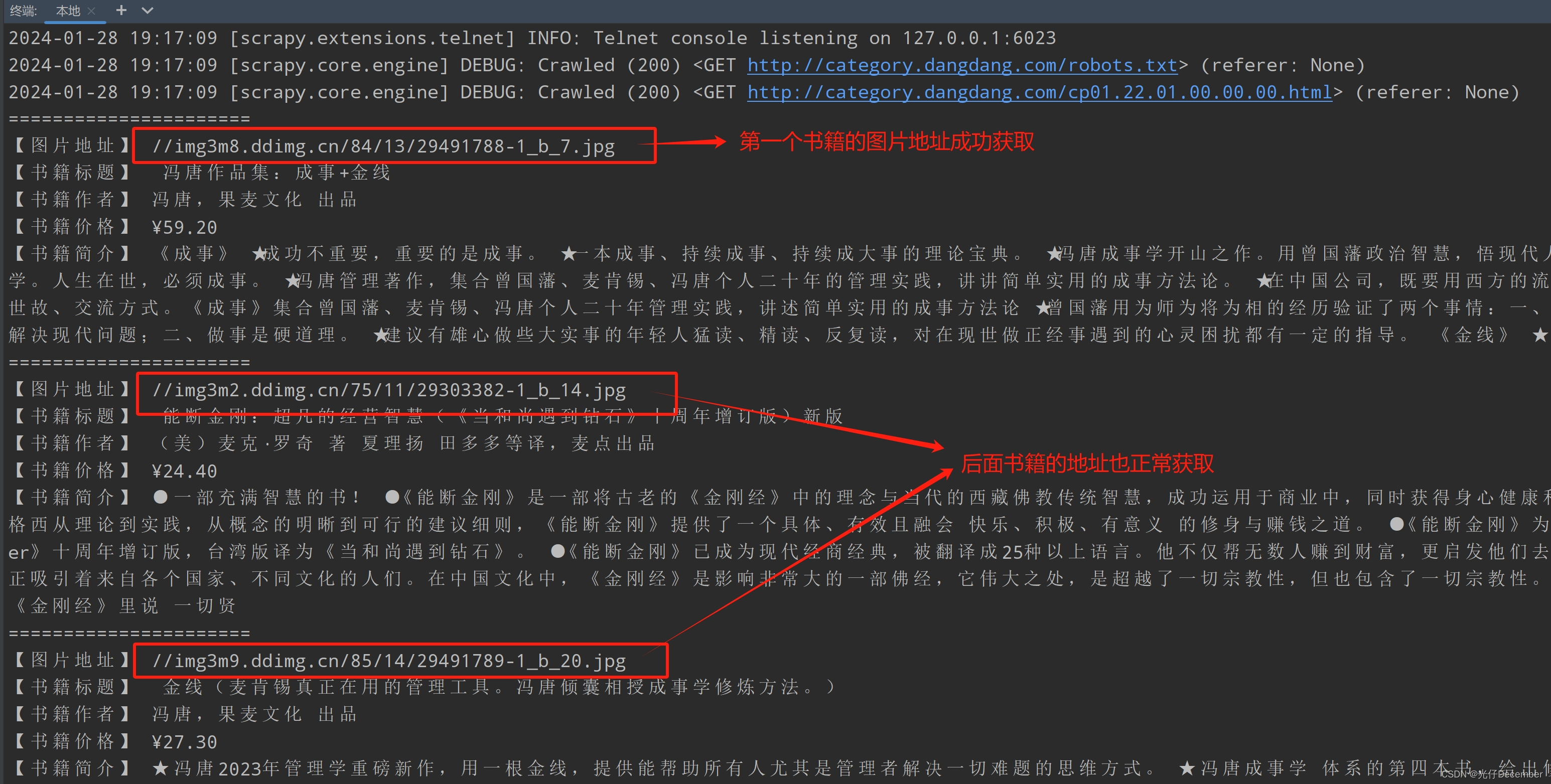

Python爬虫---scrapy框架---当当网管道封装

项目结构: dang.py文件:自己创建,实现爬虫核心功能的文件

import scrapy

from scrapy_dangdang_20240113.items import ScrapyDangdang20240113Itemclass DangSpider(scrapy.Spider):name "dang" # 名字# 如果是多页下载的话, …

scrapy案例教程

文章目录 1 scrapy简介2 创建项目3 自定义初始化请求url4 定义item5 定义管道 1 scrapy简介

scrapy常用命令 |命令 | 格式 |说明| |–|–|–| |startproject |scrapy startproject <项目名> |创建一个新项目| |genspider| scrapy genspider <爬虫文件名> <域名…

专业爬虫框架 _scrapy进阶使用详解

⑴ 中间件

中间件基本介绍 在Scrapy中,中间件是一种插件机制 它允许你在发送请求和处理响应的过程中对Scrapy引擎的行为进行干预和定制。 Scrapy中间件的用途: 修改请求、处理响应、处理异常、设置代理、添加自定义的HTTP头部等等。 Scrapy中间件主要分…

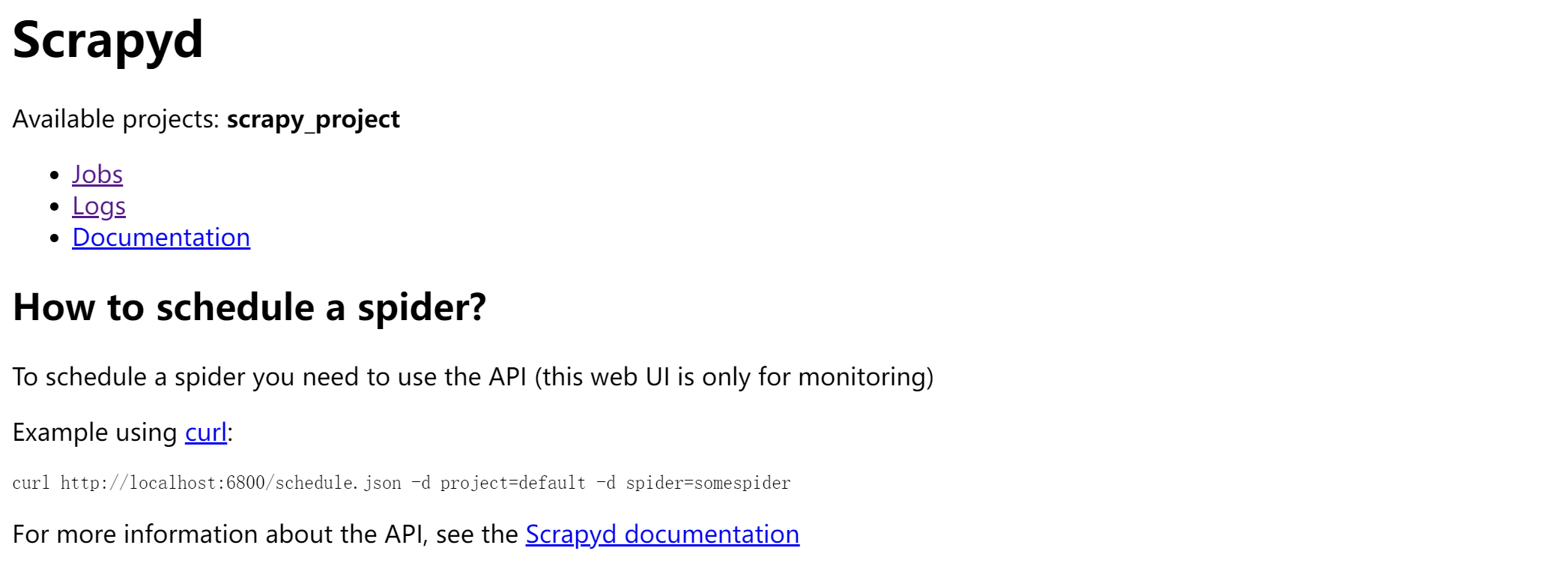

Scrapyd 和 Scrapyd-Client

Scrapyd

Scrapyd是一个服务,用来运行scrapy爬虫的它允许你部署你的scrapy项目以及通过HTTP JSON的方式控制你的爬虫

安装

pip install scrapyd

安装完成后,在你当前的python环境根目录下,有一个scrapyd.exe,打开命令行…

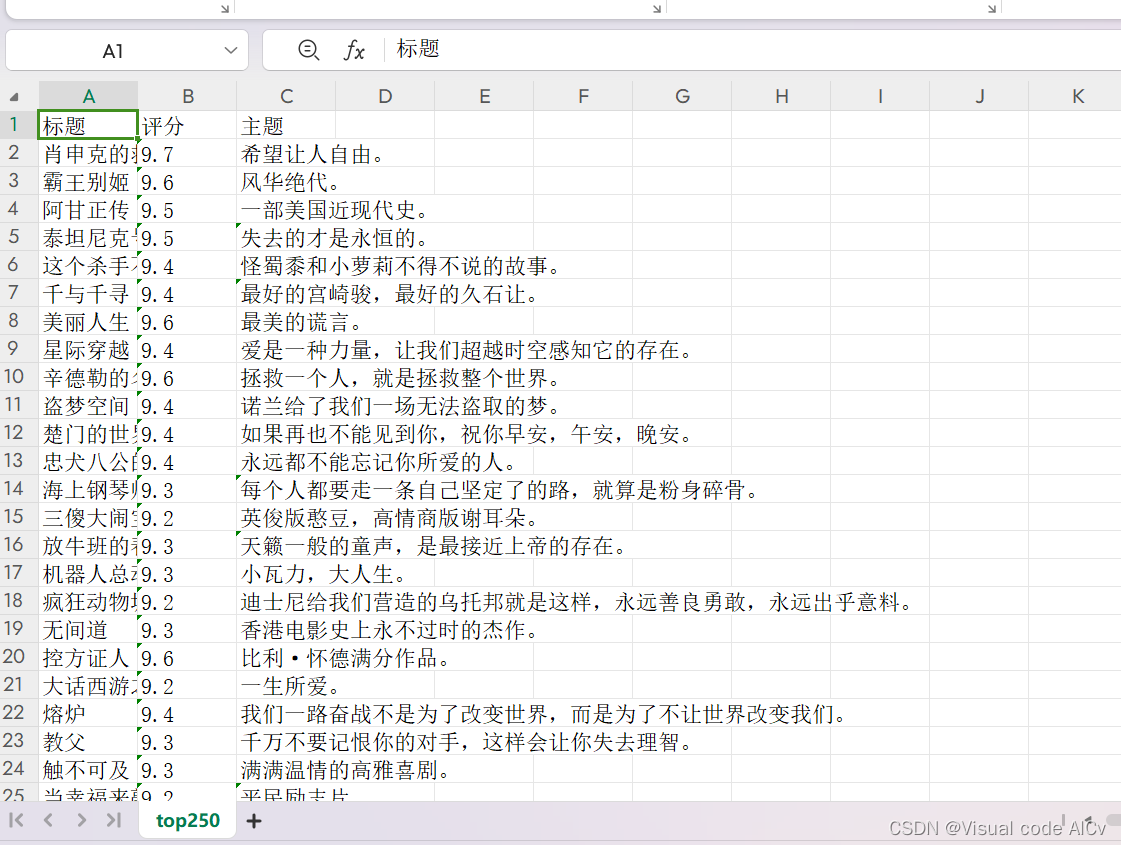

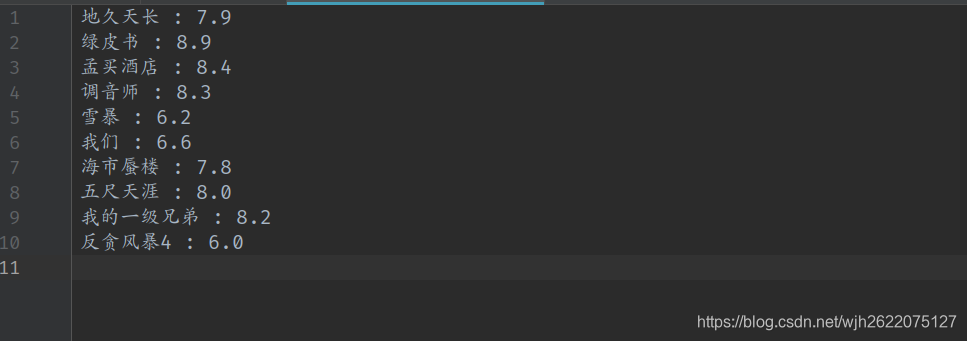

Python—Scrapy实践项目

爬取豆瓣电影2022年Top250部经典电影

1.项目概述 从https://movie.douban/top250爬取电影的标题、评分、主题。我在之前使用普通的爬虫实现了类似的功能,可以对比来进行学习(Python爬虫——爬虫基础模块和类库(附实践项目)&#…

实现爬虫加速的可实现办法

网络爬虫在数据采集和信息监测中发挥着重要作用。然而,由于网络环境复杂和大量数据需求,爬虫速度可能面临挑战。本文将为您分享一些实现爬虫加速的可行方法,帮助您让爬虫快如闪电!让我们一起探索吧!

一、多线程并发请…

爬虫进阶:Scrapy 抓取 boss 直聘、拉勾心得经验

关于使用Scrapy的体会,最明显的感受就是这种模板化、工程化的脚手架体系,可以说是拿来即可开箱便用,大多仅需按一定的规则套路配置,剩下的就是专注于编写跟爬虫业务有关的代码。绝大多数的反反爬虫策略,大多有以下几种…

Scrapy知识系列:使用CrawlerProcess从外部运行多个spider时,运行脚本需要与scrapy.cfg在同级目录

说明: 如题 否则settings、pipelines、middlewares都没有办法直接使用,修改起来非常麻烦

scrapy:顺序执行spider时,使用get_project_settings()获得的配置导致程序卡住

说明: 使用官方示例进行多个spider顺序执行时,程序卡住了: Common Practices — Scrapy 2.7.1 documentation 解决办法: 默认生成的settings.py文件中,最下面几行可看到

# Set settings whose default value is depre…

爬虫框架Scrapy

爬虫框架Scrapy

Scrapy简介第一个Scrapy应用Scrapy核心概念Scrapy Spider(爬虫)Scrapy Request(请求)Scrapy Response(响应)Scrapy Item(数据项)Scrapy Pipeline(管道&a…

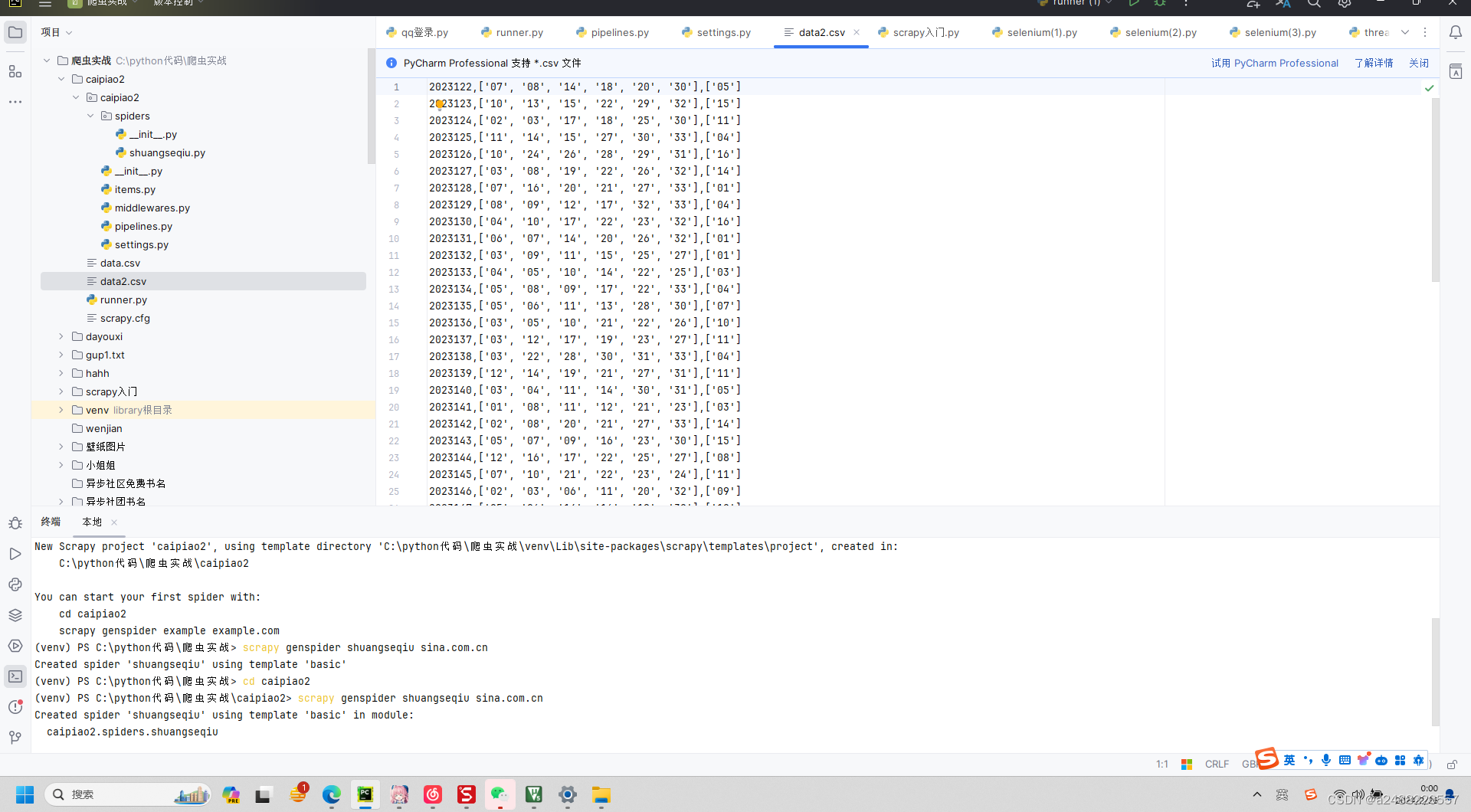

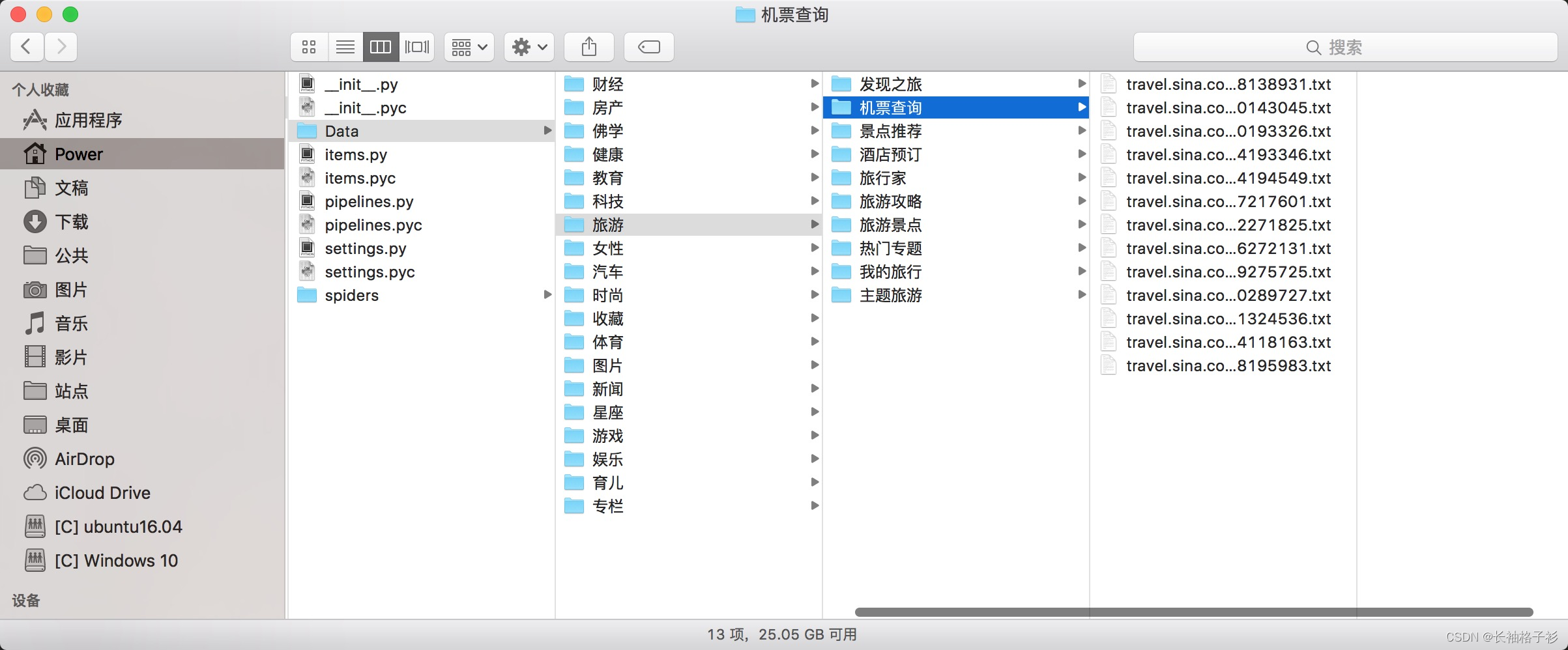

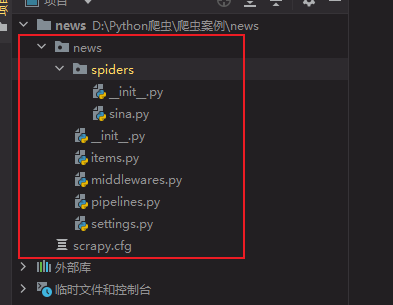

高级深入--day39

(实战项目三)新浪网分类资讯爬虫 爬取新浪网导航页所有下所有大类、小类、小类里的子链接,以及子链接页面的新闻内容。 效果演示图: items.py

import scrapy

import sys

reload(sys)

sys.setdefaultencoding("utf-8")class SinaItem(scrapy.I…

Scrapy框架Splash渲染

Scrapy框架是一款强大而灵活的Python网络爬虫框架,用于快速、高效地爬取和提取网页数据。然而,对于一些使用动态渲染技术的网站,Scrapy在处理JavaScript生成的内容上可能会有些困难。为了应对这种情况,Scrapy提供了Splash渲染服务…

第二章:25+ Python 数据操作教程(第二十六节利用 PYTHON Numpy 创建数组到数学和统计计算)持续更新

Numpy 是 Python 中最常用的模块之一,它用于各种任务,从创建数组到数学和统计计算。Numpy 还为 Python 编程带来了效率。在使用 numpy 时,您可能会遇到此错误,TypeError: only size-1 arrays can be converted to Python scalars它是经常出现的错误之一,有时解决它会成为一…

【深入Scrapy实战】从登录到数据解析构建完整爬虫流程

文章目录 1. 写在前面2. 抓包分析3. Scrapy提交登陆请求4. 列表与详情页面数据解析5. 中间件Middleware配置 【作者主页】:吴秋霖 【作者介绍】:Python领域优质创作者、阿里云博客专家、华为云享专家。长期致力于Python与爬虫领域研究与开发工作…

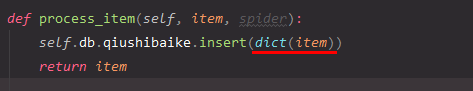

解决scrapy爬虫报错 pymongo.errors.DuplicateKeyError: E11000 duplicate key error collection

scrapy爬虫报错内容 pymongo.errors.DuplicateKeyError: E11000 duplicate key error collection: scrapy_data.qiushibaike index: id dup key: { _id: ObjectId(‘61989dfcfe585e2673d7ee1b’) }, full error: {‘index’: 0, ‘code’: 11000, ‘keyPattern’: {’_id’: 1}…

scrapy初学习--爬取豆瓣新片榜

文章目录爬取豆瓣榜单遇到403错误效果元素选择代码爬取豆瓣榜单遇到403错误

如图 解决方法: 在setting.py中添加user agent USER_AGENT Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/55.0.2883.87 Safari/537.36

爬取成功

效果

…

爬虫技术-Scrapy框架介绍

Scrapy采集框架 1 学习目标 1、框架流程和结构设计原理 2、框架爬虫程序编写 3、框架日志模块使用 4、框架请求发送流程 2 scrapy简介 Scrapy是用纯Python实现一个为了爬取网站数据、提取结构性数据而编写的应用框架,用途非常广泛,用户只需要定制开发…

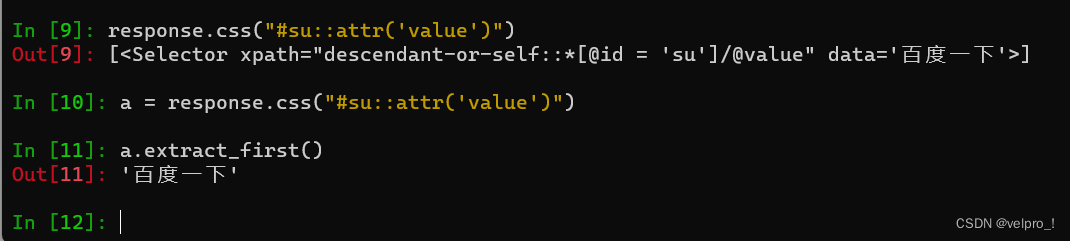

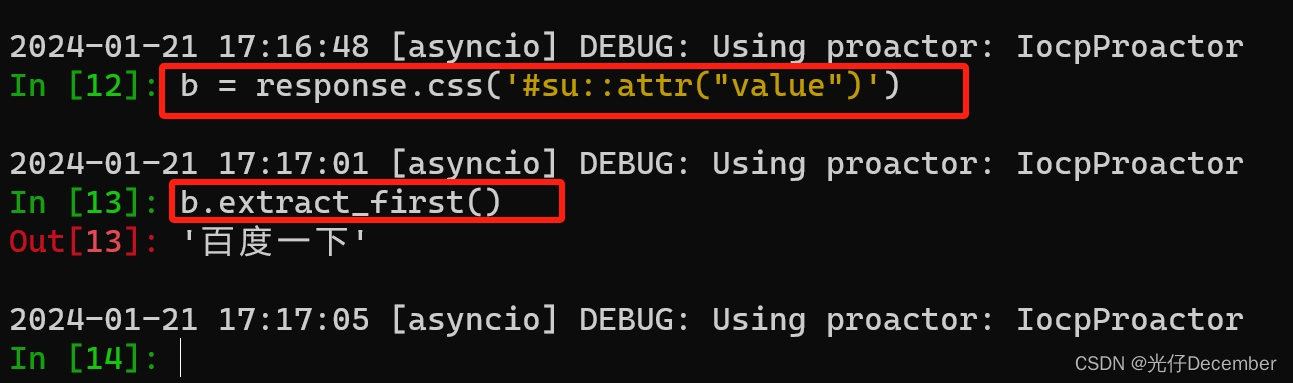

scrapy解析与数据库

Scrapy功能学习 1 scrapy数据提取 Scrapy 还提供了自己的数据提取方法,即 Selector(选择器)。Selector 是基于 lxml 来构建的,支持 XPath 选择器、CSS 选择器以及正则表达式,功能全面,解析速度和准确度非常高 1.1. 直接使用 Selec…

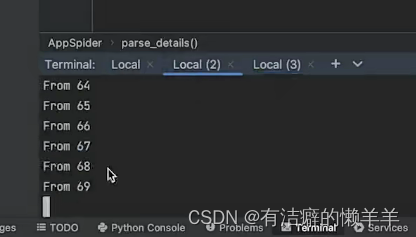

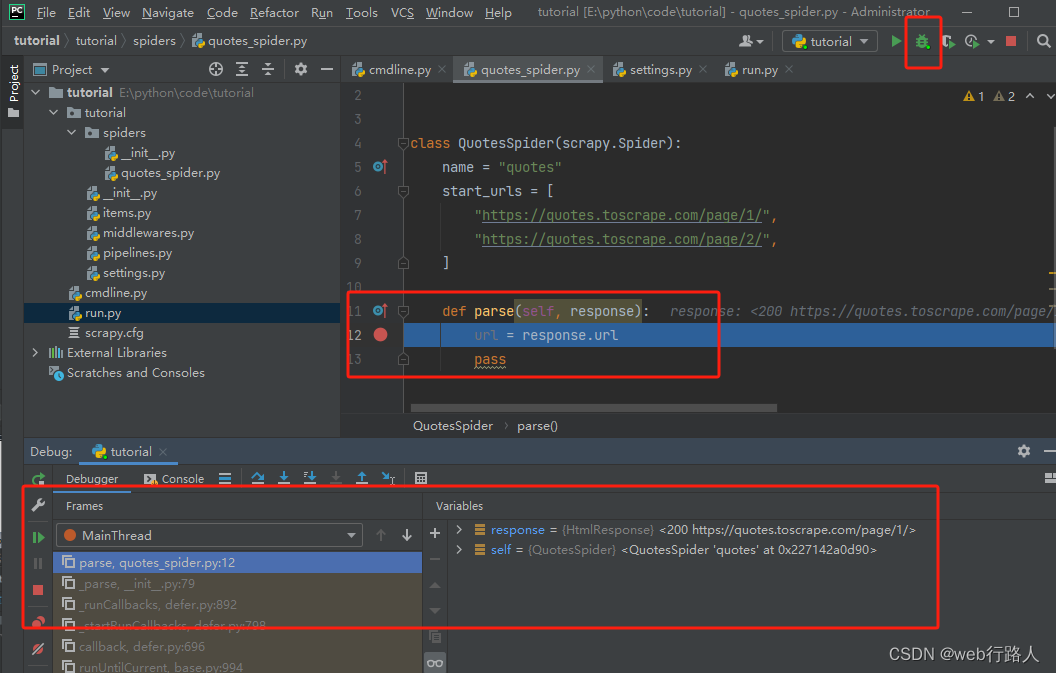

【python爬虫】scrapy在pycharm 调试

scrapy在pycharm 调试

1、使用scrapy创建一个项目

scrapy startproject tutorial 2、在朋友pycharm中调试scrapy

2.1 通过文件run.py调试

在根目录下新建一个文件run.py(与scrapy.cfg文件的同一目录下), debug ‘run’即可

# -*- coding:utf-8 -*-

…

Python——记Scrapy的基本使用

Scrapy 爬虫的使用步骤

创建一个工程编写Spider编写Item Pipeline优化配置策略

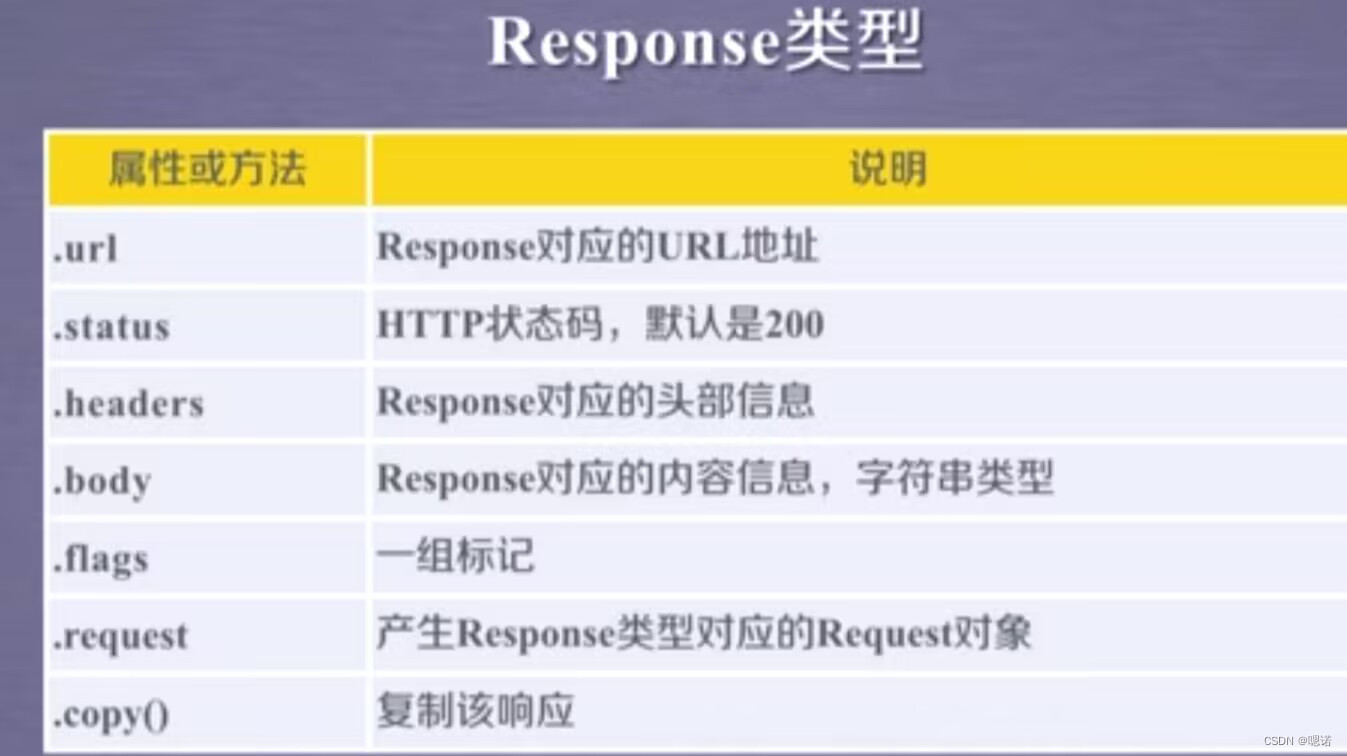

①Request类:向网络中提交请求

class scrapy.http.Request()Request对象表示一个HTTP请求。由Spider生成,由Downloader执行。

Resquest类 ②Response类:网络…

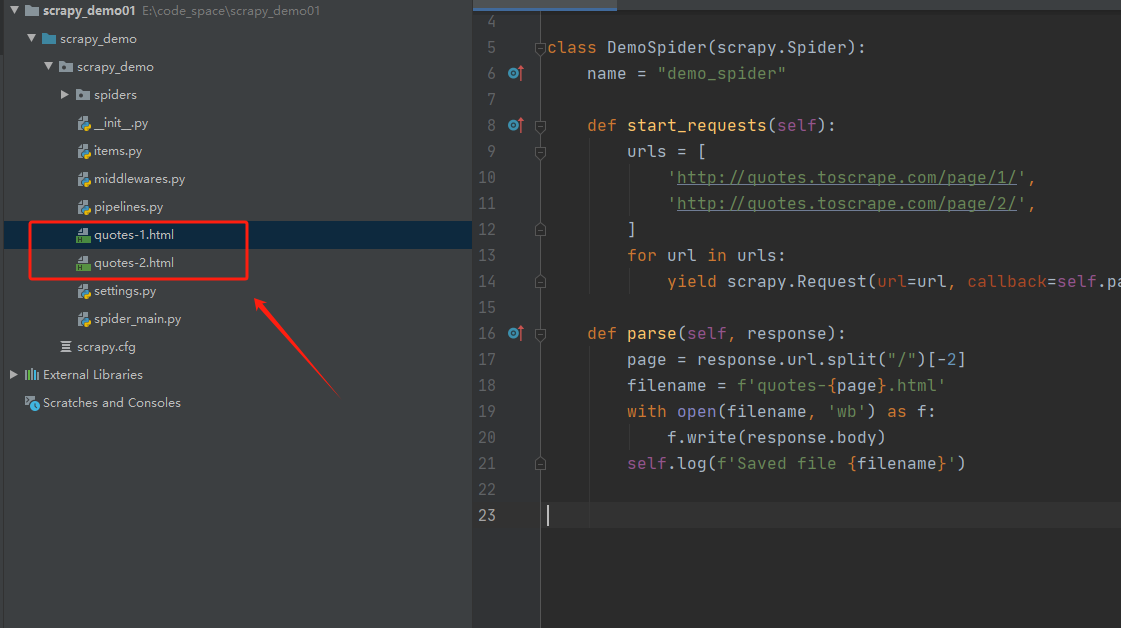

高级深入--day29

入门案例

学习目标 创建一个Scrapy项目定义提取的结构化数据(Item)编写爬取网站的 Spider 并提取出结构化数据(Item)编写 Item Pipelines 来存储提取到的Item(即结构化数据)一. 新建项目(scrapy startproject) 在开始爬取之前,必须创建一个新的Scrapy项目。进入自定义的项目目…

scrapy的概念作用和工作流程

1. scrapy的概念

Scrapy是一个Python编写的开源网络爬虫框架。它是一个被设计用于爬取网络数据、提取结构性数据的框架。 Scrapy 使用了Twisted[twɪstɪd]异步网络框架,可以加快我们的下载速度。 Scrapy文档地址:http://scrapy-chs.readthedocs.io/zh_…

Python爬虫学习之scrapy库

一、scrapy库安装 pip install scrapy -i https://pypi.douban.com/simple 二、scrapy项目的创建 1、创建爬虫项目 打开cmd 输入scrapy startproject 项目的名字 注意:项目的名字不允许使用数字开头 也不能包含中文 2、创建爬虫文件 要在spiders文件…

Scrapy框架之认识MongoDB

目录

MongoDB

简介

特点

MongoDB的适用场景

MongoDB的行业具体应用

如何抉择是否使用MongoDB MongoDB 简介

MongoDB 是免费开源的跨平台 NoSQL 数据库,命名源于英文单词 humongous,意思是「巨大无比」,可见开发组对 MongoDB 的定位。…

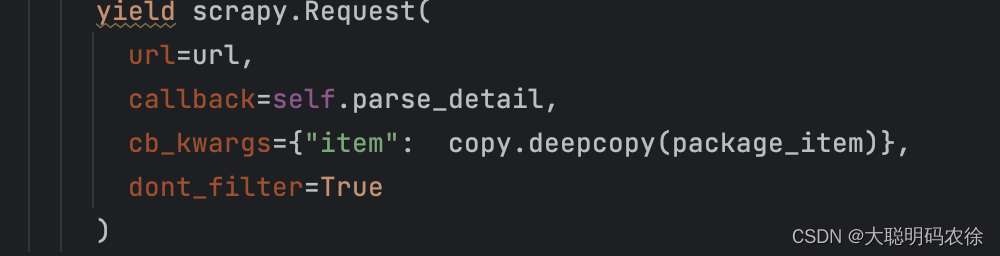

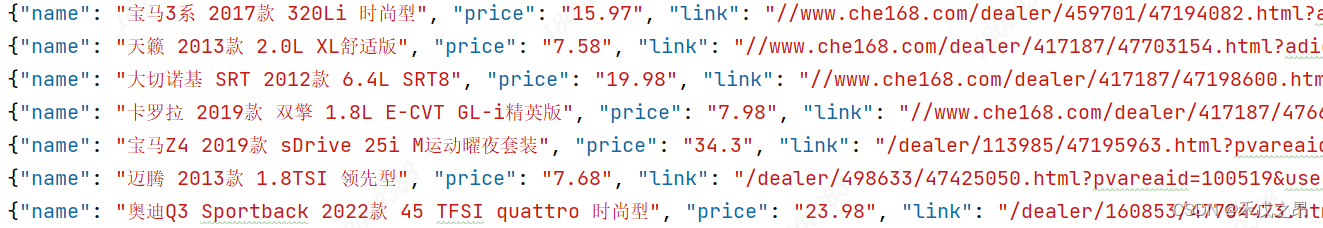

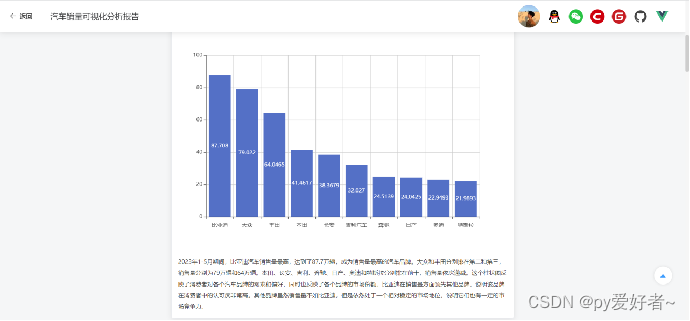

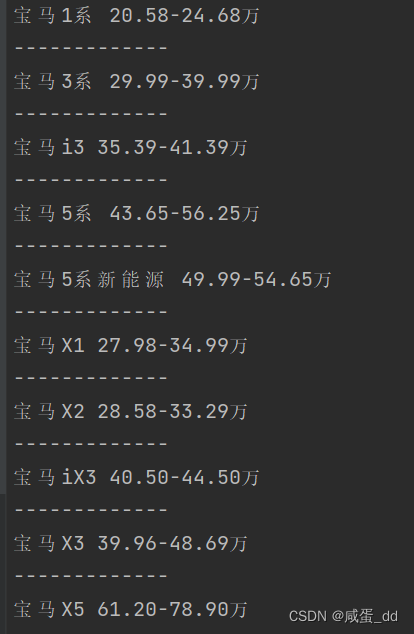

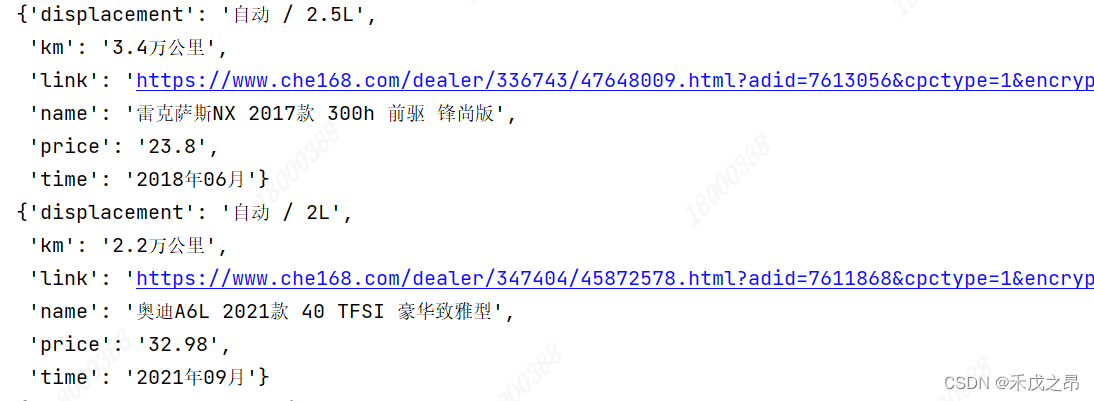

【Python_Scrapy学习笔记(八)】基于Scrapy框架实现多级页面数据抓取

基于Scrapy框架实现多级页面数据抓取

前言

本文中介绍 如何基于 Scrapy 框架实现多级页面数据的抓取,并以抓取汽车之家二手车数据为例进行讲解。

正文

在介绍如何基于 Scrapy 框架实现多级页面数据的抓取之前,先介绍下 Scrapy 框架的请求对象 reques…

爬虫工作量由小到大的思维转变---<第三十一章 Scrapy Redis 初启动/conn说明书)>

前言:

重点在读connection.py的源码,这个组件主要是用来连接的; 因为连接都无法做到,后面想更改点自定义就白扯了;

正文:

翻译版的connection.py源码:

import sys

import six

from scrapy.utils.misc import load_object

from . import defaults# 快捷方式映射 设置名称 -&…

爬虫工作量由小到大的思维转变---<第二十八章 Scrapy中间件说明书>

爬虫工作量由小到大的思维转变---<第二十六章 Scrapy通一通中间件的问题>-CSDN博客

前言:

(书接上面链接)自定义中间件玩不明白? 好吧,写个翻译的文档点笔记,让中间件更通俗一点!!! 正文:

全局图: 爬虫中间件--->翻译笔记:

from scrapy import s…

scrapy针对302请求的处理与重试配置

不修改任何配置,scrapy针对302请求时如何处理的?

默认情况下,当爬虫发送请求并收到 HTTP 302 重定向响应时,Scrapy 会自动跟随重定向,也就是说,它会自动向重定向的 URL 发送一个新的请求,并且在…

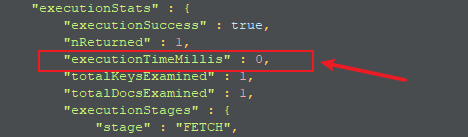

爬虫工作量由小到大的思维转变---<第二十四章 Scrapy的`统计数据`收集stats collection>

前言:

前两篇是讲的数据诊断分析,还有一篇深挖解决内存泄漏的文章,目前我还没整理汇编出来;但是,想到分析问题的时候,忽然觉得爬虫的数据统计好像也挺重要;于是,心血来潮准备来插一篇这个------让大家对日常scrapy爬的数据,做到心里有数!不必自己去搅破脑汁捣腾日志,敲计算器了…

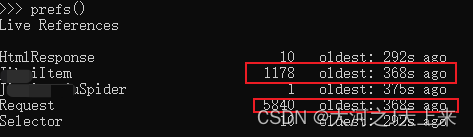

爬虫工作量由小到大的思维转变---<第二十三章 Scrapy开始很快,越来越慢(医病篇)>

诊断篇https://blog.csdn.net/m0_56758840/article/details/135170994?ops_request_misc%257B%2522request%255Fid%2522%253A%2522170333243316800180644102%2522%252C%2522scm%2522%253A%252220140713.130102334.pc%255Fall.%2522%257D&request_id1703332433168001806441…

VirtualBox CentOS7.7.1908 Python3.8 搭建Scrapy开发环境

一顿折腾,总结记录下环境虚拟机网卡设置配置yum国内镜像源安装第三方依赖安装mongodb安装python3.8安装scrapy附环境 VirtualBox_v6.0.14 CentOS_v7.1908 Python_v3.8.0 MongoDB_v3.2.22 pip_v19.3.1 windows Pycharm-2019.2.3企业版(社区版不支持远程连接linux开发…

深入理解Scrapy

Scrapy是什么 An open source and collaborative framework for extracting the data you need from websites. In a fast, simple, yet extensible way. Scrapy是适用于Python的一个快速、简单、功能强大的web爬虫框架,通常用于抓取web站点并从页面中提取结构化的数…

爬虫工作量由小到大的思维转变---<第十八章 Scrapy请求处理与返回策略>

前言:

今天我们来聊一聊Scrapy爬虫中的请求处理与返回策略。你有没有遇到过一个Item需要由多个请求组成的情况?如果是的话,那么对请求的处理和决定是否返回处理过的Item对象就变得格外重要。看一下Scrapy中的相关策略,实现爬虫的完美康复。 …

高级深入--day44

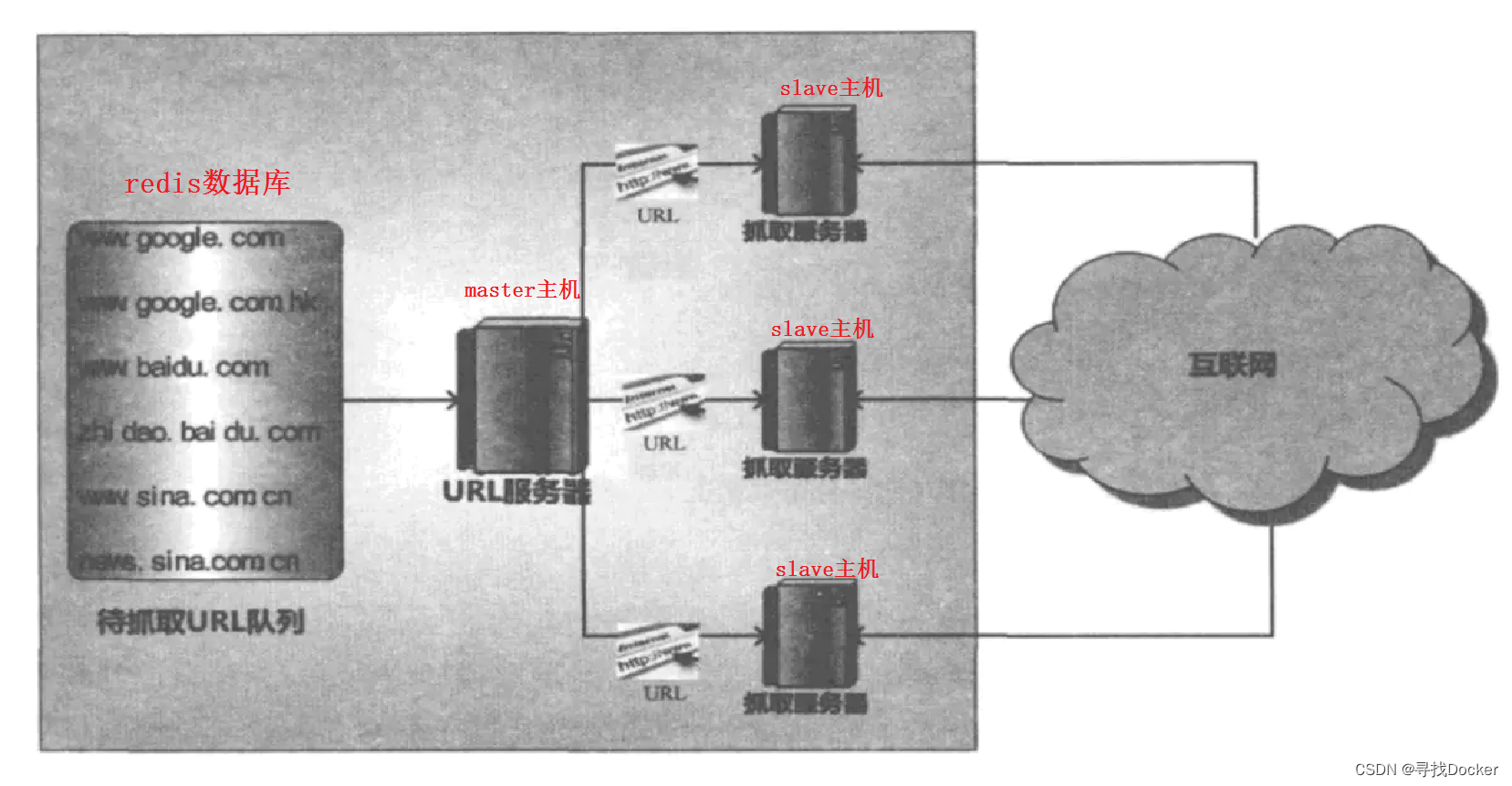

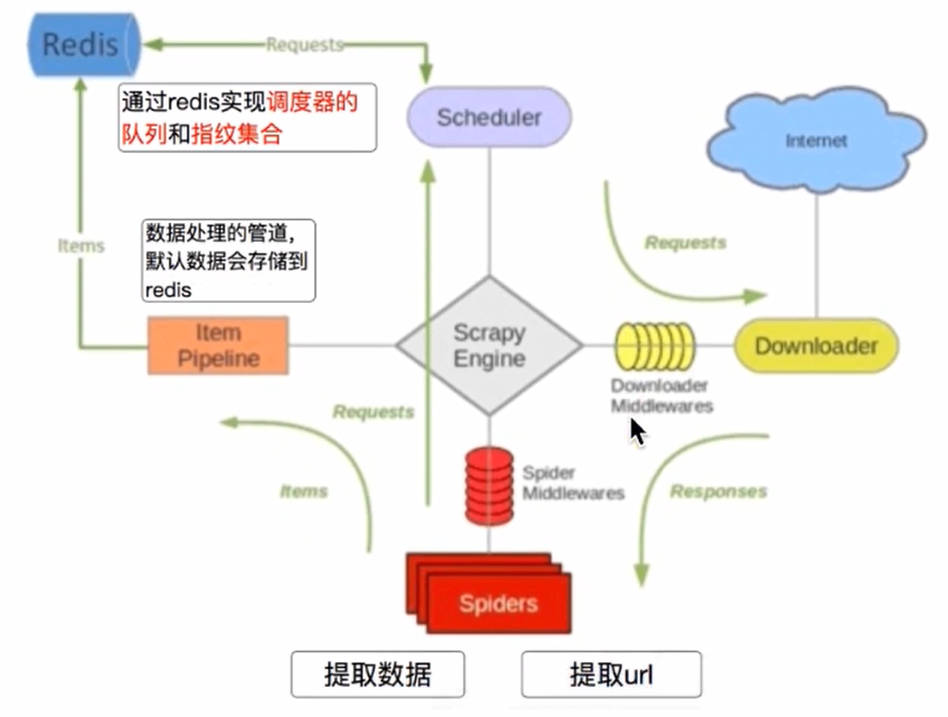

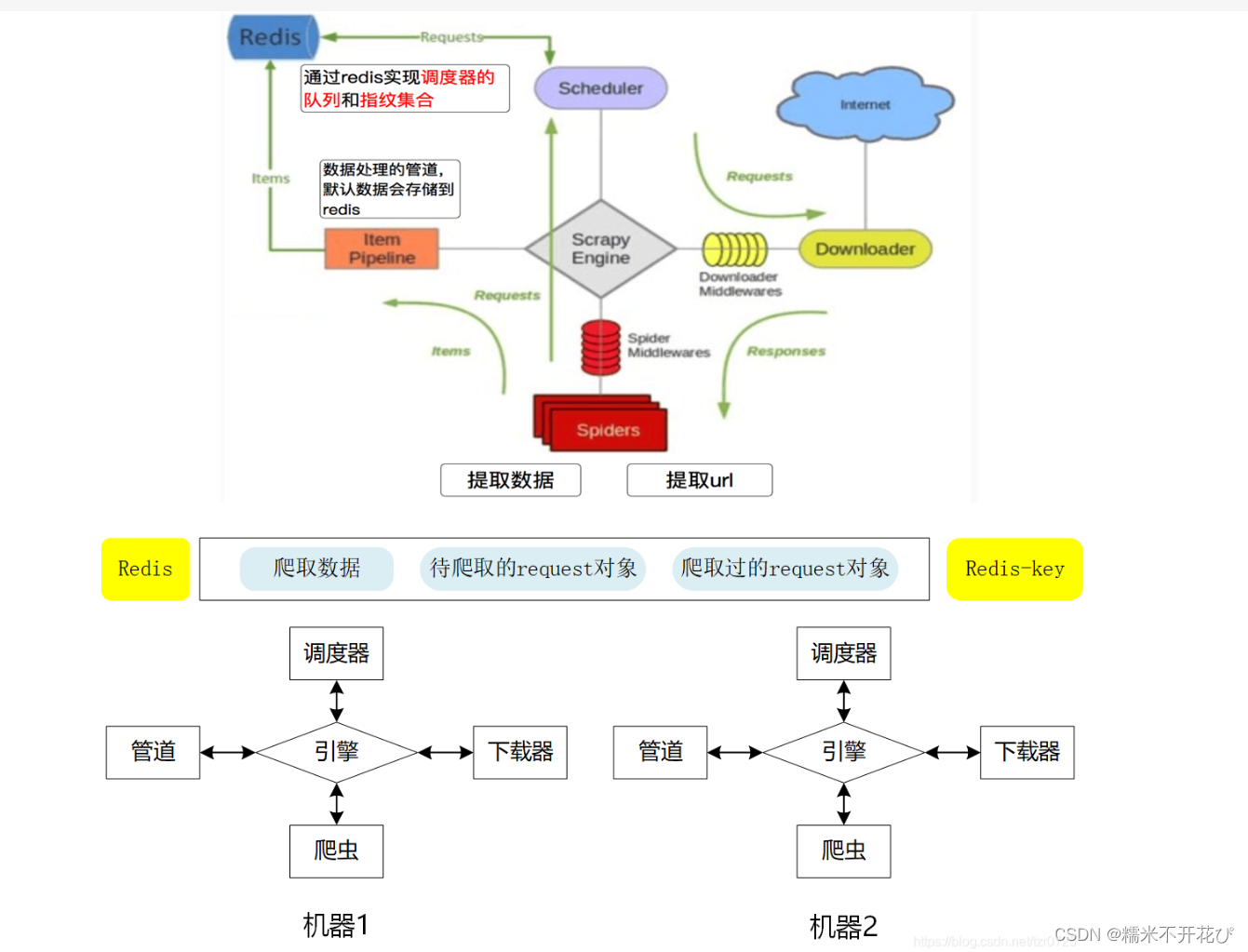

Scrapy 和 scrapy-redis的区别

Scrapy 是一个通用的爬虫框架,但是不支持分布式,Scrapy-redis是为了更方便地实现Scrapy分布式爬取,而提供了一些以redis为基础的组件(仅有组件)。 pip install scrapy-redis Scrapy-redis提供了下面四种组件&a…

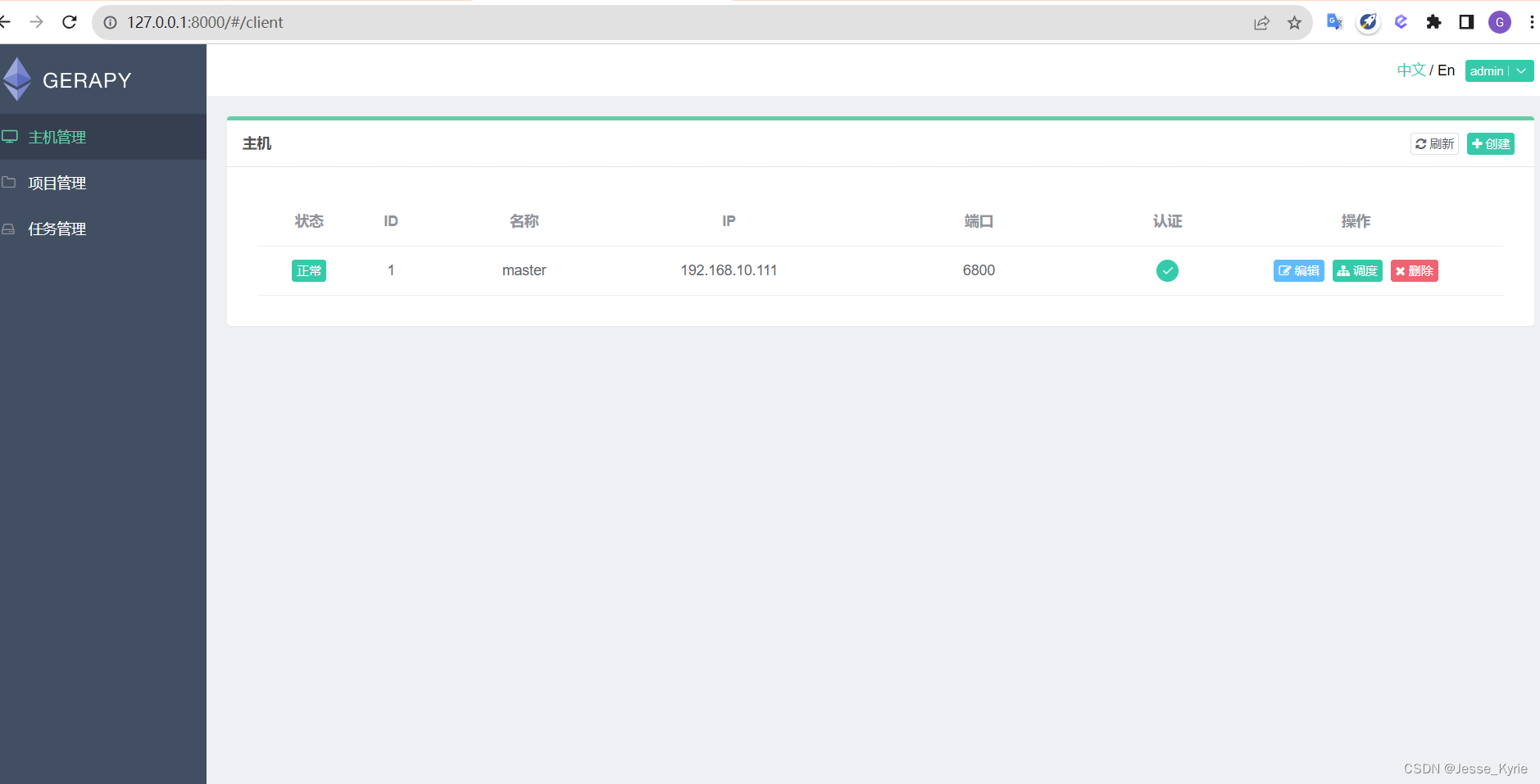

爬虫工作量由小到大的思维转变---<第三十四章 Scrapy 的部署scrapyd+Gerapy>

前言:

scrapy-redis没被部署,感觉讲起来很无力;因为实在编不出一个能让scrapy-redis发挥用武之地的案子;所以,索性直接先把分布式爬虫的部署问题给讲清楚!! 然后,曲线救国式地再在部署的服务器上,讲scrapy redis我感觉这样才好! 正文:

现在还有不少人在用scrapy web进行爬虫管…

解决HTTP 429错误的Scrapy中间件配置

引言

在进行网络数据抓取时,经常会遇到HTTP 429错误,表示请求速率已超出API限制。为避免封禁或限制访问,需要调整Scrapy的请求速率,以在不触发HTTP 429错误的情况下完成数据抓取。针对这一问题,可使用Scrapy的AutoThr…

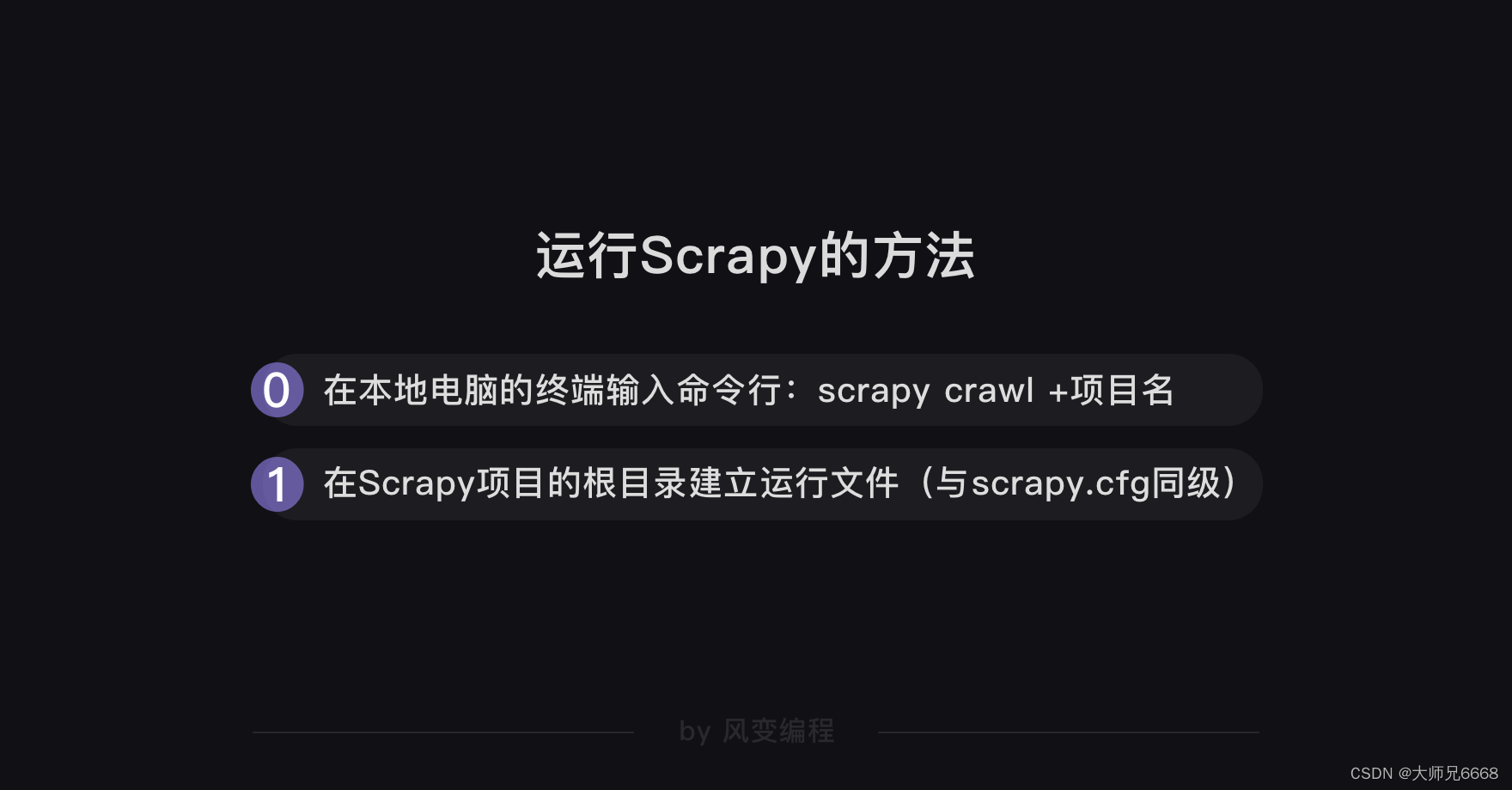

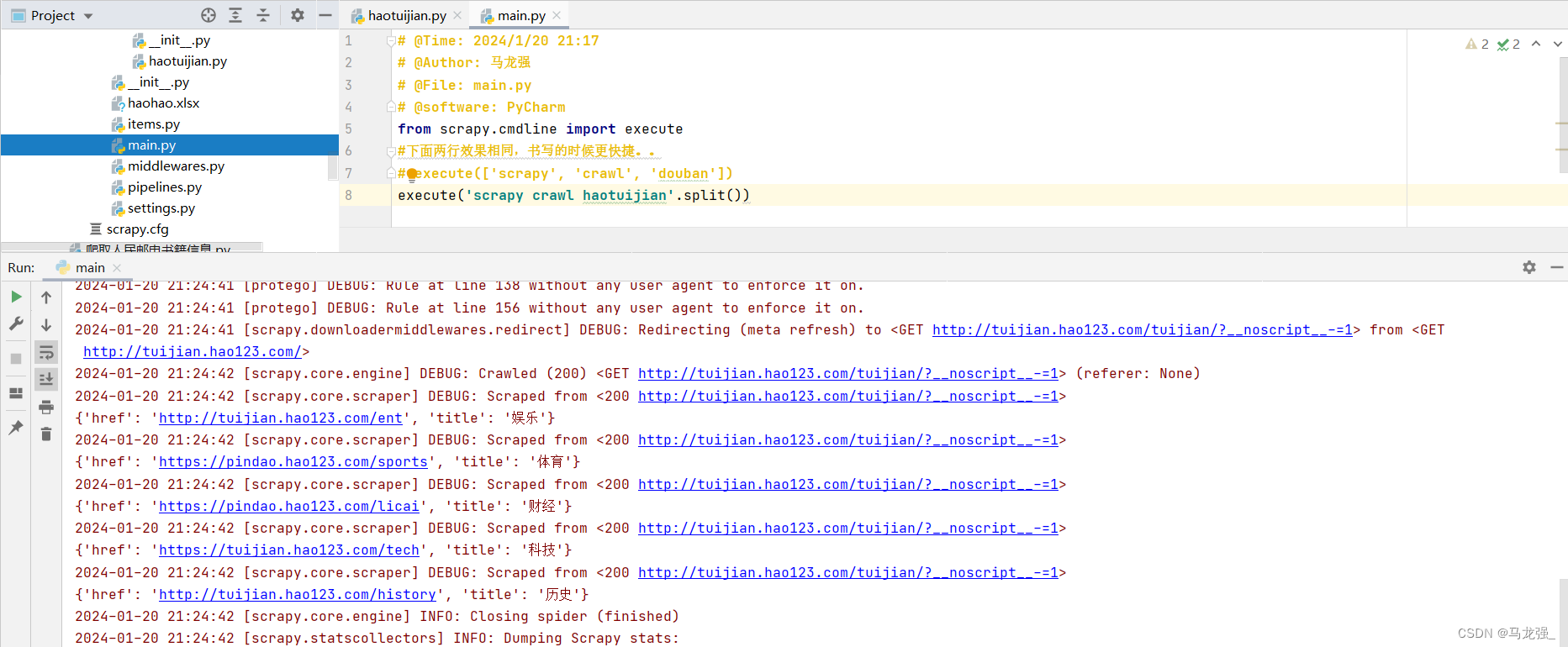

爬虫工作量由小到大的思维转变---<第七章 Scrapy超越控制台===代码运行scrapy+多线程爬取+数据交互>

前言: 针对留言的问题: scrapy谁告诉你只能在控制台启动的?你是抖和BILI看多了吧!! - ---看我的,让你玩出花;

正文:

传统方式 vs 脚本方式

在Scrapy框架中,传统方式一般是指通过终端(或命令行)启动Scrapy项目,而脚本方式是…

Python爬虫---Scrapy框架---CrawlSpider

CrawlSpider 1. CrawlSpider继承自scrapy.Spider 2. CrawlSpider可以定义规则,再解析html内容的时候,可以根据链接规则提取出指定的链接,然后再向这些链接发送请求,所以,如果有需要跟进链接的需求,意思就是…

如何使用 Python 爬虫 Scrapy 获取网页内容?

部分数据来源:ChatGPT

引言 在现如今的互联网时代,获取网页上的内容是一项很常见的任务。比如,我们想要获取百度搜索上某个关键词的搜索结果,就需要使用 Python 编写一个爬虫脚本来完成这个任务。

下面,我们将逐步分析一个 Python 爬虫脚本,带你了解如何使用 Selenium…

Scrapy 学习篇(五)--setting配置

为什么需要配置文件

配置文件存放一些公共的变量(比如数据库地址,账号密码等)一般用全大写字母命名变量名

在spider中,setting能够通过self.setting的方式访问到:

class MySpider(scrapy.Spider):name myspiderstar…

在Python中处理CSV文件的常见问题

当谈到数据处理和分析时,CSV(Comma-Separated Values)文件是一种非常常见的数据格式。它简单易懂,可以被绝大多数编程语言和工具轻松处理。在Python中,我们可以使用各种库和技巧来处理CSV文件,让我们一起来…

Scrapy框架中间件(一篇文章齐全)

1、Scrapy框架初识(点击前往查阅)

2、Scrapy框架持久化存储(点击前往查阅)

3、Scrapy框架内置管道(点击前往查阅)

4、Scrapy框架中间件 Scrapy 是一个开源的、基于Python的爬虫框架,它提供了…

线程池(ThreadPoolExecutor,as_completed)和scrapy框架初步构建——学习笔记

用法1:map函数 with ThreadPoolExecutor() as pool: results pool.map(craw,utls)for result in results:print(result)

1.Scrapy框架: 五大结构:引擎,下载器,爬虫,调度器,管道&#x…

爬虫工作量由小到大的思维转变---<第四十八章 Scrapy 的请求和follow问题>

前言:

有时,在爬取网页的时候,页面可能只能提取到对应的url,但是具体需要提取的信息需要到下一页(url)里面; 这时候,不要在中间件去requests请求去返回response; 用这个方法....

正文:

在Scrapy框架内,如果你想从一个页面提取URL,然后跳转到这个URL以…

手机爬虫用Scrapy详细教程:构建高效的网络爬虫

如果你正在进行手机爬虫的工作,并且希望通过一个高效而灵活的框架来进行数据抓取,那么Scrapy将会是你的理想选择。Scrapy是一个强大的Python框架,专门用于构建网络爬虫。今天,我将与大家分享一份关于使用Scrapy进行手机爬虫的详细…

爬虫工作量由小到大的思维转变---<第十九章 Scrapy抛弃项目的隐患---处理无效数据>

前言:

(如果你的scrapy项目运行到最后,卡住不动了---且也没有任务在运行! 这种情况,大概率就是因为.这个了 )

在Scrapy爬虫开发中,正确处理项目丢弃异常是至关重要的。如果我们没有适当地抛弃项目,可能会导致一些潜在的问题和隐患。

危害和隐患&#…

玩转 Scrapy 框架 (一):Scrapy 框架介绍及使用入门

目录 一、Scrapy 框架介绍二、Scrapy 入门 一、Scrapy 框架介绍

简介: Scrapy 是一个基于 Python 开发的爬虫框架,可以说它是当前 Python 爬虫生态中最流行的爬虫框架,该框架提供了非常多爬虫的相关组件,架构清晰,可扩…

Scrapy的crawlspider爬虫

scrapy的crawlspider爬虫

学习目标:

了解 crawlspider的作用应用 crawlspider爬虫创建的方法应用 crawlspider中rules的使用 1、crawlspider是什么 回顾之前的代码中,我们有很大一部分时间在寻找下一页的url地址或者是内容的url地址上面,这…

爬虫实战之使用 Python 的 Scrapy 库开发网络爬虫详解

关键词 - Python, Scrapy, 网络爬虫

在信息爆炸时代,我们每天都要面对海量的数据和信息。有时候我们需要从互联网上获取特定的数据来进行分析和应用。今天我将向大家介绍如何使用 Python 的 Scrapy 库进行网络爬虫,获取所需数据。 1. Scrapy 简介

1.1 …

使用Scrapy的调试工具和日志系统定位并解决爬虫问题

目录

摘要

一、Scrapy简介

二、Scrapy的调试工具

1、Shell调试工具

2、断点调试

三、Scrapy的日志系统

四、实例解析

1、启用详细日志

2、断点调试

3、分析日志

4、解决问题

五、代码示例

总结 摘要

本文详细介绍了如何使用Scrapy的调试工具和日志系统来定位并解…

爬虫工作量由小到大的思维转变---<第二十五章 Scrapy开始很快,越来越慢(追溯篇)>

爬虫工作量由小到大的思维转变---<第二十二章 Scrapy开始很快,越来越慢(诊断篇)>-CSDN博客

爬虫工作量由小到大的思维转变---<第二十三章 Scrapy开始很快,越来越慢(医病篇)>-CSDN博客

前言:

之前提到过,很多scrapy写出来之后,不…

Scrapy框架介绍

文章目录Scrapy框架介绍1.简介2.架构3.数据流4.项目结构Scrapy框架介绍

Scrapy 是一个基于 Python 开发的爬虫框架,可以说它是当前Python爬虫生态中最流行的爬虫框架,该框架提供了非常多爬虫相关的基础组件,架构清晰,可扩展性极强…

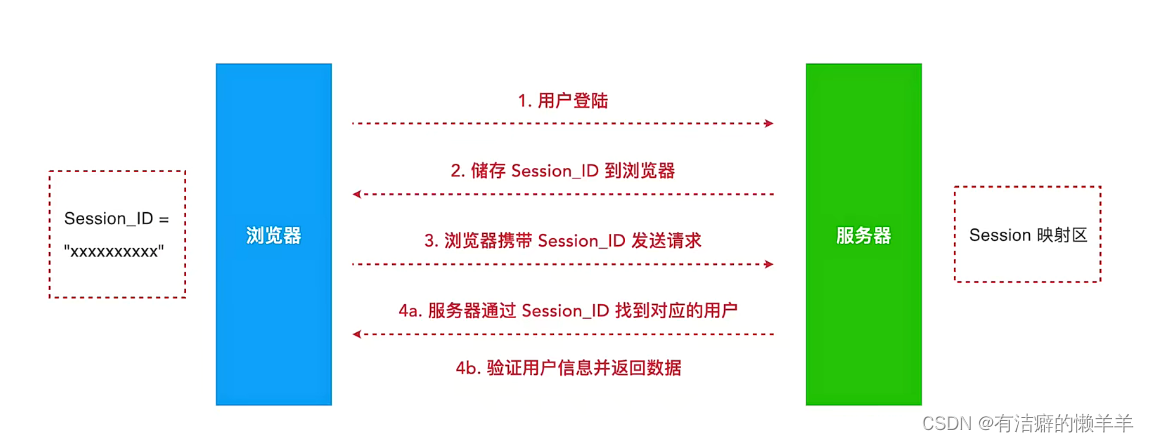

scrapy+selenium框架模拟登录

目录

一、cookie和session实现登录原理

二、模拟登录方法-Requests模块Cookie实现登录

三、cookiesession实现登录并获取数据

四、selenium使用基本代码

五、scrapyselenium实现登录 一、cookie和session实现登录原理

cookie:1.网站持久保存在浏览器中的数据2.可以是长期…

文件批量管理:轻松复制备份并删除原文件

在日常生活和工作中,我们经常需要处理大量的文件。为了确保文件的安全性和完整性,您需要一种高效的文件批量管理方法。本文将向您介绍如何一一复制备份并删除原文件里的文件,让您的文件管理变得轻松便捷。

首先,我们要进入文件批…

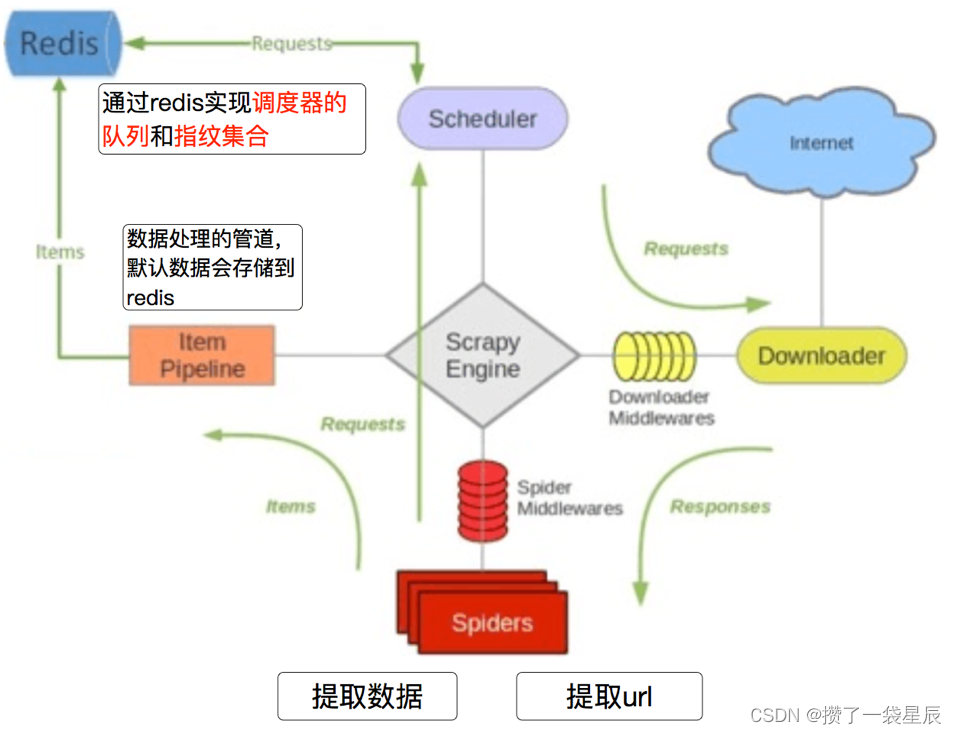

架构学习(二):原生scrapy如何接入scrapy-redis,初步入局分布式

原生scrapy如何接入scrapy-redis,实现初步入局分布式 前言scrpy-redis分布式碎语 实现流程扩展结束 前言

scrpy-redis分布式

下图是scrpy-redis官方提供的架构图,按我理解,与原生scrapy的差异主要是把名单队列服务器化,也是存储…

基于scrapy框架的单机爬虫与分布式爬虫

我们知道,对于scrapy框架来说,不仅可以单机构建复杂的爬虫项目,还可以通过简单的修改,将单机版爬虫改为分布式的,大大提高爬取效率。下面我就以一个简单的爬虫案例,介绍一下如何构建一个单机版的爬虫&#…

【python】网络爬虫与信息提取--scrapy爬虫框架介绍

一、scrapy爬虫框架介绍 scrapy是一个功能强大的网络爬虫框架,是python非常优秀的第三方库,也是基于python实现网络爬虫的重要技术路线。scrapy不是哟个函数功能库,而是一个爬虫框架。 爬虫框架:是实现爬虫功能的一个软件结构和功…

探索Scrapy-spider:构建高效网络爬虫

Spider简介

Scrapy中的Spider是用于定义和执行数据抓取逻辑的核心组件。Spider负责从指定的网站抓取数据,并定义了如何跟踪链接、解析内容以及提取数据的规则。它允许您定制化地指定要抓取的网站、页面和所需的信息。Spider的作用是按照预定的规则爬取网页…

python(自5)scrapy下载安装 基本使用

一,安装下载

(1)安装步骤

//安装包下载:Archived: Python Extension Packages for Windows - Christoph Gohlke (uci.edu) // 先下载对应的 twisted 然后 pip install 拖进twisted//例如: twisted_iocpsupport‑1.0.2‑cp311‑cp31…

基于Scrapy的IP代理池搭建

目录

前言

如何构建ip代理池

1. 确定代理IP源

2. 创建Scrapy项目

3. 定义代理IP爬虫

4. 编写网页解析逻辑

5. 检测代理IP的可用性

6. 存储可用的代理IP

7. 运行爬虫

总结 前言

在网络爬虫过程中,使用代理IP可以有效地解决IP被封禁的问题。为了更好地使用…

程序员如何开发高级python爬虫?

之前我有写过一篇“高级爬虫和低级爬虫的区别”的文章,我们知道它并非爬虫领域中专用术语。只是根据爬虫的复杂性来断定是否是高级爬虫。以我个人理解:高级爬虫是可能具有更复杂的功能和更高的灵活性的爬虫。下面我们围绕高级爬虫来了解下有趣的事情。 低…

工资10K,副业20K,这届程序员搞副业真野

最近刚完成了一个远程外包项目工作,钱刚到账,小金库又添了一笔: 从一开始的15K死工资,到现在的主业副业一共25K收入,最近的经济压力小了很多,终于也有闲钱和老婆去旅旅游,升级一下外设ÿ…

干货文:在 Mac 中卸载 Python 的方式

Mac 原本有预装了 Python,直接可以用。你也可以自己从官网下载相应的版本进行安装。但如果说,你现在不想用了,想卸载它也是可以的,几种方式吧,一个个来看。

首先,是直接在「应用程序」直接找到它ÿ…

Python和Scrapy构建可扩展的框架

构建一个可扩展的网络爬虫框架是利用Python和Scrapy实现高效数据采集的重要技能。在本文中,我将为您介绍如何使用Python和Scrapy搭建一个强大灵活的网络爬虫框架。我们将按照以下步骤展开:

1. 安装Scrapy: 首先,确保您已经安装了…

使用Scrapy框架集成Selenium实现高效爬虫

引言:

在网络爬虫的开发中,有时候我们需要处理一些JavaScript动态生成的内容或进行一些复杂的操作,这时候传统的基于请求和响应的爬虫框架就显得力不从心了。为了解决这个问题,我们可以使用Scrapy框架集成Selenium来实现高效的爬…

爬虫 scrapy ——scrapy shell调试及下载当当网数据(十一)

目录

一、scrapy shell

1.什么是scrapy shell? 2.安装 ipython

3.使用scrapy shell

二、当当网案例

1.在items.py中定义数据结构

2.在dang.py中解析数据

3.使用pipeline保存

4.多条管道的使用

5.多页下载

参考 一、scrapy shell

1.什么是scrapy shell&am…

第十六章 爬虫scrapy登录与中间件

文章目录 1. scrapy处理cookie1. 直接从浏览器复制cookie2.登录流程获取cookie 2. 中间件1. 请求中间件2. sittings文件中设置UserAgent3. 使用中间件配置代理4. 使用selenium获取页面信息 1. scrapy处理cookie

1. 直接从浏览器复制cookie

scrapy.Requests()中的cookies属于字…

scrapy爬虫系列之安装及入门介绍

前面介绍了很多Selenium基于自动测试的Python爬虫程序,主要利用它的xpath语句,通过分析网页DOM树结构进行爬取内容,同时可以结合Phantomjs模拟浏览器进行鼠标或键盘操作。但是,更为广泛使用的Python爬虫框架是——Scrapy爬虫。这是一篇在Windows系统下介绍 Scrapy爬虫安装及…

应用scrapy爬虫框架

Scrapy是一个基于Python的开源网络爬虫框架,它可以帮助我们快速、高效地抓取网页数据,并支持数据的自动化处理、存储和导出。Scrapy提供了丰富的扩展机制,可以轻松地实现各种自定义需求。

Scrapy的基本使用流程:

1、安装Scrapy框…

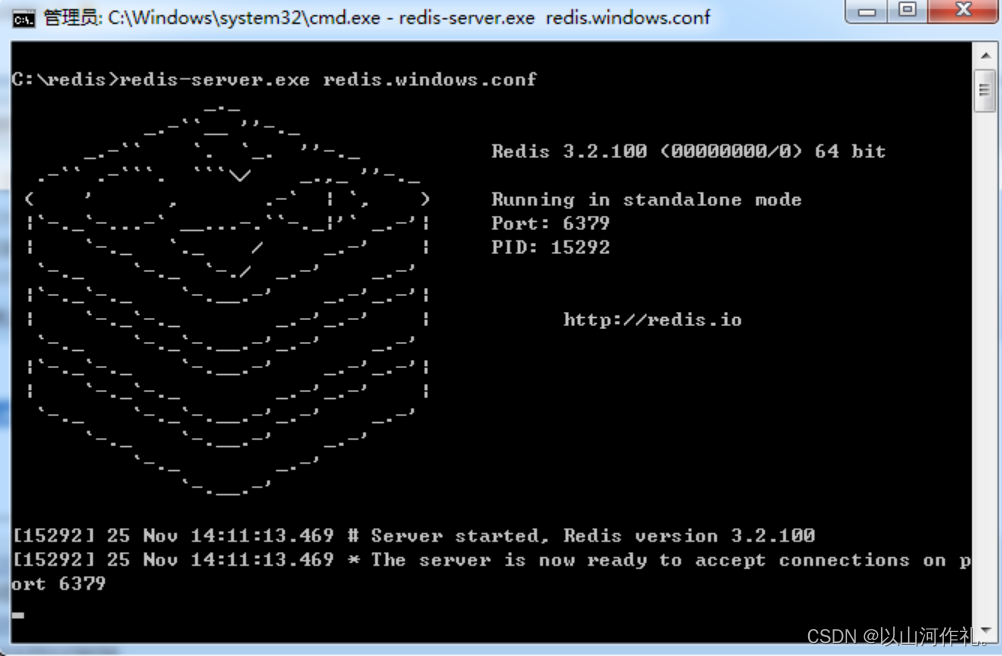

20.网络爬虫—Scrapy-Redis分布式爬虫

网络爬虫—Scrapy-redis详讲 Redis的安装与使用分布式概念和作用分布式爬虫分布式爬虫特点redis的使用Redis 操作/启动 Redis Desktop Manager下载特点和架构安装和使用Scrapy-redis 代码部署spider文件 settings文件 前言: 🏘️🏘️个人简介…

【Python从入门到进阶】48、当当网Scrapy项目实战(一)

接上篇《47、Scrapy Shell的了解与应用》 上一篇我们学习了Scrapy终端命令行工具Scrapy Shell,并了解了它是如何帮助我们更好的调试爬虫程序的。本篇我们将正式开启一个Scrapy爬虫项目的实战,对当当网进行剖析和抓取。

一、当当网介绍

当当网成立于199…

6-爬虫-scrapy解析数据(使用css选择器解析数据、xpath 解析数据)、 配置文件

1 scrapy解析数据 1.1 使用css选择器解析数据 1.2 xpath 解析数据

2 配置文件 3 整站爬取博客–》爬取详情–》数据传递

scrapy 爬虫框架补充

# 1 打码平台---》破解验证码-数字字母:ddddocr-计算题,滑块,成语。。。-云打码,超…

Scrapy爬虫简单实例

第一个Scrapy框架爬虫

我要爬取的网站是一个网课网站http://www.itcast.cn/channel/teacher.shtml,爬取内容是所有老师的基本信息。

1.创建一个基于Scrapy框架的爬虫项目

进入自定义的项目目录中,运行下列命令:

**ITCast为项目名字**

scr…

爬虫工作量由小到大的思维转变---<第一章 抓取>

引言:

传统上,Scrapy作为Python中的一款强大爬虫框架,因其便捷而得到广泛应用,尤其是在小到中型项目中的效率与方便性上无可匹敌。但在面对需要更加个性化的复杂项目时,Scrapy的固有结构可能不够灵活。此外࿰…

爬虫工作量由小到大的思维转变---<第二十六章 Scrapy通一通中间件的问题>

前言:

准备迈入scrapy-redis或者是scrapyd的领域进行一番吹牛~ 忽然想到,遗漏了中间件这个环节! 讲吧~太广泛了;不讲吧,又觉得有遗漏...所以,本章浅谈中间件;

(有问题,欢迎私信! 我写文告诉你解法)

正文: 当我们谈到 Scrapy 的中间件时,可以将其比作一个特殊的助…

python爬虫教程--Scrapy爬虫之旅

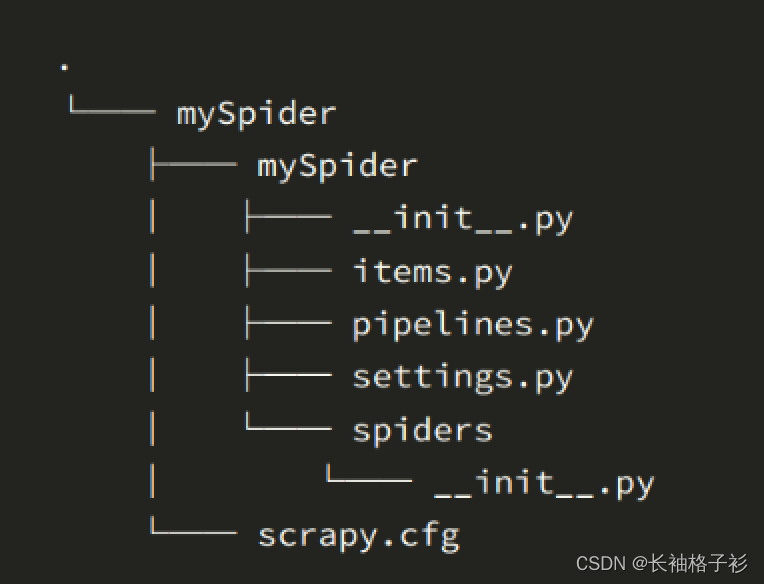

目录

一.Scarpy项目的目录结构

二.Scrapy常用令

1.全局命令

1.1 fetch命令

1.2 runspider命令

1.3 settings命令 1.4 shell命令

1.5 startproject命令

1.6 version命令

1.7 view命令

2.项目命令

2.1 Bench命令

2.2 Genspider命令 2.3 Check命令 2.4 Crawl命令…

python之Scrapy爬虫案例:豆瓣

运行命令创建项目:scrapy startproject scrapySpider进入项目目录:cd .\scrapySpider\运行命令创建爬虫:scrapy genspider douban movie.douban.com目录结构说明|-- scrapySpider 项目目录

| |-- scrapySpider 项目目录

| | |-- spider…

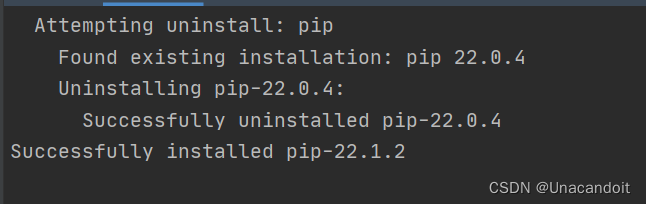

pycharm安装scrapy库时出现报错Error occurred when installing package ‘Scrapy‘

1.通过File-Setting-Pyhton Interpreter-安装scrapy时出现如下报错。该报错显示pip需要更新版本,而且这里建议在系统终端运行命令。那我们就根据提示一步步来解决。 2.切换到Terminal界面,在pycharm的下方找到该按钮 3.然后我们在terminal中运行命令&…

轻松实现文件按大小归类保存,高效管理你的文件库!

如果你像管理自己的财产一样管理你的文件,那么你一定需要一个能够轻松实现文件按大小归类保存的工具。今天,我要向大家介绍一款全新的文件管理软件,它能够将你的文件按照大小进行归类保存,让你的文件管理更加高效和有序࿰…

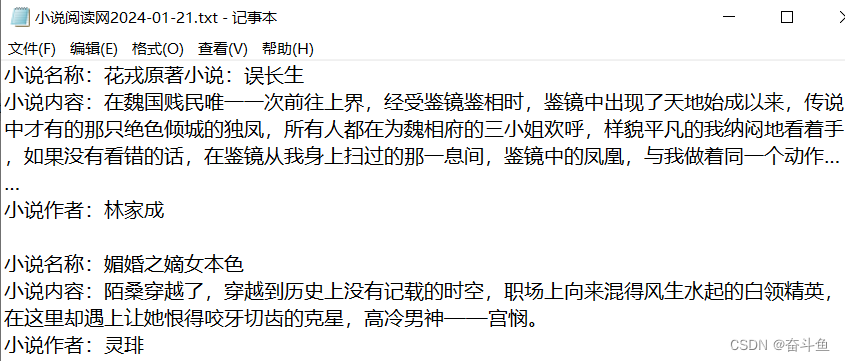

python:最简单爬虫之使用Scrapy框架爬取小说

python爬虫框架中,最简单的就是Scrapy框架。执行几个命令就能生成爬虫所需的项目文件,我们只需要在对应文件中调整代码,就能实现整套的爬虫功能。

以下在开发工具PyCharm中用简单的Demo项目来演示爬取小说网站的流程。我们打开小说网首页&am…

Scrapy爬取数据,使用Django+PyEcharts实现可视化大屏

项目介绍

使用Scrapy进行数据爬取,MySQL存储数据,Django写后端服务,PyEcharts制作可视化图表,效果如下。

项目下载地址:Scrapy爬取数据,并使用Django框架PyEcharts实现可视化大屏 发现每个模块都有详情页…

Scrapy-核心架构

在之前的文章中,我们已经学习了如何使用Scrapy框架来编写爬虫项目,那么具体Scrapy框架中底层是如何架构的呢?Scrapy主要拥有哪些组件,爬虫具体的实现过程又是怎么样的呢?

为了更深入的了解Scrapy的相关只是࿰…

爬虫工作量由小到大的思维转变---<第五章 Scrapy异常设置>

前言:

首先,确保大家都明白,无论我们做得多么小心,异常情况在爬虫中总会发生。比如说,服务器可能会突然宕机,或者页面结构变了导致我们的爬虫拿不到正确的数据。这就是为什么记录异常非常关键,这样当事情不…

Scrapy爬虫框架(概念)

Scrapy 入门教程 | 菜鸟教程 (runoob.com)

Scrapy是一个快速功能强大的网络爬虫框架

Scrapy的安装

通过 pip 安装 Scrapy 框架:

pip install Scrapy 安装后小测: 执行 scrapy ‐h Scrapy不是一个函数功能库,而是一个爬虫框架。

Scrapy架构图(绿线是…

高级深入--day38

阳光热线问政平台

http://wz.sun0769.com/index.php/question/questionType?type4

爬取投诉帖子的编号、帖子的url、帖子的标题,和帖子里的内容。

items.py

import scrapyclass DongguanItem(scrapy.Item):# 每个帖子的标题title scrapy.Field()# 每个帖子的编…

scrapy的入门和使用

scrapy的入门使用

学习目标:

掌握 scrapy的安装应用 创建scrapy的项目应用 创建scrapy爬虫应用 运行scrapy爬虫应用 scrapy定位以及提取数据或属性值的方法掌握 response响应对象的常用属性 1 安装scrapy

命令: sudo apt-get install scrapy 或者&#x…

Scrapy框架--settings配置 (详解)

目录 settings配置

官网-参考配置

配置文档 Scrapy默认BASE设置 settings配置 Scrapy框架中的配置文件(settings.py)是用来管理爬虫行为和功能的关键部分。它是一个Python模块,提供了各种配置选项,可以自定义和控制爬虫的行为。…

十三:爬虫-Scrapy框架(下)

一:各文件的使用回顾

1.items的使用

items 文件主要用于定义储存爬取到的数据的数据结构,方便在爬虫和 Item Pipeline 之间传递数据。

items.pyimport scrapyclass TencentItem(scrapy.Item):# define the fields for your item here like:title scr…

爬虫框架Scrapy学习笔记-3

Scrapy管道详解:数据存储和图片下载

引言

在网络爬虫开发中,数据的存储和处理是至关重要的环节。Scrapy作为Python中一款强大的网络爬虫框架,提供了丰富的数据存储和处理功能,其中最重要的概念之一就是管道(Pipeline…

Scrapy简介-快速开始-项目实战-注意事项-踩坑之路

scrapy项目模板地址:https://github.com/w-x-x-w/Spider-Project

Scrapy简介

Scrapy是什么?

Scrapy是一个健壮的爬虫框架,可以从网站中提取需要的数据。是一个快速、简单、并且可扩展的方法。Scrapy使用了异步网络框架来处理网络通讯&…

【Python_Scrapy学习笔记(一)】Scrapy框架简介

Scrapy框架简介

前言

Scrapy 框架是一个用 python 实现的为了爬取网站数据、提取数据的应用框架,使用 Twisted 异步网络库来处理网络通讯,可以高效的完成数据爬取。本文主要介绍 Scrapy 框架的构成与工作原理。

正文

1、Scrapy安装

Windows安装&…

高级深入--day41

用Pymongo保存数据

爬取豆瓣电影top250movie.douban.com/top250的电影数据,并保存在MongoDB中。

items.py

class DoubanspiderItem(scrapy.Item):# 电影标题title scrapy.Field()# 电影评分score scrapy.Field()# 电影信息content scrapy.Field()# 简介info …

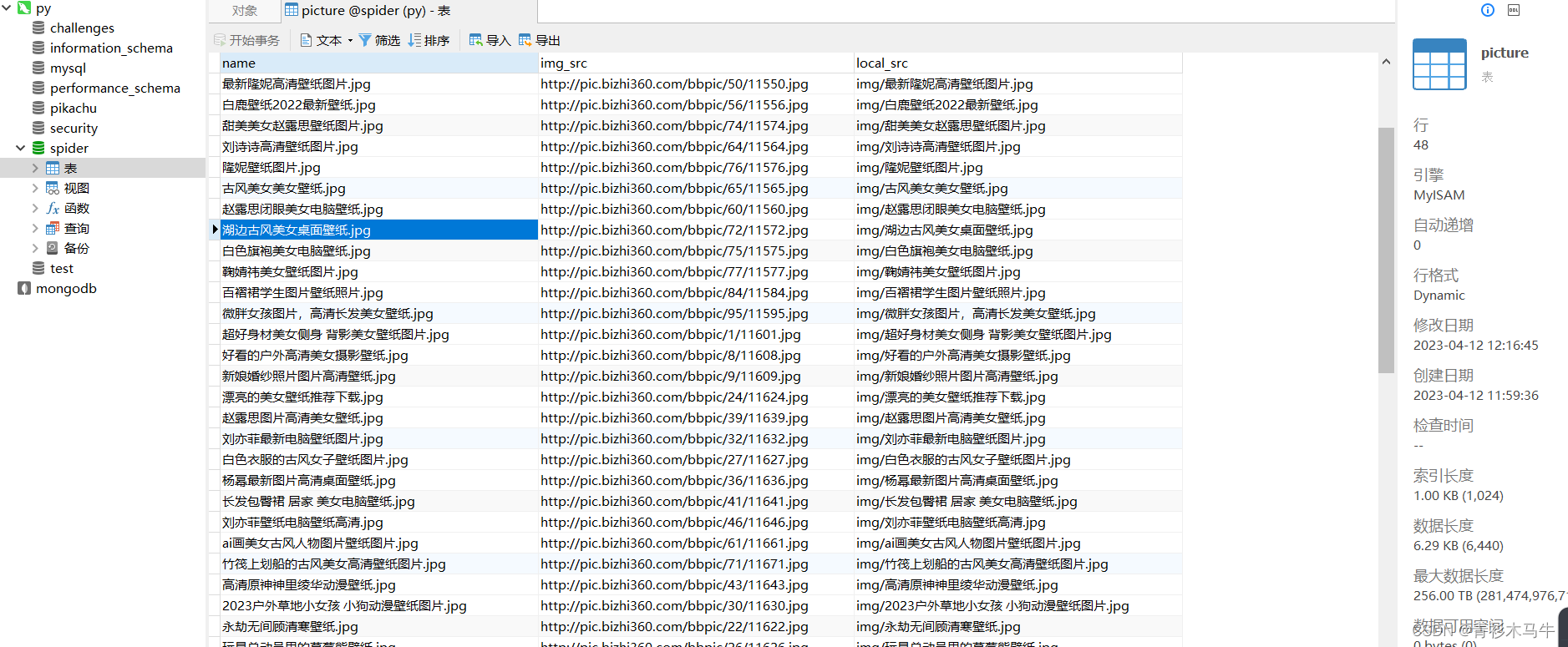

scrapy框架爬取某壁纸网站美女壁纸 + MySQL持久化存储

文章目录 准备工作创建项目:设置(settings) 主程序入口meinv.py思路源代码 items 配置管道pipelines源代码 效果图总结 准备工作

创建项目: scraoy startproject bizhi cd bizhi scrapy genspider meinv bizhi360.com 设置&#…

爬虫scrapy:房天下数据

项目结构: fangtianxia.py

import scrapy

from fangtianxia_1.items import Fangtianxia1Item

import re

from datetime import datetime

from fangtianxia_1.items import CityTotalCountItemclass FangtianxiaSpider(scrapy.Spider):name fangtianxia# allowed_…

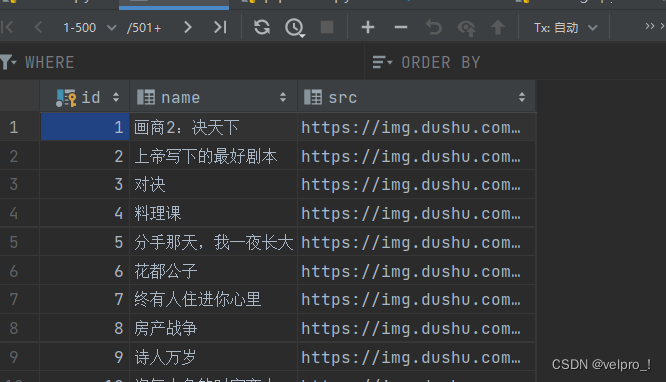

Python爬虫——scrapy_读书网数据入库和链接跟进

数据入库 先创建一个数据库

create table book(id int primary key auto_increment,name varchar(128),src varchar(128));settings.py

DB_HOST 169.254.38.183

# 端口号是一个整数

DB_PORT 3306

DB_USER root

DB_PASSWORD 123456

# 数据库名称

DB_NAME spider01

DB_CHA…

数据采集:亚马逊畅销书的数据可视化图表

导语

亚马逊是全球最大的电子商务平台之一,它提供了各种类别的商品,其中包括图书。亚马逊每天都会更新它的畅销书排行榜,显示不同类别的图书的销量和评价。如果我们想要分析亚马逊畅销书的数据,我们可以使用爬虫技术来获取网页上…

【Python】scrapy 命令提示找不到文件

问题记录:

执行以下命令的时候返回了找不到文件

scrapy startproject myproject具体信息如下

bash: /usr/local/bin/scrapy: No such file or directory查看 /usr/local/bin/ 目录确实没有 scrapy。

注:/usr/local/bin/ 目录一般存放应用执行文件的软…

[爬虫] B站番剧信息爬取

申明:本文对爬取的数据仅做学习使用,不涉及任何商业活动,侵删 简述

本次爬取目标是: 番剧的基本信息(名字, 类型, 集数, 连载or完结, 链接等)番剧的参数信息(播放量, 点赞, 投币, 追番人数等)时间信息(开播时间, 完结时间) 前提条…

Scrapy的基本使用

目录 Scrapy是什么

安装

使用

获取更多页面信息

写入数据库

图片下载

文件下载

更改文件名称以及路径

更改图片名称以及路径

循环获取页面信息时,item的数据重复或者对不上

下载文件时获取文件流直接上传到某个地方 Scrapy是什么

Scrapy 是一个基于 Pyth…

Python爬虫入门系列之Scrapy爬取Ajax网页

Python爬虫入门系列之Scrapy爬取Ajax网页 在前几篇博客中,我们学习了如何使用Scrapy框架爬取静态和动态网页。然而,有些网页使用Ajax技术加载数据,这就需要我们使用特殊的方法来获取这些网页的内容。本篇博客将介绍如何使用Scrapy爬取Ajax网页…

11.Scrapy框架基础-使用Scrapy抓取数据并保存到mongodb

目录

一、Scrapy安装

1.mac系统

2.windows系统

二、使用scrapy爬取数据

1.新建一个scrapy工程

2.在spiders下新建一个爬虫文件

3.提取网页数据

三、保存数据到mongodb

四、再多学一点

1.添加请求头

2.Robot.txt设置

3.爬取多个页面

五、作业(这是一个考…

Scrapy-安装与配置

Scrapy,Python开发的一个快速、高层次的屏幕抓取和web抓取框架,用于抓取web站点并从页面中提取结构化的数据。Scrapy用途广泛,可以用于数据挖掘、监测和自动化测试。

Scrapy吸引人的地方在于它是一个框架,任何人都可以根据需求方…

【Python从入门到进阶】46、58同城Scrapy项目案例介绍

接上篇《45、Scrapy框架核心组件介绍》 上一篇我们学习了Scrapy框架的核心组件的使用。本篇我们进入实战第一篇,以58同城的Scrapy项目案例,结合实际再次巩固一下项目结构以及代码逻辑的用法。

一、案例网站介绍

58同城是一个生活服务类平台,…

两种数据提取框架的比较(scrapy和webmagic)

背景: 最近北京疫情有点严重,状态是居家办公,又是买菜做饭又是核酸检测心情是无比的烦躁还总是会议,无需发言的会议就边听边写写csdn记录一下。这几天在用Java写一个数据抓取的程序,用于数据分析等等。第一是因为原项目…

Scrapy API 启动爬虫

scarpy 不仅提供了 scrapy crawl spider 命令来启动爬虫,还提供了一种利用 API 编写脚本 来启动爬虫的方法。

scrapy 基于 twisted 异步网络库构建的,因此需要在 twisted 容器内运行它。

可以通过两个 API 运行爬虫:scrapy.crawler.Crawler…

win10 安装scrapy 出现LINK : fatal error LNK1158: cannot run 'rc.exe' 错误的解决办法

在安装scrapy时出现如下错误: Finished generating code LINK : fatal error LNK1158: cannot run rc.exe error: command C:\\Program Files (x86)\\Microsoft Visual Studio 14.0\\VC\\BIN\\x86_amd64\\link.exe failed with exit status 1158 ----------…

解决windows下使用pip install scrapy报错cannot open include file: 'io.h':....问题

问题背景:

windows10 Anacoda3 环境,在使用pip 安装scrapy 安装包时报错:提示要安装Visual C Build Tools 于是在windows10安装 但是我安装完之后,还是报同样的错误,于是Google一下: 于是继续下载 window…

scrapy中登录时保持验证码cookies的一致性

文章目录一、为什么要保持验证码cookies的一致性?二、requests和scrapy中保持验证码cookies一致的方法1.requests2.scrapy三、总结一、为什么要保持验证码cookies的一致性?

众所周知,http是无状态的请求,每一次访问都代表一次新的…

【Bug——Python】AttributeError: module ‘OpenSSL.SSL’ has no attribute ‘SSLv3_METHOD

这个错误是由于在OpenSSL.SSL模块中找不到SSLv3_METHOD属性导致的。解决这个问题的方法如下: 首先,确保你已经安装了最新版本的cryptography和pyOpenSSL。你可以使用以下命令卸载并重新安装它们: 卸载cryptography:pip uninstall …

【Python网络爬虫入门教程3】成为“Spider Man”的第三课:从requests到scrapy、爬取目标网站

Python 网络爬虫入门:Spider man的第三课 写在最前面从requests到scrapy利用scrapy爬取目标网站更多内容 结语 写在最前面

有位粉丝希望学习网络爬虫的实战技巧,想尝试搭建自己的爬虫环境,从网上抓取数据。

前面有写一篇博客分享࿰…

7-爬虫-中间件和下载中间件(加代理,加请求头,加cookie)、scrapy集成selenium、源码去重规则(布隆过滤器)、分布式爬虫

0 持久化(pipelines.py)使用步骤

1 爬虫中间件和下载中间件 1.1 爬虫中间件(一般不用) 1.2 下载中间件(代理,加请求头,加cookie) 1.2.1 加请求头(加到请求对象中) 1.2.2 加cookie 1.2.3 加代理

2 scrapy集成selenium

3 源码去重…

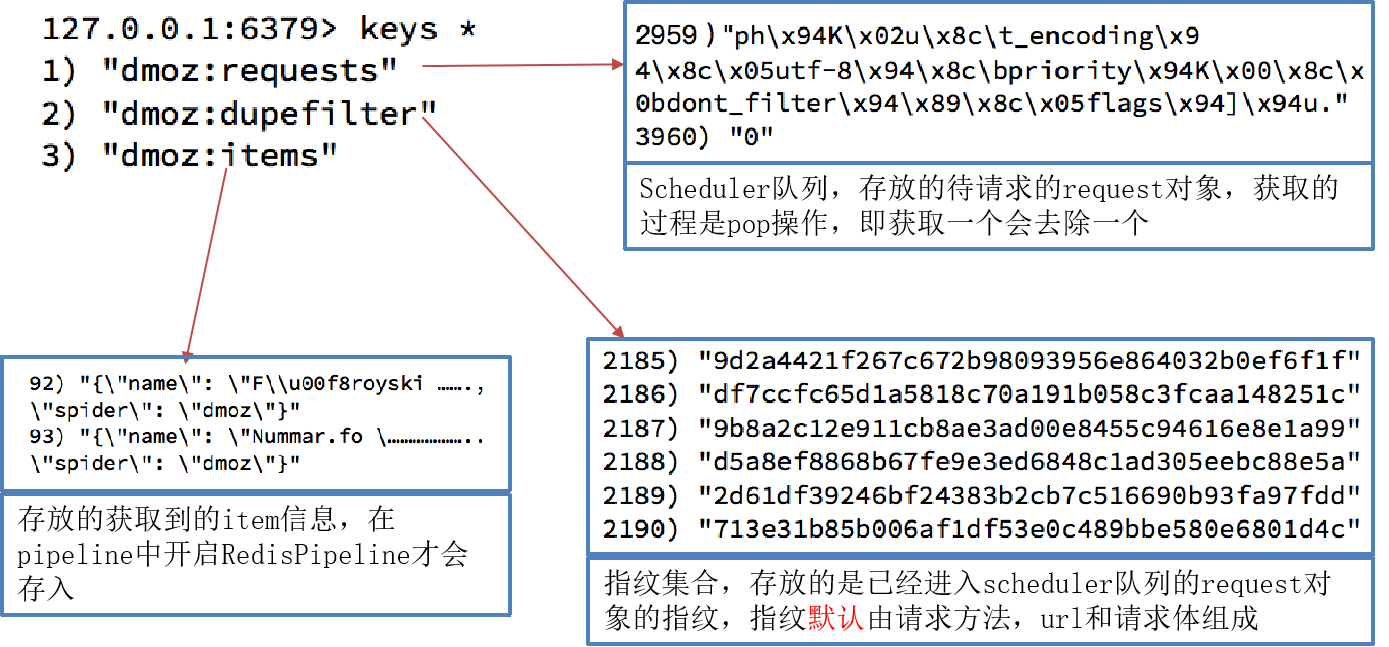

scrapy_redis原理分析并实现断点续爬以及分布式爬虫

scrapy_redis原理分析并实现断点续爬以及分布式爬虫

学习目标

了解 scrapy实现去重的原理了解 scrapy中请求入队的条件掌握 scrapy_redis基于url地址的增量式单机爬虫掌握 scrapy_redis分布式爬虫 1. 下载github的demo代码 clone github scrapy-redis源码文件 git clone http…

关于 scrapy 中 COOKIES_ENABLED 设置

在 Scrapy 框架中,COOKIES_ENABLED True 时,除了可以在 Request 对象中手动设置 cookies 以外,还可以通过修改 DEFAULT_REQUEST_HEADERS 来全局地为每个请求设置 cookies。以下是一个包含这一信息的博客笔记: Scrapy 爬虫中 Cook…

python爬虫进阶篇:Scrapy中使用Selenium+Firefox浏览器爬取国债逆回购并发送QQ邮件通知

一、前言

每到年底国债逆回购的利息都会来一波高涨,利息会比银行的T0的理财产品的利息高,所以可以考虑写个脚本每天定时启动爬取逆回购数据,实时查看利息,然后在利息高位及时去下单。

二、环境搭建

详情请看《python爬虫进阶篇…

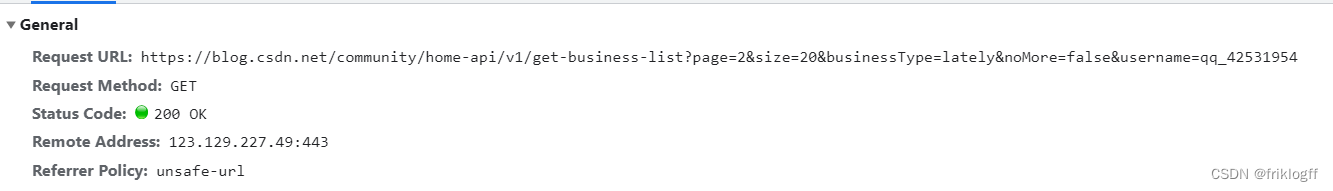

scrapy初学习--爬取自己csdn博客全部的文章链接

爬取自己csdn博客全部的文章链接

首先观察自己文章目录列表的url 可以很方便地构造出全部的目录url, 每个url中有20个博客文章

然后根据这些url分析源代码, 找出唯一标示元素的信息. 但我发现一个问题

有一篇不是我的文章也在源代码里面. 分析发现, 他的标示和我的有点不一…

Rust与python联动进行多线程跑数据

最近有个学弟想请教我联动多线程爬取数据的案例,看了以前的模版没有合适的,我就利用空闲时间,专门给他写了一段模版作为参考。这里遇到注意的是需要代理IP介入,才能让多线程爬取减少网站风控限制。 以下是一个使用 Rust 编写的爬虫…

python爬虫之Scrapy框架--保存图片(详解)

目录

Scrapy 使用ImagePipeline 保存图片

使用图片管道

具体步骤

安装相关的依赖库

创建Scrapy项目

配置settings.py 定义Item 编写Spider

运行Spider

Scrapy 自定义ImagePipeline

自定义图片管道 Scrapy 使用ImagePipeline 保存图片 Scrapy提供了一个 ImagePipelin…

爬虫scrapy中间件的使用

爬虫scrapy中间件的使用

学习目标:

应用 scrapy中使用间件使用随机UA的方法应用 scrapy中使用代理ip的的方法应用 scrapy与selenium配合使用 1. scrapy中间件的分类和作用

1.1 scrapy中间件的分类

根据scrapy运行流程中所在位置不同分为:

下载中间件…

Scrapy框架内置管道之图片视频和文件(一篇文章齐全)

1、Scrapy框架初识(点击前往查阅)

2、Scrapy框架持久化存储(点击前往查阅)

3、Scrapy框架内置管道

4、Scrapy框架中间件(点击前往查阅) Scrapy 是一个开源的、基于Python的爬虫框架,它提供了…

用Python和Scrapy来构建强大的网络爬虫

前言

构建强大的网络爬虫是一个复杂而有挑战性的任务。Python和Scrapy是两个强大的工具,可以帮助我们完成这个任务。在本文中,我将向您展示如何使用Python和Scrapy构建一个强大的网络爬虫,并且还将介绍如何使用代理IP来更好地爬取目标网站。…

爬虫工作量由小到大的思维转变---<第三十三章 Scrapy Redis 23年8月5日后会遇到的bug)>

前言:

收到回复评论说,按照我之前文章写的:

爬虫工作量由小到大的思维转变---<第三十一章 Scrapy Redis 初启动/conn说明书)>-CSDN博客

在启动scrapy-redis后,往redis丢入url网址的时候遇到:

TypeError: ExecutionEngine.crawl() got an unexpected …

爬虫工作量由小到大的思维转变---<第八章 Scrapy之Item多级页面策略>

前言: 如果你也是在爬虫的世界里摸爬滚打的话,那你肯定理解,抓取数据的时候,我们常常需要打交道的不只是表面的那些一级页面。很多时候,数据分散在多个层级的页面上,需要我们一层层地深挖,最后集合成一个完…

爬虫工作量由小到大的思维转变---<Scrapy异常的存放小探讨>

前言:

异常很正常,调试异常/日志异常/错误异常~ 但在爬虫的时候,写完代码运行后挡不住一些运行异常;于是,很多都把异常写到了中间件~ 当然,这也没有错; 不过,其实可以直接这么设计一下...

正文:

参照一下中间件的异常

def process_exception(self, request, exception, spi…

scrapy框架爬取数据(创建一个scrapy项目+xpath解析数据+通过pipelines管道实现数据保存+中间件)

目录

一、创建一个scrapy项目

二、xpath解析数据

三、通过pipelines管道实现数据保存

四、中间件 一、创建一个scrapy项目

1.创建一个文件夹:C06

在终端输入以下命令:

2.安装scrapy:pip install scrapy

3.来到文件夹下:cd C06

4.创建…

爬虫工作量由小到大的思维转变---<第二十七章 Scrapy的暂停和重启>

前言:

一个小知识点,刚刚有朋友私信我的; 就是scrapy的暂停与重启;

没什么可讲的,就是一个命令,还有需要注意的一个地方,我就当留言板来写这篇吧!

正文:

首先,如果我们在控制台中,一般都是用ctrlc进行停止;(ctrlc一次是暂停,两次是终止)

而如果想让scrapy继续第一次爬完之…

【进阶】【Python网络爬虫】【18.爬虫框架】scrapy深入,CrawlSpider全栈爬取(附大量案例代码)(建议收藏)

Python网络爬虫 一、Scrapy 深入案例 - qd_09_diaoyuitems.pymiddlewares.pypiplines.pysettings.pyspidersdiaoyu.pydiaoyu_manyitem.py 案例 - qd_10_liangliitems.pymiddlewares.pypipelines.pysettings.pyspidersliangli.pyliangli_extend.py 案例 - qd_11_duitangitems.py…

高级深入--day37

手机App抓包爬虫

1. items.py

class DouyuspiderItem(scrapy.Item):name = scrapy.Field()# 存储照片的名字imagesUrls = scrapy.Field()# 照片的url路径imagesPath = scrapy.Field()# 照片保存在本地的路径2. spiders/douyu.py

import scrapy

import json

from douyuSpider…

爬虫工作量由小到大的思维转变---<第二十四章 Scrapy的`统计数据`收集stats collection ---12月26日补>

前言:

前两篇是讲的数据诊断分析,还有一篇深挖解决内存泄漏的文章,目前我还没整理汇编出来;但是,想到分析问题的时候,忽然觉得爬虫的数据统计好像也挺重要;于是,心血来潮准备来插一篇这个------让大家对日常scrapy爬的数据,做到心里有数!不必自己去搅破脑汁捣腾日志,敲计算器了…

爬虫工作量由小到大的思维转变---<第三十八章 Scrapy redis里面的item问题 >

前言:

Item是Scrapy中用于保存爬取到的数据的容器,而Scrapy-Redis在存储Item时带来了一些变化和灵活性。因此,需要把它单独摘出来讲一讲,很重要!

正文:

存储形式

Scrapy-Redis中的Item存储方式可以有多种形式,以下是几种常见的形式及其适用情况&…

Scrapy框架中的Middleware扩展与Scrapy-Redis分布式爬虫

在爬虫开发中,Scrapy框架是一个非常强大且灵活的选择。在本文中,我将与大家分享两个关键的主题:Scrapy框架中的Middleware扩展和Scrapy-Redis分布式爬虫。这些主题将帮助你更好地理解和应用Scrapy框架,并提升你的爬虫开发技能。

…

高级深入--day34

Request

Request 部分源码:

# 部分代码

class Request(object_ref):def __init__(self, url, callback=None, method=GET, headers=None, body=None, cookies=None, meta=None, encoding=utf-8, priority=0,dont_filter=False, errback=None):self._encoding = encoding # …

爬虫工作量由小到大的思维转变---<第二十九章 Scrapy的重试机制(避混淆)>

前言:

单纯讲重试的问题---因为今天有人私了我 他的代码,我忽然觉得这里有一个误区;顺便给哥们你混淆的理论里,再搅和搅和....哈哈哈 正文:

拨乱反正:

在Scrapy中,默认情况下,当一个请求失败时,会进行自动重试。重试次数的计算是基于原始请…

十二:爬虫-Scrapy框架(上)

一:Scrapy介绍

1.Scrapy是什么?

Scrapy 是用 Python 实现的一个为了爬取网站数据、提取结构性数据而编写的应用框架(异步爬虫框架) 通常我们可以很简单的通过 Scrapy 框架实现一个爬虫,抓取指定网站的内容或图片 Scrapy使用了Twisted异步网…

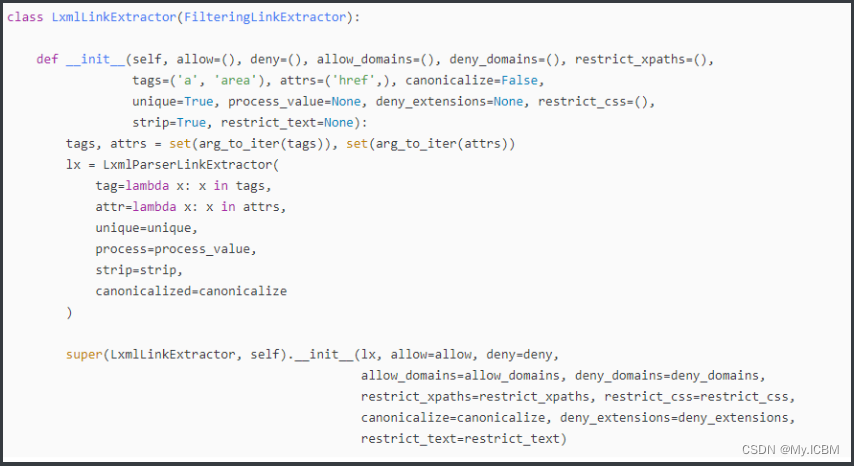

Scrapy框架--CrawlSpider (详解+例子)

目录

CrawlSpider

简介

基本运行 特性和概念

基本使用

创建CrawlSpider 运行 使用CrawlSpider中核心的2个类对象

Rule对象

LinkExtractors

作用

使用

查看效果-shell中验证

示例

注意 CrawlSpider

简介

CrawlSpider 是 Scrapy 框架提供的一个特殊的 Spider 类…

Scrapy使用和学习笔记

前言

Scrapy是非常优秀的一个爬虫框架,基于twisted异步编程框架。yield的使用如此美妙。基于调度器,下载器可以对scrapy扩展编程。插件也是非常丰富,和Selenium,PlayWright集成也比较轻松。

当然,对网页中的ajax请求…

Scrapy爬虫框架安装与介绍

Scrapy爬虫框架也是爬虫项目常用的框架之一,Scrapy通过Python 编写,台式一个快速、高层次的屏幕抓取和网页抓取框架,Scrapy框架的用途广泛,可以用于数据挖掘、监测和自动化测试。

Srapy框架的安装:

无论是在windows还…

scrapy的入门使用

1 安装scrapy

命令:

sudo apt-get install scrapy或者:

pip/pip3 install scrapy2 scrapy项目开发流程

创建项目:

scrapy startproject mySpider生成一个爬虫:

scrapy genspider itcast itcast.cn提取数据: 根据网站结构在spider中实现数据采集相关内…

使用Python库Scrapy的程序

使用Python库Scrapy的程序。首先,我们需要使用Scrapy框架来编写下载器程序。

python import scrapy import requests from bs4 import BeautifulSoup from scrapy.pipelines.images import ImagesPipeline from scrapy.exceptions import DropItem

class MySpider…

轻松管理不同类型的文件,高效将文件按类型进行移动归类

如果你经常需要处理不同类型的文件素材,例如图片、音频、视频等,那么你一定知道这是一项繁琐的任务。为了帮助你快速整理这些文件,我们推出了一款强大的文件管理工具,让你能够轻松地将不同类型的文件素材归类到不同文件夹里单独保…

Python数据分析:爬虫框架scrapy基础知识点

Python数据分析:爬虫框架scrapy基础知识点

scrapy简介:

开源的爬虫框架快速强大,只需编写少量代码即可完成爬取任务易扩展,添加新的功能模块

scrapy抓取过程:

使用start_urls作为初始url生成Request,默…

python爬虫进阶篇:Scrapy中使用Selenium+Firefox浏览器爬取沪深A股股票行情

一、前言

上篇记录了Scrapy搭配selenium的使用方法,有了基本的了解后我们可以将这项技术落实到实际需求中。目前很多股票网站的行情信息都是动态数据,我们可以用Scrapyselenium对股票进行实时采集并持久化,再进行数据分析、邮件通知等操作。…

强大的开源网络爬虫框架Scrapy的基本介绍(入门级)

Scrapy 是一个强大的开源网络爬虫框架,用于从网站上抓取数据。它基于 Twisted 异步网络框架,可以高效地处理并发请求和数据处理。

以下是 Scrapy 框架的一些重要特点和功能:

1. **灵活的架构**: - Scrapy 提供了灵活的架构&a…

Scrapy爬虫模拟登陆参考demo

对于一些刚入行爬虫的小伙伴来说,刚开始的时候觉得所有的网站无非就是分析HTML、json数据,很容易忽忽略掉一个很重要的问题,那就是目标网站的反爬虫策略,很多目标网站为了反爬虫经常更新反爬策略,我们想要拿到数据&…

Python中Scrapy框架搭建ip代理池教程

在网络爬虫开发中,使用代理IP池可以提高爬取效率和匿名性,避免被目标网站封禁IP。本文将介绍如何使用Python中的Scrapy框架搭建IP代理池,并提供代码实例,帮助您快速搭建一个稳定可靠的代理池。 Python中Scrapy框架搭建ip代理池教程…

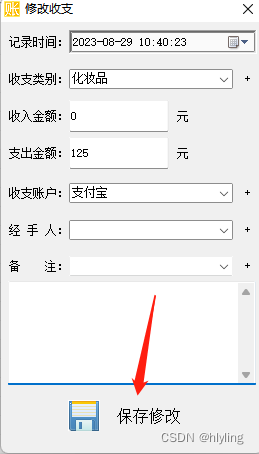

收支明细管理实操:如何准确记录并修改收支明细?

宣传软文: 在日常生活中,收支明细的管理至关重要,无论是个人还是企业。准确的记录不仅能有效管理财务,还能提供清晰的依据以供分析和决策。但在实际操作中,可能出现记录错误的情况。本文将详细介绍如何记录和修改收支明…

scrapy模拟登陆

1 回顾之前的模拟登陆的方法

1.1 requests模块实现模拟登陆

直接携带cookies请求页面找url地址,发送post请求存储cookie

1.2 selenium模拟登陆

找到对应的input标签,输入账号和密码后定位到登录的元素位置点击登陆

1.3 scrapy有三种方法模拟登陆

直…

python多线程编程: 如何暴力但不失优雅地关闭线程

多i线程编程中,常常遇到的1个头痛问题是,主线程退出后,子线程未能正常退出,造成一些数据丢失,文件破坏的隐患,或者成为僵尸进程,占用系统资源。 前面文章介绍了几种优雅关闭线程的方法ÿ…

爬虫工作量由小到大的思维转变---<第四十五章 Scrapyd 关于gerapy遇到问题>

前言:

本章主要是解决一些gerapy遇到的问题,会持续更新这篇! 正文:

问题1:

1400 - build.py - gerapy.server.core.build - 78 - build - error occurred (1, [E:\\项目文件名\\venv\\Scripts\\python.exe, setup.py, clean, -a, bdist_uberegg, -d, C:\\Users\\Administrat…

爬虫 scrapy (十二)

目录

一、创建爬虫项目及文件

二、获取电影名和图片 爬取电影天堂的电影名、图片,图片地址位于电影名的下一层链接中。 获取标题,点击链接 再获取这一页的图片 一、创建爬虫项目及文件 scrapy startproject scrapy_099 scrapy genspider movie http:…

【python爬虫】15.Scrapy框架实战(热门职位爬取)

文章目录 前言明确目标分析过程企业排行榜的公司信息公司详情页面的招聘信息 代码实现创建项目定义item 创建和编写爬虫文件存储文件修改设置 代码实操总结 前言

上一关,我们学习了Scrapy框架,知道了Scrapy爬虫公司的结构和工作原理。 在Scrapy爬虫公司…

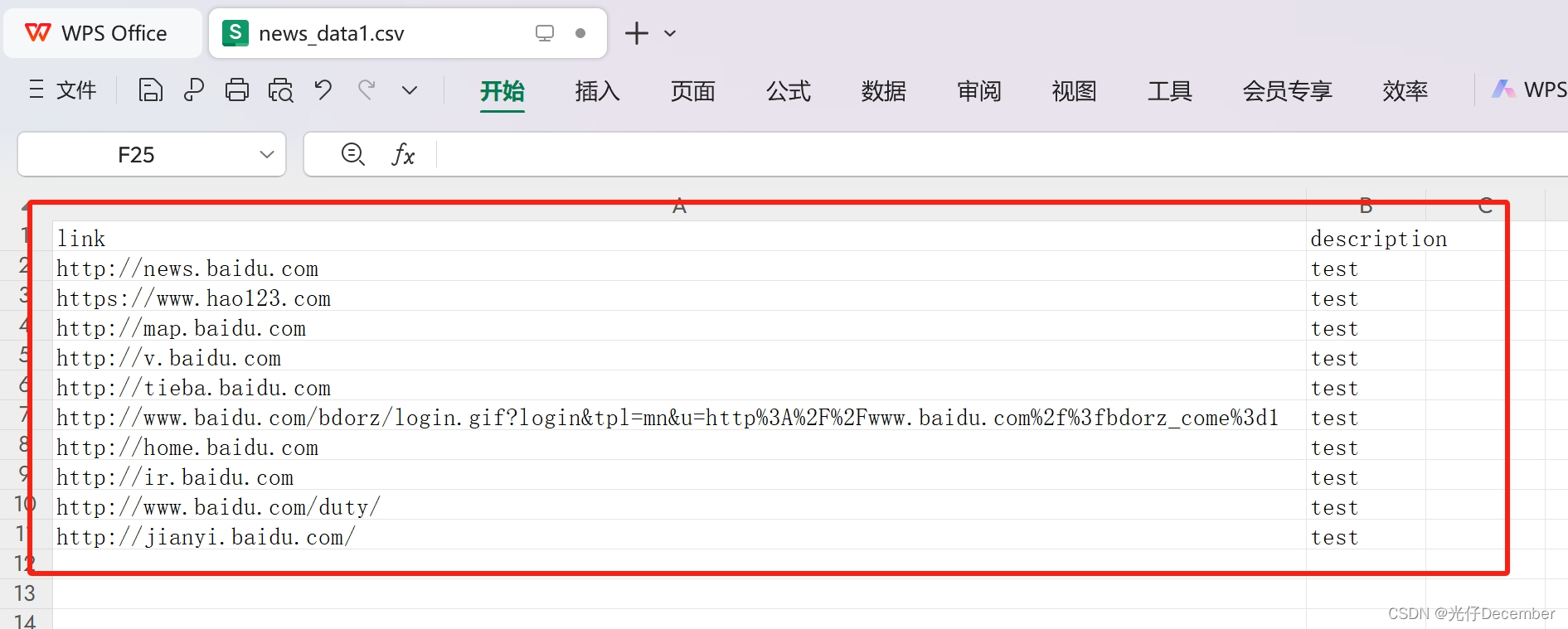

Python爬虫进阶:使用Scrapy库进行数据提取和处理

在我们的初级教程中,我们介绍了如何使用Scrapy创建和运行一个简单的爬虫。在这篇文章中,我们将深入了解Scrapy的强大功能,学习如何使用Scrapy提取和处理数据。

一、数据提取:Selectors和Item

在Scrapy中,提取数据主要…

scrapy pipelines

1.时间的处理

获取当前时间的字符串

# 创建一个datetime对象并设置为当前时间,该时间少8小时

dt datetime.datetime.now()

# 将datetime转换为本地时区

local_tz pytz.timezone(Asia/Shanghai)

local_dt local_tz.localize(dt)

# 将datetime对象格式化为ISO 86…

scrapy爬虫之网站图片爬取

Scrapy是一个强大的Python爬虫框架,可以用于爬取网站上的各种数据,包括图片。以下是一个简单的示例,演示如何使用Scrapy来爬取网站上的图片: 安装Scrapy:

如果尚未安装Scrapy,可以使用以下命令安装它&…

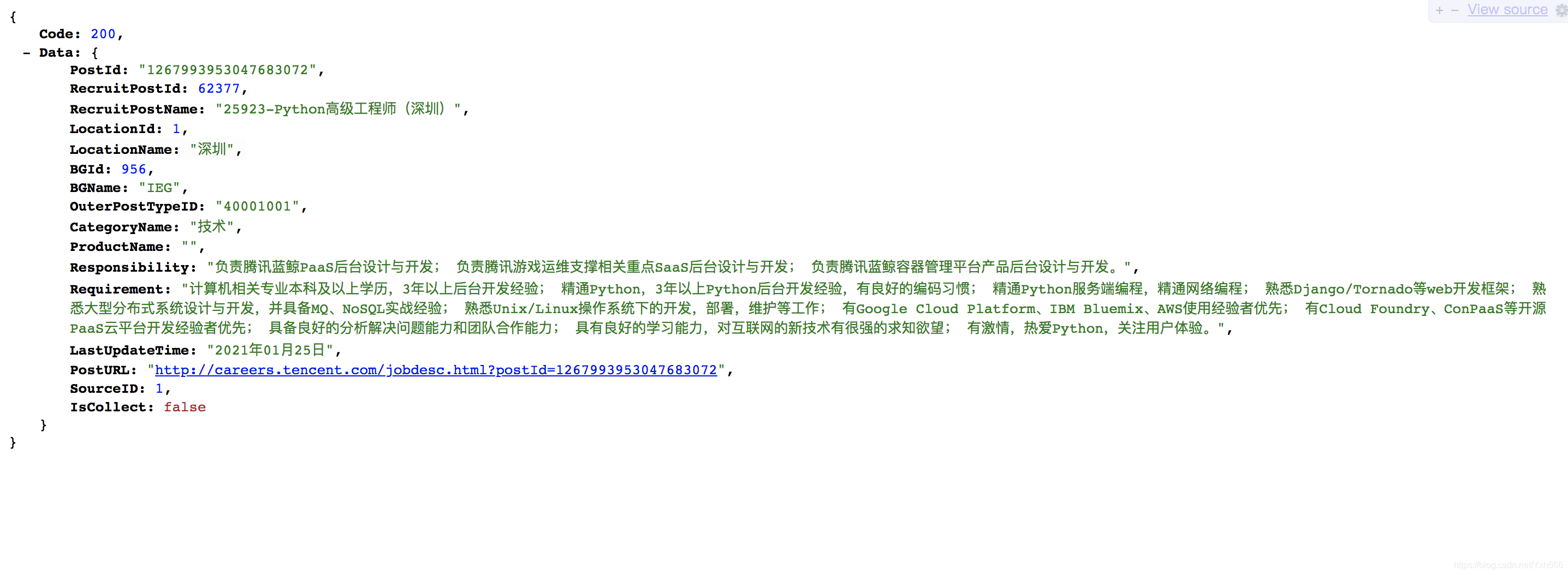

使用scrapy框架爬取腾讯招聘的岗位

本篇将介绍使用scrapy爬取动态加载网站的方法,这样的网站我们很常见,我们这次就是爬取腾讯招聘的岗位数据

我们爬取的是这个页面里的岗位数据 点进去后是显示的是所有的岗位,我们想要什么岗位就直接搜就可以 比如我们搜一个python方面的岗位…

打破常规思维:Scrapy处理豆瓣视频下载的方式

概述

Scrapy是一个强大的Python爬虫框架,它可以帮助我们快速地开发和部署各种类型的爬虫项目。Scrapy提供了许多方便的功能,例如请求调度、数据提取、数据存储、中间件、管道、信号等,让我们可以专注于业务逻辑,而不用担心底层的…

柯桥学俄语|商务俄语двое型与оба (обе) 型集合数词用法攻略

двое型集合数词 1. двое型集合数词与名词、形容词连用的规则与数词пять相同。用于第一格及同一格的第四格时,名词、形容词用复数二格;其他各格时,名词、形容词使用复数同格。 2. 仅有复数形式的名词表示2/3/4的数量用于一格及同一…

架构学习(四):scrapy下载中间件实现动态切换User-Agent

scrapy下载中间件实现动态与固定UserAgent 前言关卡:实现动态切换User-Agentscrapy设置User-Agent方式梳理User-Agent生效梳理为何选择在下载中间件中实现自定义User-Agent下载中间件 结束 前言

请求头User-Agent是比较常规的反爬手段,不同站点对其检测…

Scrapy-请求和响应

Scrapy使用Request和Response对象来爬行网站。通常,Request对象是在爬虫中生成的,并在整个系统中传递,直到它们到达下载器,后者执行请求并返回一个Response对象,该对象返回发出Request的爬虫。

Request和Response类都…

【Python_Scrapy学习笔记(三)】Scrapy框架之全局配置文件settings.py详解

Scrapy框架之全局配置文件settings.py详解

前言

settings.py 文件是 Scrapy框架下,用来进行全局配置的设置文件,可以进行 User-Agent 、请求头、最大并发数等的设置,本文中介绍 settings.py 文件下的一些常用配置

正文

1、爬虫的项目目录…

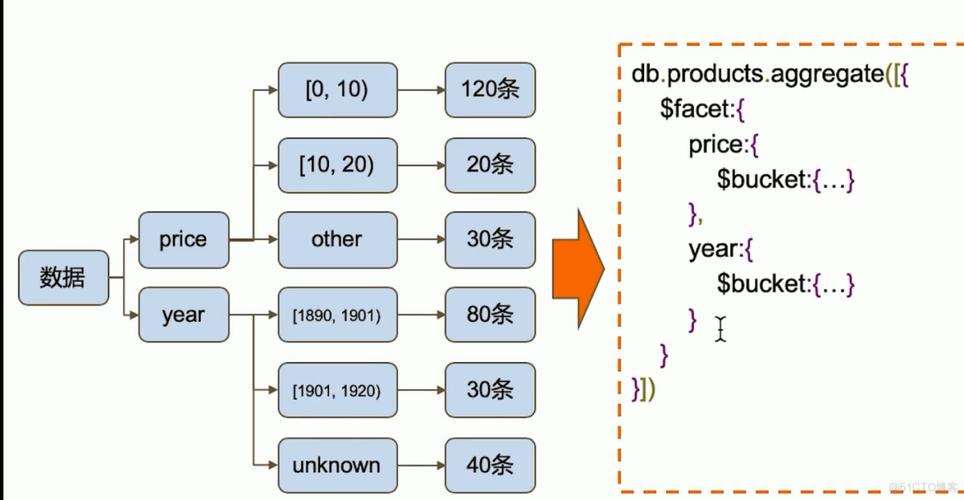

Scrapy框架之MongoDB聚合操作

目录

MongoDB聚合操作

聚合操作的基本语法 常用的聚合操作

管道命令之$group

按照某个字段进行分组

详解

计算集合中某个字段的平均值

常用表达式

管道命令之$match

示例

管道命令之$sort

管道命令之$skip 和 $limit

管道命令之$project MongoDB聚合操作

在…

【Python_Scrapy学习笔记(七)】基于Scrapy框架实现数据持久化

基于 Scrapy框架实现数据持久化

前言

本文中介绍 如何基于 Scrapy 框架实现数据持久化,包括 Scrapy 数据持久化到 MySQL 数据库、MangoDB数据库和本地 csv 文件、json 文件。

正文

1、Scrapy数据持久化到MySQL数据库 在 settings.py 中定义 MySQL 相关变量 # 定…

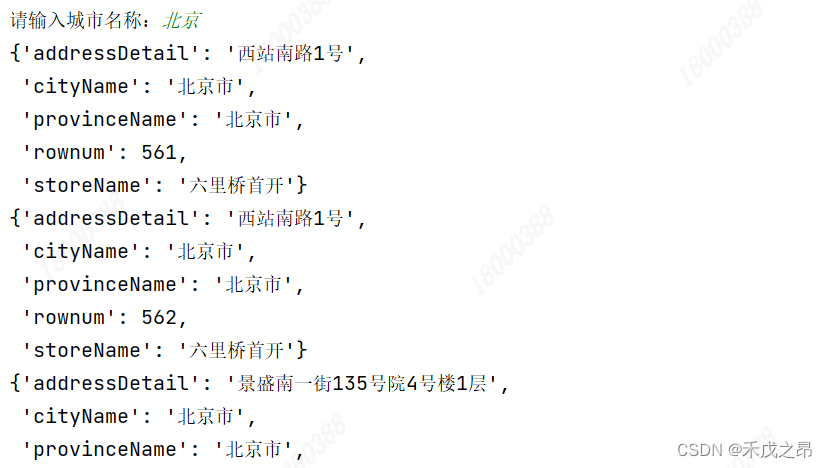

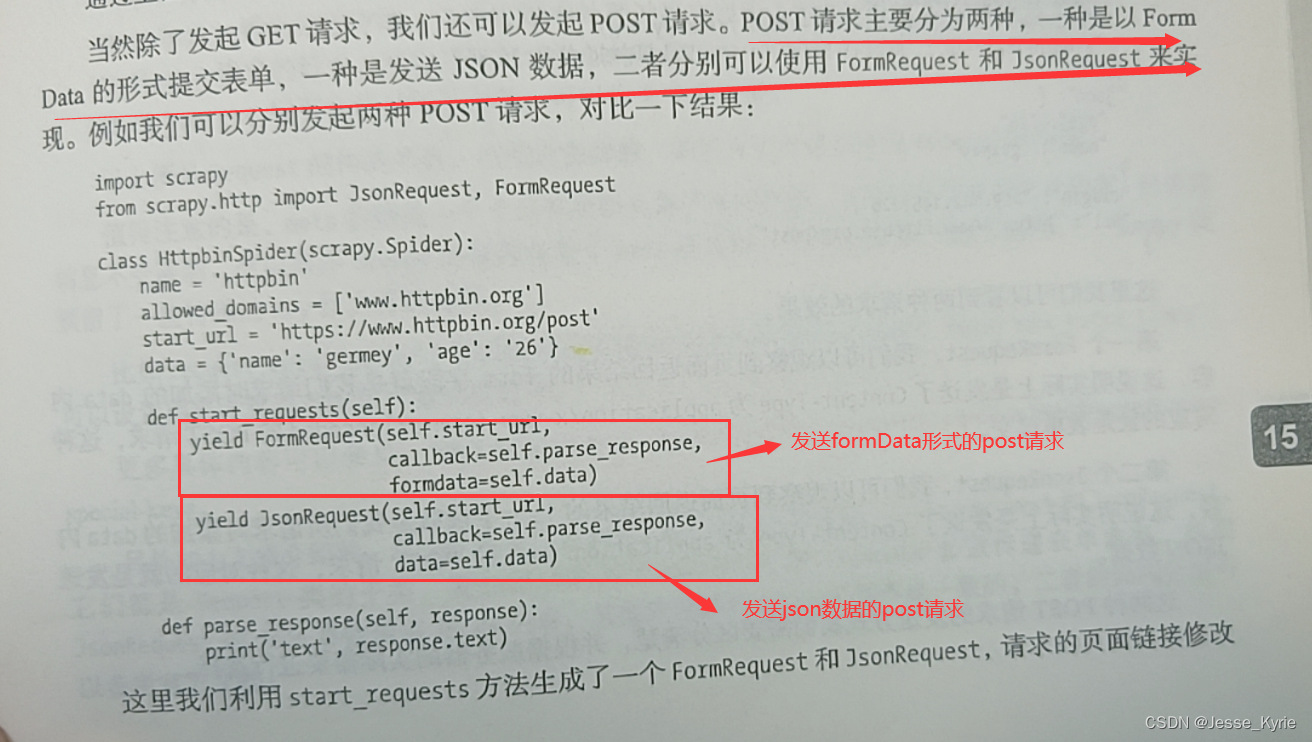

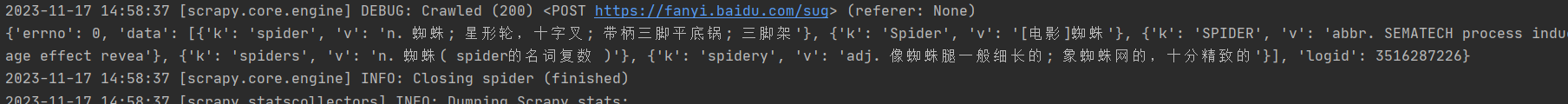

【Python_Scrapy学习笔记(十二)】基于Scrapy框架实现POST请求爬虫

基于Scrapy框架实现POST请求爬虫

前言

本文中介绍 如何基于 Scrapy 框架实现 POST 请求爬虫,并以抓取指定城市的 KFC 门店信息为例进行展示

正文

1、Scrapy框架处理POST请求方法

Scrapy框架 提供了 FormRequest() 方法来发送 POST 请求; FormReques…

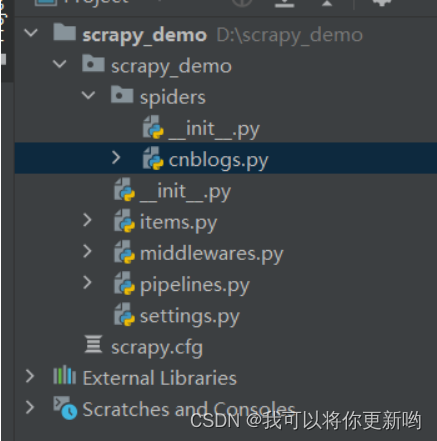

python爬虫之scrapy之入门实例

scrapy之入门实例

首先我们需要参加一个scrapy工程 打开cmd输入

scrapy startproject 工程名可以看到生成一个文件夹里面有以下图中文件 各个文件介绍 其次在工程中产生一个爬虫

scrapy genspider demo python123.io

//生产名为demo的爬虫然后会生产一个demo.py文件 de…

scrapy爬虫框架使用介绍建议收藏

定义: 异步处理框架,可配置和可扩展程度非常高,Python 中使用最广泛的爬虫框架 重点来说一下scrapy的五大组件:

Scrapy框架五大组件 【1】引擎(Engine)----------整个框架核心 【2】爬虫程序(Spider)-----…

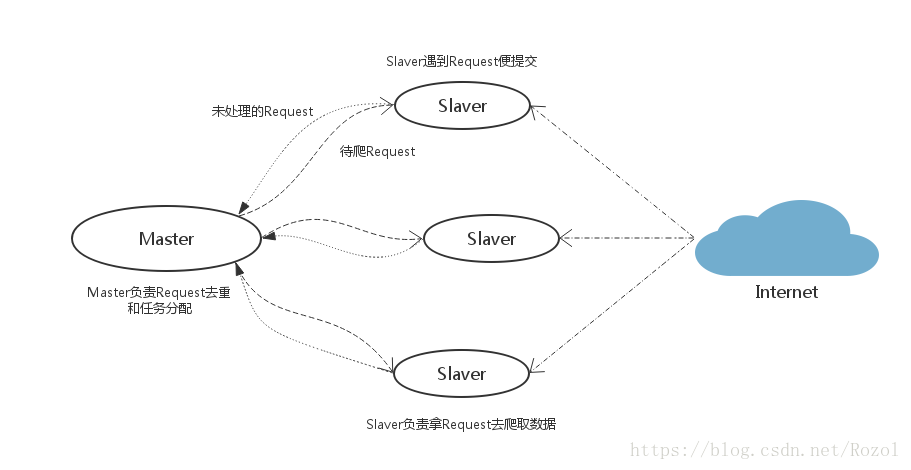

Python3 Scrapy爬虫框架(Scrapy/scrapy-redis)

Python3 Scrapy爬虫框架(Scrapy/scrapy-redis) 本文由 Luzhuo 编写,转发请保留该信息. 原文: https://blog.csdn.net/Rozol/article/details/80010173 Scrapy Scrapy 是 Python 写的, 主要用于爬取网站数据, 爬过的链接会自动过滤 使用的 Twisted 异步网络框架 官网: https…

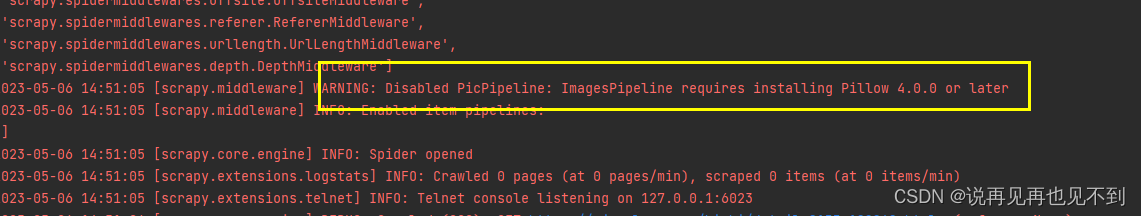

Disabled PicPipeline: ImagesPipeline requires installing Pillow 4.0.0 or later

目录

一、scrapy是什么

二、问题以及原因

三、解决办法

1、确保系统已经安装了 Pillow 库。

2、安装 Pillow 库。

3、在项目根目录中添加 Pillow 的 .pth 文件。 一、scrapy是什么 Scrapy是一个用于从网站和Web应用中抓取数据的强大的Python库。Scrapy支持异步I/O和

Scr…

scrapy爬虫框架基本介绍

一、介绍

Scrapy 是一种快速的高级 web crawling 和 web scraping 框架,用于对网站进行爬网并从其页面提取结构化数据。它可以用于广泛的用途,从数据挖掘到监控和自动化测试。

二、架构 三、组件

Scrapy Engine

引擎负责控制数据流在系统中所有组件中…

Python爬虫框架Scrapy,更高效地抓取数据

Python爬虫框架Scrapy,更高效地抓取数据 一、Scrapy简介1 Scrapy的定义2 Scrapy的特点3 Scrapy的优点 二、Scrapy的模块结构与工作流程1 Scrapy的模块结构2 Scrapy的工作流程3 Scrapy的数据流 三、Scrapy的主要组件1 Scrapy Engine2 Scheduler组件3 Downloader组件4…

Python爬虫Scrapy框架代码

下面是一个简单的Python爬虫Scrapy框架代码示例,该代码可以抓取百度搜索结果页面中指定关键字的链接和标题等信息:

import scrapyclass BaiduSpider(scrapy.Spider):name baiduallowed_domains [www.baidu.com]start_urls [http://www.baidu.com/s?…

Python Scrapy爬虫框架使用示例浅析

Scrapy爬虫框架可以实现多线程爬取目标内容,简化代码逻辑,提高开发效率,这篇文章主要介绍了Python Scrapy爬虫框架的使用示例,感兴趣想要详细了解可以参考下文 示例

下面是一个简单的Python爬虫Scrapy框架代码示例,该…

Scrapy 基本使用

一、Scrapy框架使用

1. 创建scrapy项目(不能有汉字,不能数字开头) scrapy startproject Baidu 2. 创建爬虫文件 1. cd Baidu 2. scrapy genspider wenda www.baidu.com 注意: parse()是执行了start_url之后要执行的方法&#…

蓝牙耳机运动耳机哪个好、好用的运动蓝牙耳机推荐

如今的蓝牙耳机已经成为手机的最佳伴侣,也是运动爱好者的必备装备。然而,在众多蓝牙耳机中做出选择可能会让人感到困惑。其实,在选购运动蓝牙耳机时需要注意的事项还挺多的,比如舒适度、稳定性和音质等多个方面,逐一对照这些要点来…

简单上手Scrapy框架

创建一个Scrapy框架的爬虫程序

安装Scrapy库,直接通过pycharm搜索Scrapy进行安装即可

在终端执行 scrapy startproject 项目名 scrapy startproject Learn 示例 即可创建名为Learn的Scrapy程序,成功创建项目后,会已项目名称创建一个文件夹&…

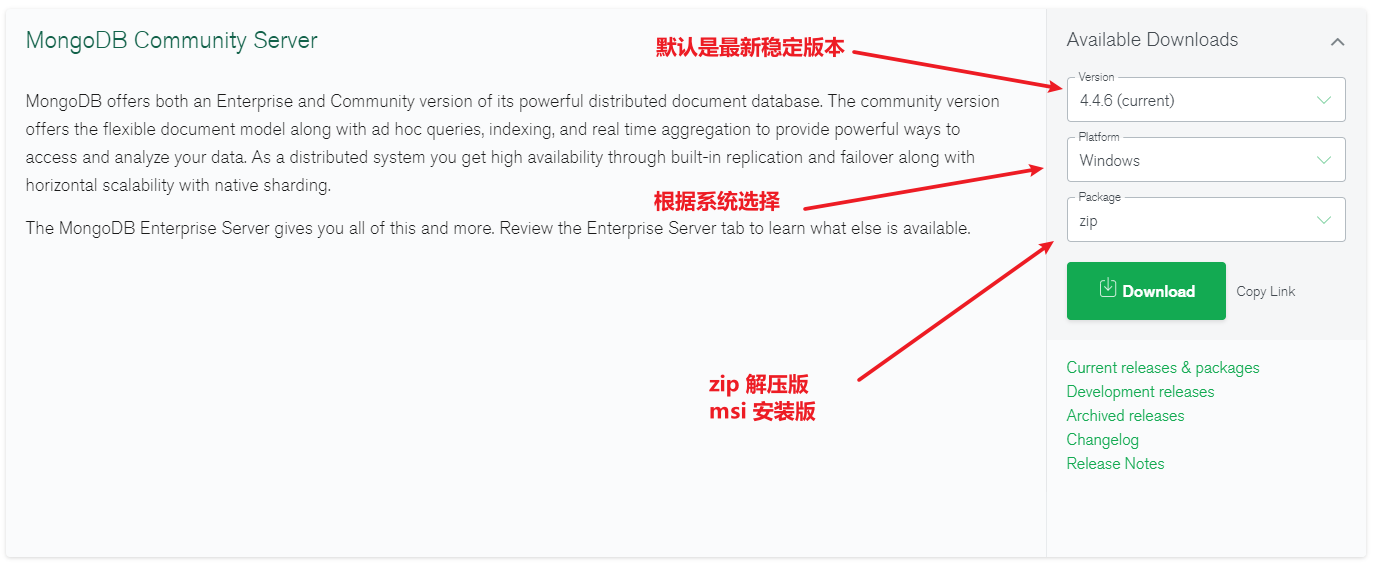

Scrapy框架之Mongo安装和与关系型数据库比较

目录

Windows安装与启动MongoDB

下载

启动MongoDB

通过命令启动

脚本

快速学习方法 与关系型数据库比较

什么是BSON Windows安装与启动MongoDB 下载

企业版-收费

社区版-免费

下载Mongodb Download MongoDB Community Server | MongoDB 选择版本 稳定版5.0.9 选择平台…

Python爬虫入门系列之Scrapy框架构建爬虫

Python爬虫入门系列之Scrapy框架构建爬虫 在前两篇博客中,我们学习了如何使用多线程和Selenium来改进爬虫程序。现在,让我们介绍一种更高级的爬虫框架——Scrapy,它为我们提供了更方便、高效的方式来构建爬虫。 Scrapy简介

Scrapy是一个基于…

【爬虫】scrapy+selenium自动滚动页面爬取百度百科术语分类

看之前的贴就知道我最近对股票有点兴趣,可是我对股票一窍不通怎么办呢。发现了一个网站 https://baike.baidu.com/wikitag/taglist?tagId62991 长这样: 感觉很不错,一下子基本上涵盖了大多数的相关概念,往下翻了几下,…

【爬虫】scrapy爬取股票历史数据并保存成CSV文档

这个爬虫是接着上个爬虫做的,先送上传送门:https://blog.csdn.net/yao09605/article/details/94596341 我们的目标网址是

http://quotes.money.163.com/trade/lsjysj_股票代码.html股票代码的来源就是上个爬虫存到mongodb里面的股票列表 先在terminal中…

【爬虫】scrapy下载股票列表(四)——对接mongodb保存数据

本文是本项目最后一篇,撒花! 前三篇传送门: 【爬虫】scrapy下载股票列表(一)——对接selenium中间件: https://blog.csdn.net/yao09605/article/details/94147708 【爬虫】scrapy下载股票列表(二…

scrapy基础学习-使用数据库存储MySQL

scrapy抓取的数据存储到数据库

首先修改一下pipeline路径 pipeline文件,主要是对抓取回来的数据进行处理。 在这里,我们可以对数据进行,清洗,转化,存储。 为了方便管理,我习惯将不同功能的代码,…

【爬虫计划】Scrapy框架的学习及跟课学习 | csdn_Part 04 Spider的使用

昨日开了三篇,一篇爬虫,一篇复习计划,一篇数据分析笔记,三篇都没完成,这篇也是拖到今天,不是因为昨天一天没干活,而是在本地听了scrapy传zhi播客的导入视频,讲解的较为细致ÿ…

scrapy基础学习-商品信息抓取

熟悉scrapy基本操作

开始你的项目 scrapy startproject xxx然后他是这个样子的xxx 项目目录-- xxx 项目模块-- scrapy.cfg 项目部署配置文件-- __init__.py-- items.py item定义,用来定义爬虫结构…

【爬虫计划】Scrapy框架的学习及跟课学习 | csdn_Part 02 上手Scrapy框架

根据计划,今天接着跟scrapy课程,上篇博文【爬虫计划】Scrapy框架的学习及跟课学习 | csdn_Part 01 认识Scrapy框架学到创建新项目及对于两种命令(全局命令和项目命令)的查看及使用,这部分内容跟着练习一个小的“我爱我…

Python安装第三方包时报错:Microsoft Visual C++ 14.0 is required

在使用Python时跑代码的时候,有条件的尽量不要在Windows中运行,这个系统总是会在不经意间制造一点惊喜,真是令人头大

今天使用pip安装 pyahocorasick 的时候,报错Microsoft Visual C 14.0 is required,上网搜索说手动…

Python爬虫进阶之Scrapy

用Scrapy爬取百度图片 前段时间用python的requests库和BeautifulSoup库爬取了猫眼电影关于柯南剧场版的6000条评论 这次我们来使用Scrapy框架来实现爬虫任务——百度“唯美图片”的爬取 整个项目的工程源码我已经上传到GitHub上了,感兴趣的同学可以自行下载…

scrapy 用爬虫规则指定爬行轨迹自动抓取

需求

给定爬虫起始地址,爬行路径,获得目标页的指定内容约定路径 起点首页 --> (历史)频道 --> 小说info页–> 章节详情起始页 --> 作者中心 --> 大神之光路径中的每个页面html结构都不同

分析

通用爬虫,写规则,…

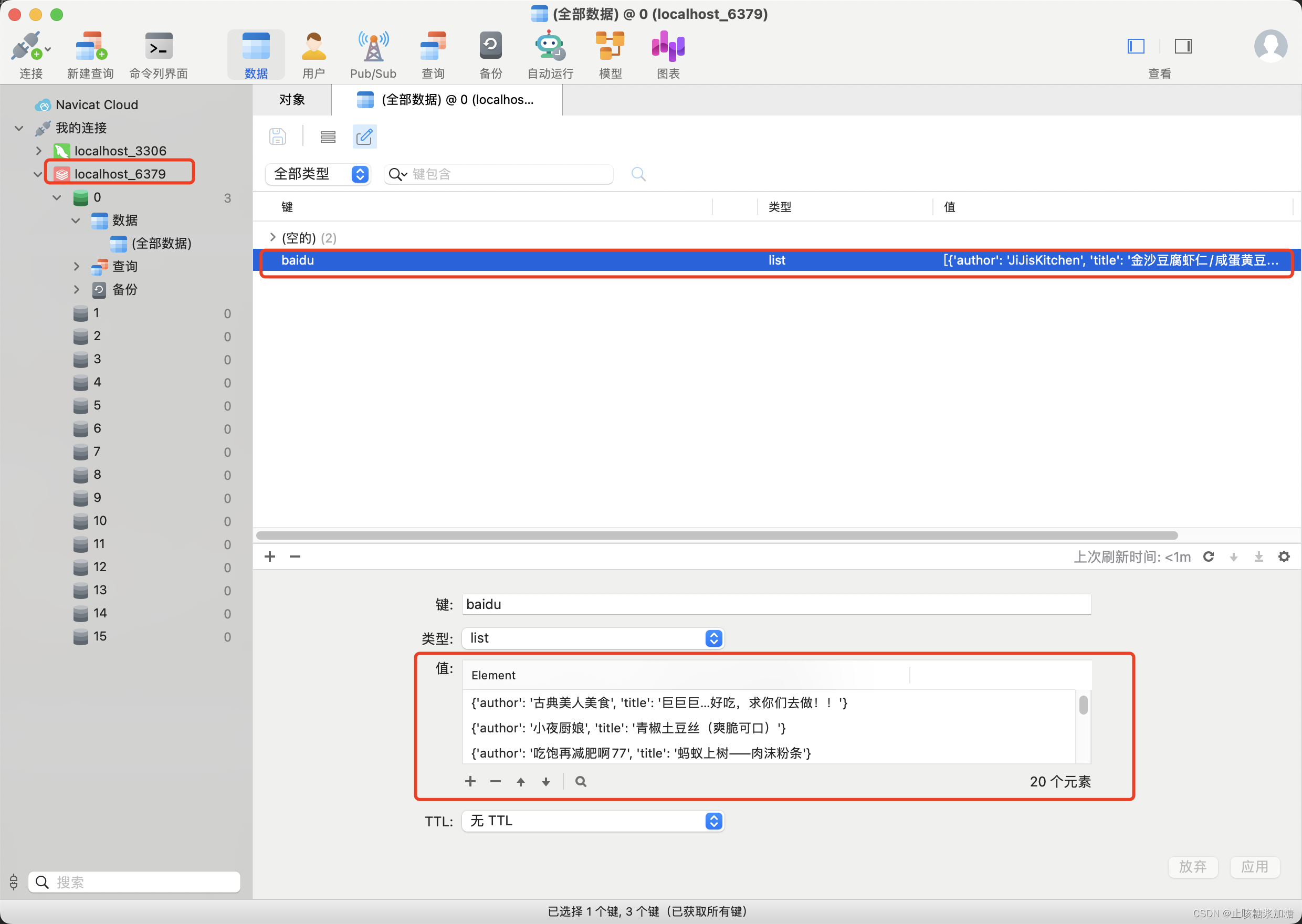

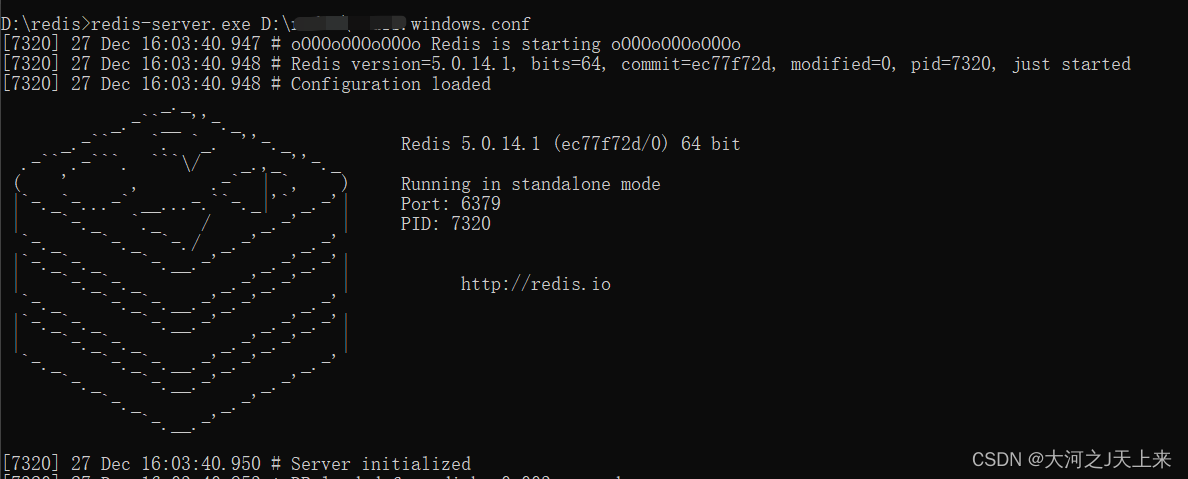

scrapy-redis分布式爬虫学习记录

目录

1. scrapy-redis是什么?

2. scrapy-redis工作原理

3.分布式架构

4. scrapy-redis的源码分析

5. 部署scrapy-redis

6. scrapy-redis的基本使用

6.1 redis数据库基本表项

6.2 在scrapy项目的基础进行更改

7. redis数据转存入mysql数据库 课程推荐&#…

Scrapy爬虫框架入门

Scrapy是Python开发的一个非常流行的网络爬虫框架,可以用来抓取Web站点并从页面中提取结构化的数据,被广泛的用于数据挖掘、数据监测和自动化测试等领域。下图展示了Scrapy的基本架构,其中包含了主要组件和系统的数据处理流程(图中…

scrapy runspider 导出json文件时乱码

scrapy runspider 导出乱码 初步判断 ,输入输出编码不一致 ,查阅官方与导出相关的配置说明如下 FEED_EXPORT_ENCODING Default: None The encoding to be used for the feed If unset or set to None (default) it uses UTF-8 for everything except JSO…

Scrapy爬虫项目的管理部署

前言

为了方便对爬虫项目的流程化管理,需要一款合适的工具。主要实现的功能有: 能对爬虫项目的管理做到“统一”、“稳定”、“方便”; 能够查看爬虫项目的运行情况,包括查看日志,控制台信息,告错预警信息…

爬虫框架Scrapy学习笔记-2

前言

Scrapy是一个功能强大的Python爬虫框架,它被广泛用于抓取和处理互联网上的数据。本文将介绍Scrapy框架的架构概览、工作流程、安装步骤以及一个示例爬虫的详细说明,旨在帮助初学者了解如何使用Scrapy来构建和运行自己的网络爬虫。

Scrapy架构概览…

Python爬虫深度优化:Scrapy库的高级使用和调优

在我们前面的文章中,我们探索了如何使用Scrapy库创建一个基础的爬虫,了解了如何使用选择器和Item提取数据,以及如何使用Pipelines处理数据。在本篇高级教程中,我们将深入探讨如何优化和调整Scrapy爬虫的性能,以及如何处…

scrapy框架--

Scrapy是一个用于爬取数据的Python框架。下面是Scrapy框架的基本操作步骤: 安装Scrapy:首先,确保你已经安装好了Python和pip。然后,在命令行中运行以下命令安装Scrapy:pip install scrapy 创建Scrapy项目:使用Scrapy提供的命令行工具创建一个新的Scrapy项目。在命令行中切…

Scrapy-连接数据库

通过前面几篇文章的学习,我们已经能够使用Scrapy框架写出一些常见的网络爬虫。在本章中,我们将使用Scrapy框架,将爬取到的数据存储到数据库中。

与将数据写入文件一样,写入到数据库中也是通过pipelines.py文件完成的

存储到MySQ…

scrapy反爬机制 与 Selenium搭配

反爬虫机制

需求背景 网站内容使用js动态加载,一般的爬虫无法抓取 分析目标站点 使用 shell 调试工具动态加载比如请求api得到新数据 向动态请求图片api发起请求json.loads(response.text) 函数来加载处理响应的api数据对象 小计 Spider 到底应该使用 XPath 或 CS…

Scrapy-爬虫模板的使用

Scrapy,Python开发的一个快速、高层次的屏幕抓取和web抓取框架,用于抓取web站点并从页面中提取结构化的数据。Scrapy用途广泛,可以用于数据挖掘、监测和自动化测试。

Scrapy吸引人的地方在于它是一个框架,任何人都可以根据需求方…

scrapy简记之抓取小说示例

scrapy 网络爬虫核心工作 通过网络向指定的 URL 发送请求,获取服务器响应内容使用某种技术(如正则表达式、XPath 等)提取页面中我们感兴趣的信息高效地识别响应页面中的链接信息,分析这些链接递归执行此处介绍的第 1、2、3 步使用…

Python爬虫爬取豆瓣电影短评(爬虫入门,Scrapy框架,Xpath解析网站,jieba分词)

声明:以下内容仅供学习参考,禁止用于任何商业用途

很久之前就想学爬虫了,但是一直没机会,这次终于有机会了

主要参考了《疯狂python讲义》的最后一章

首先安装Scrapy:

pip install scrapy

然后创建爬虫项目&#…

使用Python和Pandas处理网页表格数据

在我们的日常工作和生活中,经常会遇到需要处理大量数据的情况,而网页表格数据则是其中常见的一种形式。如果我们能够灵活地使用Python和Pandas这两个强大的工具,就能够快速、高效地对这些数据进行处理和分析。

首先,我们需要了解…

scrapy-redis分布式爬虫

分布式爬虫

目录

分布式爬虫

相关的参考资料

依赖环境

相关介绍

分布式问题

项目中(settings和爬虫文件.py)代码的配置

MySQL和redis的配置

开始分布式爬虫

重启分布式爬虫 相关的参考资料

scrapy-redis库GitHub地址:github地址点…

Python爬虫框架Scrapy简介

Scrapy 简介

Scrapy 是一个用于数据抓取的 Python 框架。它可以轻松地从互联网上的网站中提取所需的数据。Scrapy 框架具有高效且可扩展的架构,可以处理大量数据并提高数据爬取的效率。

Scrapy 由 Python 编写,是一个开源项目,它为数据抓取…

【Python_Scrapy学习笔记(二)】创建Scrapy爬虫项目

创建Scrapy爬虫项目

前言

本文主要介绍如何创建并运行 Scrapy 爬虫项目。

正文

1、创建 Scrapy 框架 Scrapy 框架提供了 scrapy 命令用来建立 Scrapy 工程,在终端 terminal 中输入以下命令: scrapy startproject 自定义的项目名称创建好爬虫项目文件…

scrapy简单入门 - 爬取伯乐在线所有文章

推荐我的个人博客 http://blog.wuzhenyu.com.cn scrapy 是一个用 python 语言编写的,为了爬取网站数据,提取结构性数据而编写的应用框架。

环境

本文使用的环境: python 3.5.2 pip 9.0.1 操作系统: Ubuntu 16.04

pythton 环境…

scrapy的反反爬

爬虫的反反爬策略

反反爬的总体思想○ 将爬虫伪装成自然人的浏览行为

自然人浏览的特点○ 访问频率不会太过于高○ 使用浏览器进行访问○ 网站设置登录要求后仍然能够正常访问○ 可以完成验证操作

scrapy的反反爬功能的实现○ 爬虫配置文件setting.py○ 爬虫框架的中间件使…

scrapy基础知识之 Logging

scrapy基础知识之 Logging:参考:http://scrapy-chs.readthedocs.io/zh_CN/0.24/topics/logging.html点击打开链接修改配置文件settings.py,任意位置添加LOG_FILE "XxSpider.log"

LOG_LEVEL "INFO"Log levelsScrapy提供…

Scrapy学习篇(四)- 笔记整理

笔记~要点

1.爬取下一个链接,提取url,调用scrapy.Request()。scrapy.Request能创建一个requests,同时指定提取数据的callback函数,以及利用meta传递数据

next_page_url response.xpath("//a[text()"下一页"]/hr…

解读scrapy各个组件中的from_crawler()方法

Scrapy 中很多组件都有 from_crawler()方法,下面是我读源码后对 from_crawler()方法的理解,记录下来。

from_crawler() 方法一般用传入的参数来实例化一个对象,比如 scrapy.spider 中的 from_crawler():

classmethod

def from_c…

Scrapy实战-爬取某博客聚合网站信息

前言

前段时间看了一些介绍Scrapy及用Scarpy进行抓取网络信息的博客。总体来说信息量还是过少,对于一个成熟的框架来说,只看博客还是不够。所以还是看了一遍官方文档。

看完后,总要做点什么来练练手,正好前段时间在网上闲逛的时…

Scrapy 从 settings 中获得配置属性的方法

1. get(name, defaultNone)

2. getbool(name, defaultFalse) 1, 1, True 和 True 返回 True, 当0, 0, False, False 和 None 时,返回 False

3. getint(name, default0)

a settings.getint(CONCURRENT_REQUESTS) # 获取配置的值

b settings.getin…

Scrapy.http.Request 与 requests.request 区别

Scrapy.http.Request 是处于 Scrapy 框架内的一个类对象,需要在 Scrapy 框架内使用。

requests.request 是独立的 requests 库的 api。

如果想要下载一个链接,获得 html 内容,用 requests.request 方法比较方便,返回一个 reques…

Python爬虫框架Scrapy的安装与正确使用方法

概括:上一节学习了pyspider框架,这一节我们来看一下Scrapy的强大之处。他应该是目前python使用的最广泛的爬虫框架。 特别注意:很多人学Python过程中会遇到各种烦恼问题,没有人解答容易放弃。为此小编建了个Python全栈免费答疑.裙…

Scrapy+Selenium关键字豆瓣读书评论爬取

文章目录思路1. 根据关键字构造豆瓣搜索url, 根据结果获取书的id2. 根据id, 构造该书评论的url链接3. 爬取网页内容, 并构造下一页url4. 重复步骤3, 反复爬取过程1. 页面爬取测试2. 使用selenium工具获取id3. 将selenium集成到scrapy中4. 爬取结果5. 阶段性spider代码ip异常问题…

python-scapy框架(二)items文件夹的用法讲解

在Scrapy框架中,items文件夹是用来存放定义数据模型的Item类的地方。Item类描述了要从网页中提取的数据的结构和字段。通过使用Item类,我们可以更方便地组织和处理爬取到的数据。下面将详细介绍如何创建Item类,并在Scrapy框架中使用items文件…

爬虫:Scrapy热门爬虫框架介绍

专栏介绍

结合自身经验和内部资料总结的Python教程,每天3-5章,最短1个月就能全方位的完成Python的学习并进行实战开发,学完了定能成为大佬!加油吧!卷起来!

全部文章请访问专栏:《Python全栈教…

Scrapy框架之Docker 安装 MongoDB

目录

Docker安装 MongoDB

Docker

安装 MongoDB

第一次 MongoDB基础命令

算机存储数据的概念

查看数据库

切换数据库/创建数据库

删除当前数据库

创建集合

查看集合

删除集合 数据的增加

样例

数据的更新

举例 Docker安装 MongoDB

Docker

Docker 是一个开源的应…

Python爬虫——scrapy_基本使用

安装scrapy

pip install scrapy创建scrapy项目,需要在终端里创建 注意:项目的名字开头不能是数字,也不能包含中文

scrapy startproject 项目名称

示例:

scrapy startproject scra_baidu_36创建好后的文件 3. 创建爬虫文件&…

Python爬虫——scrapy_工作原理

引擎向spiders要url引擎把将要爬取的url给调度器调度器会将url生成的请求对象放入到指定的队列中从队列中出队一个请求引擎将请求交给下载器进行处理下载器发送请求获取互联网数据下载器将数据返回给引擎引擎将数据再次给到spidersspiders通过xpath解析该数据,得到数…

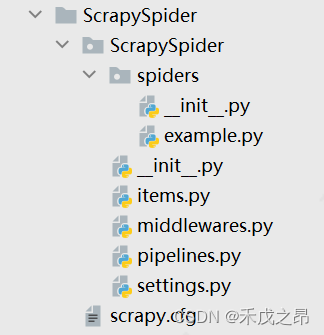

Python爬虫——scrapy_项目结构和基本方法

scrapy项目结构 项目名字项目名字spider文件夹(存储的是爬虫文件)init自定义的爬虫文件 *核心功能文件inititems 定义数据结构的地方 爬取的数据都包含哪些middlewares 中间件 代理机制pipelines 管道 用来处理下载的数据settin…

Scrapy框架之MongoDB通过配置文件管理参数--Linux安装MongoDB--图形管理工具

目录

MongoDB通过配置文件

问题

解决方案 步骤

提示

Linux安装MongoDB

环境

下载依赖与安装包

解压安装

MongoDB GUI管理工具

独立软件GUI软件

Robo 3T使用

VSCode集成GUI插件 MongoDB通过配置文件 问题 启动MongoDB时,编写参数太麻烦 解决方案 通过配…

Python爬虫:Scrapy框架

🚀Python爬虫:Scrapy框架 🕷️ Scrapy介绍📦 Scrapy框架📁 Scrapy项目🔍 创建爬虫过程🕸️ 页面分析📑 提取信息🎉 完整代码📝 结语 在本篇博文中,…

Python爬虫——scrapy_多条管道下载

定义管道类(在pipelines.py里定义)

import urllib.requestclass DangDangDownloadPipelines:def process_item(self, item, spider):url http: item.get(src)filename ../books_img/ item.get(name) .jpgurllib.request.urlretrieve(url, filename…

使用python scrapy时候出现的问题

本来scrapy用得好好的.突然出现了 “Pycharm中出现ImportError:DLL load failed:找不到指定模块的解决方法”的问题。

本着解决问题的精神搞了好几个小时,终于解决了。记录一下:

首先搜“Pycharm中出现ImportError:DLL load failed:找不到指定模块的解…

Python爬虫的scrapy的学习(学习于b站尚硅谷)

目录 一、scrapy 1. scrapy的安装 (1)什么是scrapy (2)scrapy的安装 2. scrapy的基本使用 (1)scrap的使用步骤 (2)代码的演示 3. scrapy之58同城项目结构和基本方法&…

Python爬虫——scrapy_crawlspider读书网

创建crawlspider爬虫文件:

scrapy genspider -t crawl 爬虫文件名 爬取的域名scrapy genspider -t crawl read https://www.dushu.com/book/1206.htmlLinkExtractor 链接提取器通过它,Spider可以知道从爬取的页面中提取出哪些链接,提取出的链…

记录scrapy框架的安装

在windows系统上。scrapy框架的安装有两种方式,一种是使用anaconda安装,一种是分步安装,安装好scrapy的依赖库后再安装scrapy。

Anaconda安装

下载好Anaconda后,使用conda命令安装scrapy:

conda install scrapy分步…

【python爬虫】14.Scrapy框架讲解

文章目录 前言Scrapy是什么Scrapy的结构Scrapy的工作原理 Scrapy的用法明确目标与分析过程代码实现——创建项目代码实现——编辑爬虫代码实现——定义数据代码实操——设置代码实操——运行 复习 前言

前两关,我们学习了能提升爬虫速度的进阶知识——协程…

【python爬虫】16.爬虫知识点总结复习

文章目录 前言爬虫总复习工具解析与提取(一)解析与提取(二)更厉害的请求存储更多的爬虫更强大的爬虫——框架给爬虫加上翅膀 爬虫进阶路线指引解析与提取 存储数据分析与可视化更多的爬虫更强大的爬虫——框架项目训练 反爬虫应对…

AttributeError: module ‘OpenSSL.SSL’ has no attribute ‘SSLv3_METHOD

这个错误是由于在OpenSSL.SSL模块中找不到SSLv3_METHOD属性导致的。解决这个问题的方法如下: 首先,确保你已经安装了最新版本的cryptography和pyOpenSSL。你可以使用以下命令卸载并重新安装它们: 卸载cryptography:pip uninstall …

Scrapy的基本介绍、安装及工作流程

一.Scrapy介绍

Scrapy是什么?

Scrapy 是用 Python 实现的一个为了爬取网站数据、提取结构性数据而编写的应用框架(异步爬虫框架) 通常我们可以很简单的通过 Scrapy 框架实现一个爬虫,抓取指定网站的内容或图片。 Scrapy使用了Twisted异步网络框架&…

第二章:25+ Python 数据操作教程(第十八节如何使用 Matplotlib 库在 python 中执行绘图和数据可视化)持续更新中

本教程概述了如何使用 Matplotlib 库在 python 中执行绘图和数据可视化。这篇文章的目的是让您熟悉该库的基础知识和高级绘图功能。它包含几个示例,将为您提供使用 Python 生成绘图的实践经验。

目录 什么是 Matplotlib? Matplotlib 基础知识<

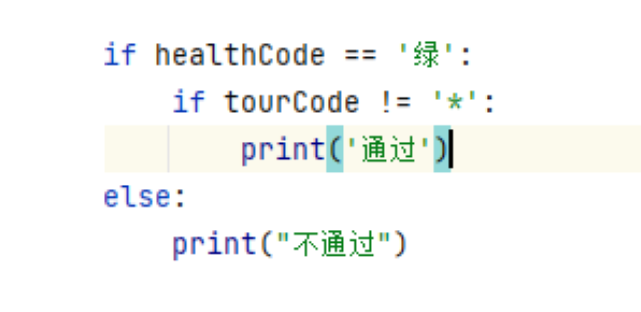

Python学习之路02 之分支结构

😀前言 在我们的日常生活中,我们常常会根据不同的条件来做出不同的决定。类似的,程序设计也需要这样的结构来根据不同的条件执行不同的代码块。Python 提供了一系列的工具和结构来实现这一点,从而允许程序具有更丰富的功能和灵活性…

爬虫 — Scrapy 框架(一)

目录 一、介绍1、同步与异步2、阻塞与非阻塞 二、工作流程三、项目结构1、安装2、项目文件夹2.1、方式一2.2、方式二 3、创建项目4、项目文件组成4.1、piders/__ init __.py4.2、spiders/demo.py4.3、__ init __.py4.4、items.py4.5、middlewares.py4.6、pipelines.py4.7、sett…

Scrapy+Selenium自动化获取个人CSDN文章质量分

前言

本文将介绍如何使用Scrapy和Selenium这两个强大的Python工具来自动获取个人CSDN文章的质量分数。我们将详细讨论Scrapy爬虫框架的使用,以及如何结合Selenium浏览器自动化工具来实现这一目标。无需手动浏览每篇文章,我们可以轻松地获取并记录文章的…

新闻报道的未来:自动化新闻生成与爬虫技术

概述

自动化新闻生成是一种利用自然语言处理和机器学习技术,从结构化数据中提取信息并生成新闻文章的方法。它可以实现大规模、高效、多样的新闻内容生产。然而,要实现自动化新闻生成,首先需要获取可靠的数据源。这就需要使用爬虫技术&#…

8章:scrapy框架

文章目录 scrapy框架如何学习框架?什么是scarpy?scrapy的使用步骤1.先转到想创建工程的目录下:cd ...2.创建一个工程3.创建之后要转到工程目录下4.在spiders子目录中创建一个爬虫文件5.执行工程setting文件中的参数 scrapy数据解析scrapy持久…

Python的scrapy框架爬虫项目中加入邮箱通知(爬虫启动关闭等信息以邮件的方式发送到邮箱)

前面关于发送邮件的博客参考:普通邮件博客——点击打开链接 带附件的邮件——

点击打开链接准备:

1、创建scrapy爬虫项目

2、代码主要是两部分:呈上代码

第一部分是发送邮件的代码ÿ…

scrapy介绍,并创建第一个项目

一、scrapy简介

scrapy的概念 Scrapy是一个Python编写的开源网络爬虫框架。它是一个被设计用于爬取网络数据、提取结构性数据的框架。

Scrapy 使用了Twisted异步网络框架,可以加快我们的下载速度。 Scrapy文档地址:http://scrapy-chs.readthedocs.io/z…

Anemone库的爬虫程序代码示例

以下是代码:

ruby require anemone

# 设置代理服务器 Anemone.proxies { http > "", https > "" }

# 定义爬取的URL url

# 使用Anemone进行爬取 Anemone.crawl(url) do |page| # 使用正则表达式找出所有的视频链接 video_…

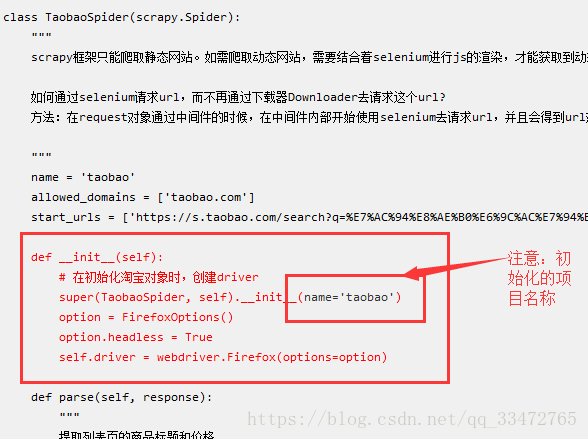

Python爬虫scrapy框架爬取动态网站——scrapy与selenium结合爬取数据

scrapy框架只能爬取静态网站。如需爬取动态网站,需要结合着selenium进行js的渲染,才能获取到动态加载的数据。如何通过selenium请求url,而不再通过下载器Downloader去请求这个url?

方法:在request对象通过中间件的时候࿰…

scrapy基础知识之发送POST请求与使用 FormRequest.from_response() 方法模拟登陆

Scrapy模拟表单和Ajax发送POST请求

scrapy.FormRequest

普通请求使用scrapy.Request类就可以实现,但是遇到模拟表单或Ajax提交post请求的时候,Request类就不如 子类 FormRequest类方便了,因为他自带 formdata ,专门用来设置表单字…

Python-Scrapy框架(框架学习)

一、概述 Scrapy是一个用于爬取网站数据的Python框架,可以用来抓取web站点并从页面中提取结构化的数据。

基本组件: 引擎(Engine):负责控制整个爬虫的流程,包括调度请求、处理请求和响应等。 调度器(Scheduler):负责…

Mac安装Scrapy及踩坑经验

前言

系统 - macOS 10.13.6 Python - 2.7 和 3.6 共存

Mac出厂自带python2.7版本,后面我又自己安装了Python3.X,于是电脑里就有两个版本共存的情况,今天打算装个Scrapy玩玩,不了解Scrapy的童鞋可以看官方文档:Scrapy…

爬取微博热榜并将其存储为csv文件

🙌秋名山码民的主页 😂oi退役选手,Java、大数据、单片机、IoT均有所涉猎,热爱技术,技术无罪 🎉欢迎关注🔎点赞👍收藏⭐️留言📝 获取源码,添加WX 目录 前言1.…

Scrapy Splash--appinum-->介绍-环境配置

这两个模块分别是渲染网页,手机端爬虫工具的基本信息介绍,环境配置。 Scrapy Splash

Scrapy Splash是一个基于Scrapy框架的扩展,用于处理JavaScript渲染的网页。它利用Splash服务,通过发送请求和接收响应的方式来执行JavaScript代码,并将渲染后的网页源代码返回给Scrapy,…

打造高效的分布式爬虫系统:利用Scrapy框架实现

在大数据时代的今天,爬虫系统成为了获取和分析海量数据的重要工具。本文将介绍如何使用Scrapy框架来构建一个高效的分布式爬虫系统,以加速数据采集过程和提高系统的可扩展性。

Scrapy框架简介 Scrapy是一个基于Python的强大的开源网络爬虫框架ÿ…

高级深入--day35

反反爬虫相关机制

Some websites implement certain measures to prevent bots from crawling them, with varying degrees of sophistication. Getting around those measures can be difficult and tricky, and may sometimes require special infrastructure. Please consi…

第七章:最新版零基础学习 PYTHON 教程—Python 列表(第二节 -Python 创建具有给定范围的数字列表)

目录

使用循环的朴素方法

使用列表理解

使用 Python range()

使用迭代工具:

使用 numpy.arange()

25+ Python 数据操作教程(第十一节PYTHON 中的字符串函数及示例)

常用字符串函数列表 下表显示了许多常见的字符串函数及其说明及其在 MS Excel 中的等效函数。我们在工作场所都使用MS Excel,并且熟悉MS Excel中使用的功能。MS EXCEL和Python中字符串函数的比较可以帮助你快速学习函数并在面试前做好准备。 功能描述MS Excel 函数字符串[:N]从…

Scrapy设置代理IP方法(超详细)

Scrapy是一个灵活且功能强大的网络爬虫框架,用于快速、高效地提取数据和爬取网页。在某些情况下,我们可能需要使用代理IP来应对网站的反爬机制、突破地理限制或保护爬虫的隐私。下面将介绍在Scrapy中设置代理IP的方法,以帮助您更好地应对这些…

第九章:最新版零基础学习 PYTHON 教程—Python 元组(第四节 -Python连接元组的方法)

很多时候,在处理记录时,我们可能会遇到需要添加两条记录并将它们存储在一起的问题。这需要串联。由于元组是不可变的,因此这个任务变得不太复杂。让我们讨论执行此任务的某些方法。

目录

scrapy typeerror: attrs() got an unexpected keyword argument ‘eq‘

问题: scrapy 爬虫程序报错

scrapy typeerror: attrs() got an unexpected keyword argument eq原因: Twisted 版本过高

解决方法:

# 安装指定版本

pip install --index https://pypi.mirrors.ustc.edu.cn/simple/ Twisted21.7.0# 几个可…

轻松调整视频时长,全能视频批量剪辑工具让剪辑更高效!

您是否曾对视频的片头片尾时长感到困扰,希望能够快速调整?现在我们为您推出了全新的视频批量剪辑工具,让您的剪辑工作更加高效!

第一步,首先进入媒体梦工厂主页面,在板块栏里选择“任务剪辑”板块。 第二步…

[Python] OSError: [E050] Can‘t find model ‘en_core_web_sm‘.

OSError: [E050] Can’t find model ‘en_core_web_sm’. It doesn’t seem to be a Python package or a valid path to a data directory.

下载模型

python -m spacy download en_core_web_sm加载模型

import spacy# 加载英语模型

nlp spacy.load("en_core_web_sm&q…

Python爬虫——scrapy_当当网图书管道封装

创建爬虫项目

srcapy startproject scrapy_dangdang进入到spider文件里创建爬虫文件(这里爬取的是青春文学,仙侠玄幻分类)

srcapy genspider dang http://category.dangdang.com/cp01.01.07.00.00.00.html获取图片、名字和价格

# 所有的se…

爬虫scrapy管道的使用

爬虫scrapy管道的使用

学习目标:

掌握 scrapy管道(pipelines.py)的使用 之前我们在scrapy入门使用一节中学习了管道的基本使用,接下来我们深入的学习scrapy管道的使用 1. pipeline中常用的方法:

process_item(self,item,spider): 管道类中…

快递单号批量查询教程,掌握包裹动态,让你成为物流达人!

亲爱的读者们,你是否曾经为了追踪快递包裹而烦恼?是否曾经为了查询多个快递单号而感到繁琐?现在,我们为你带来一个高效便捷的解决方案——快递单号批量查询教程!让你轻松掌握包裹动态,成为物流达人…

Python爬虫——scrapy_多网页下载

在DangSpider类中设置一个基础url

base_url http://category.dangdang.com/pg

page 1在parse方法中

# 每一页的爬取逻辑都是一样的,所以只需要执行每一页的请求再次调用parse方法就可以了if self.page < 100:self.page 1url self.base_url str(self.page)…

高级深入--day43

通过Fiddler进行手机抓包

通过Fiddler抓包工具,可以抓取手机的网络通信,但前提是手机和电脑处于同一局域网内(WI-FI或热点),然后进行以下设置:

用Fiddler对Android应用进行抓包 打开Fiddler设置 在Conne…

高级深入--day42

注意:模拟登陆时,必须保证settings.py里的 COOKIES_ENABLED (Cookies中间件) 处于开启状态 COOKIES_ENABLED True 或 # COOKIES_ENABLED False 策略一:直接POST数据(比如需要登陆的账户信息) 只要是需要提供post数据的ÿ…

scrapy-redis分布式爬虫(分布式爬虫简述+分布式爬虫实战)

一、分布式爬虫简述

(一)分布式爬虫优势

1.充分利用多台机器的带宽速度

2.充分利用多台机器的ip地址 (二)Redis数据库

1.Redis是一个高性能的nosql数据库

2.Redis的所有操作都是原子性的

3.Redis的数据类型都是基于基本数据…

Python中的Scrapy库

Python中的Scrapy库是一个高效的爬虫框架,用于创建和实现异步的网络爬虫。它提供了一个API来简化爬取网站数据的过程,从而节省开发人员的时间和精力。本篇博客文章将详细介绍Scrapy库的使用和API,并提供相应的代码注释,帮助读者更…

Python爬虫——scrapy_日志信息以及日志级别

日志级别(由高到低) CRITICAL: 严重错误 ERROR: 一般错误 WARNING: 警告 INFO: 一般警告 DEBUG: 调试信息 默认的日志等级是DEBUG 只要出现了DEBUG或者DEBUG以上等级的日志,那么这些…

【Python】从入门到上头—Python基础(2)

文章目录 一.基础语法1.编码2.标识符3.保留字4.注释5.行与缩进6.多行语句7.数字(Number)类型8.字符串(String)9.空行10.等待用户输入11.同一行显示多条语句12.多个语句构成代码组13.print 输出14.import 与 from...import 二.基本数据类型1.变量和赋值2.多个变量赋值3.标准数据…

Python Scrapy网络爬虫框架从入门到实战

Python Scrapy是一个强大的网络爬虫框架,它提供了丰富的功能和灵活的扩展性,使得爬取网页数据变得简单高效。本文将介绍Scrapy框架的基本概念、用法和实际案例,帮助你快速上手和应用Scrapy进行数据抓取。

Scrapy是一个基于Python的开源网络爬…

Python 爬虫—scrapy

scrapy用于从网站中提取所需数据的开源协作框架。以一种快速、简单但可扩展的方式。 该爬虫框架适合于那种静态页面, js 加载的话,如果你无法模拟它的 API 请求,可能就需要使用 selenium 这种使用无头浏览器的方式来完成你的需求了 入门

imp…

爬虫 — Scrapy 框架(二)

目录 一、Scrapy 核心文件1、spider2、Request3、构造 post 请求4、response 二、案例三、Scrapy 下载中间件1、执行顺序2、使用方法3、Download Middlewares 默认方法4、代理 IP4.1、工作原理4.2、分类4.3、查看 IP 地址4.4、常用代理 四、Scrapy 爬虫中间件五、Scrapy 下载图…

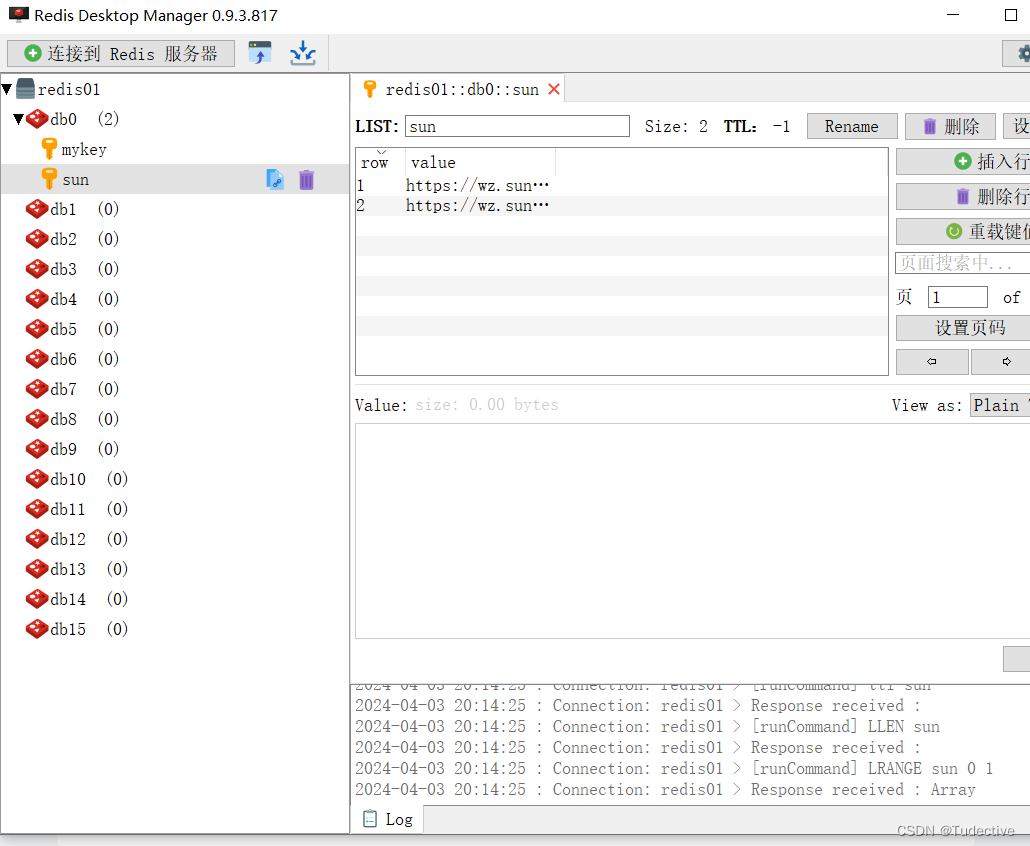

爬虫 — Scrapy-Redis

目录 一、背景1、数据库的发展历史2、NoSQL 和 SQL 数据库的比较 二、Redis1、特性2、作用3、应用场景4、用法5、安装及启动6、Redis 数据库简单使用7、Redis 常用五大数据类型7.1 Redis-String7.2 Redis-List (单值多value)7.3 Redis-Hash7.4 Redis-Set (不重复的)7.5 Redis-Z…

Python3数据科学包系列(二):数据分析实战

Python3中类的高级语法及实战

Python3(基础|高级)语法实战(|多线程|多进程|线程池|进程池技术)|多线程安全问题解决方案

Python3数据科学包系列(一):数据分析实战

Python3数据科学包系列(二):数据分析实战 一:通过read_table函数读取数据创建(DataFrame)数据框 #…

文件管理:极速复制粘贴,畅享无限次文件管理!

亲爱的用户,您是否经常需要将文件夹里的所有文件进行无限次复制粘贴,但又觉得这个过程繁琐而耗时?现在,我们为您推出一款极速文件管理工具,让您可以轻松实现无限次的文件复制粘贴,让文件管理更加高效畅快&a…

电影产业的数据洞察:爬虫技术在票房分析中的应用

概述

电影产业是一个庞大而复杂的行业,涉及到各种各样的因素,如导演、演员、类型、主题、预算、宣传、口碑、评分、奖项等。这些因素都会影响电影的票房收入,也会反映出电影市场的动态和趋势。为了更好地了解电影产业的数据洞察,…

爬虫工作量由小到大的思维转变---<第四章 Scrapy不可迈的坎>

前言: 行吧,咱们聊聊。你看,现在大家都在讲这个异步、多线程,挺火的。然后就有人开始拿来跟Scrapy比,说得好像Scrapy已经过时了似的。其实不是那么回事儿,你要是只想快速搭个接口什么的,那确实,…

使用Selenium与Scrapy处理动态加载网页内容的解决方法

博客正文(包含详细注释)

引言

在爬虫技术领域,处理动态加载的网页内容常常是一项挑战,尤其是对于那些通过用户滚动或其他交互动态加载更多内容的网站。本文将介绍如何结合使用Selenium和Scrapy来有效处理这类网页。

初探Seleni…

PyCharm搭建Scrapy环境

Scrapy入门 1、Scrapy概述2、PyCharm搭建Scrapy环境3、Scrapy使用四部曲4、Scrapy入门案例4.1、明确目标4.2、制作爬虫4.3、存储数据4.4、运行爬虫 1、Scrapy概述

Scrapy是一个由Python语言开发的适用爬取网站数据、提取结构性数据的Web应用程序框架。主要用于数据挖掘、信息处…

scrapy ——链接提取器之爬取读书网数据(十三)

提取多页图书的名字及图片,但总页数未知。 目录

1.CrawlSpider介绍

2.创建爬虫项目

3.爬取读书网并解析数据 1.CrawlSpider介绍 CrawlSpider: 1.继承自 scrapy.spider 2.CrawlSpider可以定义规则。在解析 html 的时候,可以根据链接规则提…

爬虫工作量由小到大的思维转变---<第六章 Scrapy想做事先做人>

前言:

有新留言,说:"scrapy的业务逻辑什么的都没有问题,可是一旦开启,就被封!"

我的建议:1.没有动用ip池之前,调好配置,完善代码; 2.有了ip池之后,调高配置,开始爬取;

-------------也就是,在开始项目前,你要表现得像个"人"!!! 正文:

首先,你就记两个…

爬虫工作量由小到大的思维转变---<第九章 Scrapy存储的选择(sql)>

前言: 顺着讲,就是到了存储模块了;拿到item之后,进行一番数据清理是必不可少的,但是,转存到sql需要考虑哪些事情呢?

正文:

-选择哪个库进行sql的存储?

mysqlclient 和 pymysql 是两个流行的Python库,它们都是 MySQL 数据库的适配器,用于在Python应用…

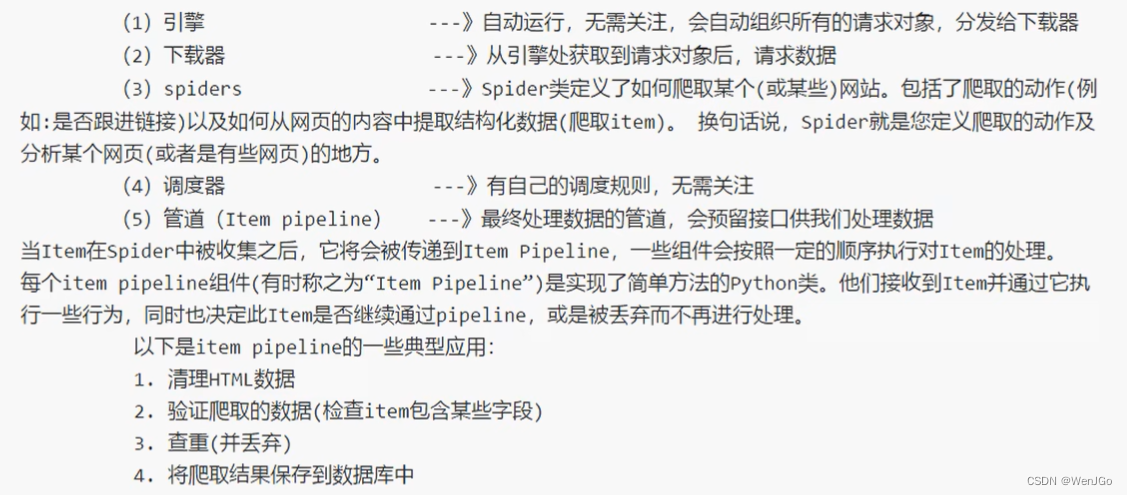

高级深入--day31

Item Pipeline

当Item在Spider中被收集之后,它将会被传递到Item Pipeline,这些Item Pipeline组件按定义的顺序处理Item。

每个Item Pipeline都是实现了简单方法的Python类,比如决定此Item是丢弃而存储。以下是item pipeline的一些典型应用: 验证爬取的数据(检查item包含某…

爬虫工作量由小到大的思维转变---<第十章 Scrapy之sql表单的小心得>

前言:

太多的设计理论也不说了;但是,针对爬虫这一块,有几个小地方,我觉得还是通用的!

(-----版权所有。未经作者书面同意,不得转载或用于任何商业用途!----)

正文:

1. DATETIME 数据类型 DATETIME 类型存储精确到秒的日期和时间信息,对于需要记录具体…

柯桥商务英语口语,口语学习中怎样学习语法和基础单词

英语语法和词汇是成功的英语口语沟通的基础!无论你是在准备英语考试、职场交流,还是在国际旅行中,具备坚实的语法和词汇基础都是至关重要的! 接下来将为大家介绍一些有效的方法,帮助你建立和巩固这两个关键的语言技能&…

爬虫工作量由小到大的思维转变---<第十二章 Scrapy之sql存储与爬虫高效性的平衡艺术>

前言:

(本文仅属于技术性探讨,不属于教文)

刚好,前阵子团队还在闲聊这个问题呢。你知道吗,在数据收集这个行当里,怎么存数据这问题就跟“先有鸡还是先有蓝”一样,没完没了的循环往复。老规矩,咱们先搞清楚我们的“鸡…

基于Scrapyd与Gerapy部署scrapy爬虫方案【可用于分布式爬虫部署】

scrapyd部署爬虫

Scrapyd 是一个基于 Scrapy 的开源项目,它提供了一个简单的方式来部署、运行和监控 Scrapy 爬虫。它是一个用于集成 Scrapy 爬虫到分布式架构中的工具,允许您在分布式环境中运行爬虫,并提供了一组 Web API,用于管…

解决爬虫在重定向(Redirect)情况下,URL没有变化的方法

重定向是一种网络服务,它可以实现从一个网页跳转到另一个网页的功能。它把用户请求的网页重定向到一个新的位置,而这个位置可以是更新的网页,或最初请求的网页的不同版本。另外,它还可以用来改变用户流量,当用户请求某…

高级深入--day45

官方站点:GitHub - rmax/scrapy-redis: Redis-based components for Scrapy.

scrapy-redis的官方文档写的比较简洁,没有提及其运行原理,所以如果想全面的理解分布式爬虫的运行原理,还是得看scrapy-redis的源代码才行。

scrapy-r…

Python爬虫框架Scrapy:实现高效数据抓取

目录

一、引言

二、Scrapy框架概述

1、Scrapy框架特点

2、Scrapy框架结构

三、Scrapy框架的使用

1、安装Scrapy框架

2、创建Scrapy项目

3、创建爬虫

4、运行爬虫

四、Scrapy框架常见问题及解决方案

1、请求被网站封禁

2、处理动态加载的页面

3、避免被网站检测到爬…

scrapy发json的post请求

一 、scrapy发json的post请求: def start_requests(self):self.headers {Content-Type: application/json}json_data {"productName": "", "currentPage": "1", "recordNumber": "10", "langua…

Scrapy----Scrapy简介

文章目录 概述与应用背景架构和组件功能和特点社区生态概述与应用背景

Scrapy,一个高效、灵活、且强大的Web爬取框架,被广泛应用于数据抓取和网页内容的结构化提取。它是用Python编写的,支持多平台运行,适用于数据挖掘、在线零售信息收集、历史数据存档等多种场景。Scrapy…

【Python爬虫】8大模块md文档集合从0到scrapy高手,第7篇:selenium 数据提取详解

本文主要学习一下关于爬虫的相关前置知识和一些理论性的知识,通过本文我们能够知道什么是爬虫,都有那些分类,爬虫能干什么等,同时还会站在爬虫的角度复习一下http协议。

爬虫全套笔记地址: 请移步这里 共 8 章&#x…

Scrapy爬虫异步框架之持久化存储(一篇文章齐全)

1、Scrapy框架初识(点击前往查阅)

2、Scrapy框架持久化存储(点击前往查阅)

3、Scrapy框架内置管道(点击前往查阅)

4、Scrapy框架中间件(点击前往查阅) Scrapy 是一个开源的、基于…

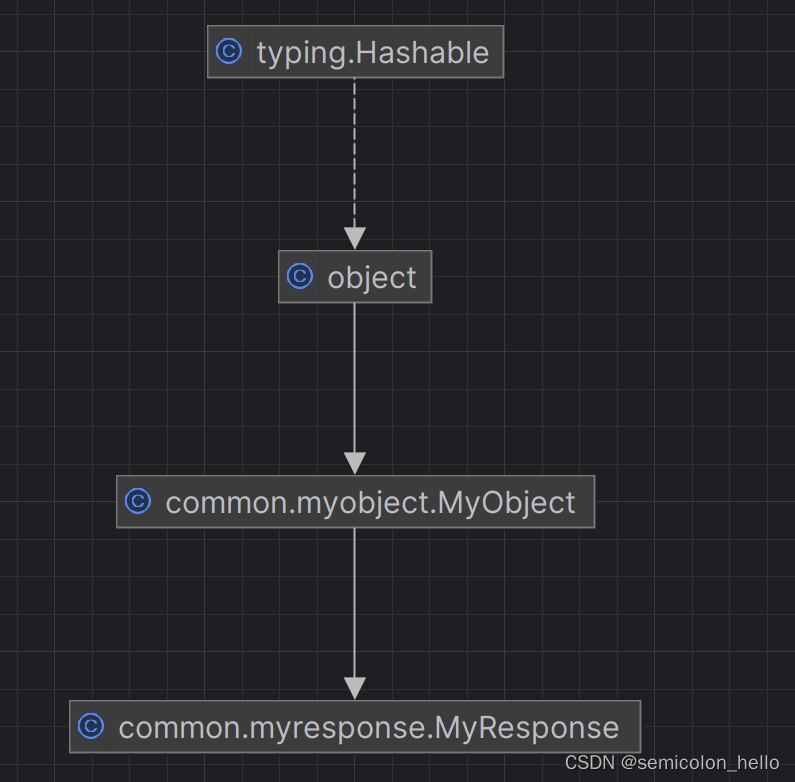

手写myscrapy(五)

项目地址:https://gitee.com/wyu_001/myscrapy

我们继续完成返回的处理类 MyResponse的实现 先上类图: 主要功能: json() 方法解析返回的json格式内容,转换为 python 的json对象

xpath()方法解析返回的html格式的内…

手写myscrapy(六)

项目地址:https://gitee.com/wyu_001/myscrapy

我们还是继续完成主要功能类:MySpider类,它继承MyObject类,完成主要接口功能。编写爬取脚本也是要继承这个类。 我们举例说明: 我们假设爬取百度的新闻页几个标题和链接…

【Python从入门到进阶】49、当当网Scrapy项目实战(二)

接上篇《48、当当网Scrapy项目实战(一)》 上一篇我们正式开启了一个Scrapy爬虫项目的实战,对当当网进行剖析和抓取。本篇我们继续编写该当当网的项目,讲解刚刚编写的Spider与item之间的关系,以及如何使用itemÿ…

BeautifulSoup+xpath+re+css简单复习+新的scrapy的学习

1.BeautifulSoupsoup BeautifulSoup(html,html.parser)all_icosoup.find(class_"DivTable") 2.xpath trs resp.xpath("//tbody[idcpdata]/tr")

hong tr.xpath("./td[classchartball01 or classchartball20]/text()").extract()

这个意思是找…

爬虫入门四(抽屉半自动点赞、xpath使用、动作链、打码平台、scrapy框架介绍与安装及创建项目)

文章目录 一、抽屉半自动点赞二、xpath的使用三、动作链四、打码平台介绍超级鹰打码基本测试 五、自动登录超级鹰六、scrapy框架介绍安装创建爬虫项目 一、抽屉半自动点赞 登录抽屉账号保存cookiesimport timeimport jsonfrom selenium import webdriverfrom selenium.webdrive…

Scrapy框架:HTML页面解析与泛解析技术

Scrapy是一个功能强大的Web爬取框架,专为提取网页数据而设计。在Scrapy中提取数据通常涉及到HTML页面解析,以及为了更通用的爬取需求实施泛解析技术。本篇博客将详细介绍如何在Scrapy中进行HTML页面的具体解析和泛解析,并提供示例代码。

HTM…

Scrapy与分布式开发(2.2):正则表达式

使用Python的re模块进行正则表达式操作详细讲解

一、引言 正则表达式是一种强大的文本处理工具,它使用特定的模式来搜索、匹配和替换文本。Python的re模块(正则表达式模块)提供了正则表达式匹配操作的所有功能。下面我们将详细讲解如何使用re模块进行正则表达式的操作。

二…

Scrapy与分布式开发(2.1.2):python常用网络请求库httpx

Python httpx 模块详细讲解

一、引言

httpx 是一个用于发送 HTTP 请求的 Python 库,它提供了简单易用的 API,支持同步和异步请求,并且具有出色的性能和灵活性。httpx 是 requests 的一个现代替代品,它使用 httpcore 作为底层传输层,支持 HTTP/1.1 和 HTTP/2 协议。

二、…

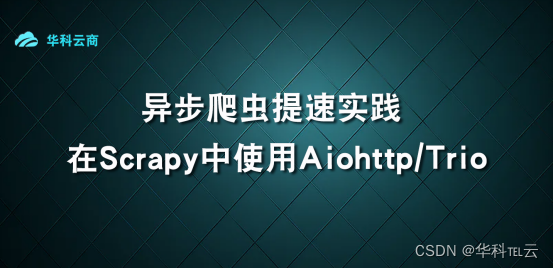

异步爬虫提速实践-在Scrapy中使用Aiohttp/Trio

在构建爬虫系统时,提高爬虫速度是一个关键问题。而使用异步爬虫技术可以显著提升爬取效率。在本文中,我将与大家分享如何在Scrapy中利用Aiohttp或Trio库实现异步爬取,以加快爬虫的速度。让我们开始吧!

1. 安装所需的库

首先&…

go语言使用代码示例

在Go语言中,使用HTTP代码示例可以帮助我们发送HTTP请求并处理HTTP响应。下面是一个简单的示例,演示了如何使用Go语言发送HTTP GET请求并处理响应。

go复制代码 package main import ( "fmt" "io/ioutil" "…

“智能批量复制文件:轻松实现高效且有序的编号复制“

在日常工作中,我们经常需要批量复制文件并给它们编号。这是一项非常繁琐的任务,但是现在,我们向你介绍一种全新的解决方案,帮助你轻松实现文件批量复制并编号。

首先,第一步我们要进入“文件批量改名高手”的主页面并…

数据分析Pandas

数据分析Pandas

Pandas简介第一个PandasPandas APIPandas数据结构Pandas数据结构SeriesSeries API创建 SeriesSeries基本属性和方法Series索引操作Series切片操作Series过滤数据Series算术运算Series缺失数据处理Series排序和排名Series统计函数Pandas数据结构DataFrameDataFr…

Codeforces Round 170 (Div. 1)A. Learning Languages并查集

如果两个人会的语言中有共同语言那么他们之间就可以交流,并且如果a和b可以交流,b和c可以交流,那么a和c也可以交流,具有传递性,就容易联想到并查集,我们将人和语言看成元素,一个人会几种语言的话…

爬虫实战——scrapy框架爬取多张图片

scrapy框架的基本使用,请参考我的另一篇文章:scrapy框架的基本使用

起始爬取的网页如下: 点击每张图片,可以进入图片的详情页,如下: 代码实现:

项目文件结构如下 img_download.py文件代码

im…

scrapy 中间件

就是发送请求的时候,会经过,中间件。中间件会处理,你的请求 下面是代码:

# Define here the models for your spider middleware

#

# See documentation in:

# https://docs.scrapy.org/en/latest/topics/spider-middleware.html…

scrapy 爬虫:多线程爬取去微博热搜排行榜数据信息,进入详情页面拿取第一条微博信息,保存到本地text文件、保存到excel

如果想要保存到excel中可以看我的这个爬虫

使用Scrapy 框架开启多进程爬取贝壳网数据保存到excel文件中,包括分页数据、详情页数据,新手保护期快来看!!仅供学习参考,别乱搞_爬取贝壳成交数据c端用户登录-CSDN博客 最终…

Python爬虫——Scrapy-1

目录

简介

安装

基本使用

1. 创建爬虫的项目

2. 创建爬虫文件

3. 运行爬虫代码

scrapy项目组成

scrapy工作原理

编辑 58同城

scrapy架构组成

汽车之家

总结 简介 Scrapy 是一个基于 Python 的开源网络爬虫框架,它可以帮助开发者快速、高效地构…

爬虫入门到精通_框架篇15(Scrapy框架安装)

1 Scrapy安装

Scrapy的安装有多种方式,它支持Python2.7版本及以上或Python3.3版本及以上。下面说明Python3环境下的安装。 Scrapy依赖的库比较多,至少需要依赖库有Twisted14.0,lxml 3.4,pyOpenSSL 0.14。而在不同平台环境又各不相同,所以在安…

Scrapy与分布式开发:MongoDB安装与快速入门

MongoDB安装与快速入门

一、MongoDB 概述

MongoDB 是一个面向文档的数据库系统,使用 BSON(Binary JSON)格式存储数据,提供了高性能、高可用性和易扩展性。它专为 Web 应用和大数据场景设计,通过简单的数据模型、强大…

scrapy分布式爬虫的部署,调度,与管理(scrapy + scrapy-redis + scrapyd + gerapy)

使用到的框架及软件包介绍 Github Gerapy 提供主机管理,爬虫项目管理,爬虫任务管理的web管理后台。Github Scrapy-redis 提供中心化的任务队列,任务指纹队列,供分布式爬虫共享爬取任务队列。Github Scrapyd 提供通过api方式单机部署爬虫的功能,爬虫状态查询等。Github Scr…

Scrapy爬虫在新闻数据提取中的应用

Scrapy是一个强大的爬虫框架,广泛用于从网站上提取结构化数据。下面这段代码是Scrapy爬虫的一个例子,用于从新闻网站上提取和分组新闻数据。

使用场景

在新闻分析和内容聚合的场景中,收集和组织新闻数据是常见需求。例如,如果我…

scrapy框架核心知识Spider,Middleware,Item Pipeline,scrapy项目创建与启动,Scrapy-redis与分布式

scrapy项目创建与启动

创建项目

在你的工作目录下直接使用命令:

scrapy startproject scrapytutorial运行后创建了一个名为scrapytutorial的爬虫工程

创建spider

在爬虫工程文件内,运行以下命令:

scrapy genspider quotes创建了名为quotes的爬虫

…

架构学习(一):scrapy实现按脚本name与日期生成日志文件

原生scrapy日志机制

一般情况下,我们可以直接在setting文件中定义日志文件,这种会把所有脚本的日志都写在同一个文件

LOG_LEVEL INFO # 日志级别

LOG_STDOUT True # 日志标准输出

LOG_FILE rD:\python\crawler\logs\1163.log # 日志文件路径现在…

【Python从入门到进阶】44、Scrapy的基本介绍和安装

接上篇《43.验证码识别工具结合requests的使用》 上一篇我们学习了如何使用验证码识别工具进行登录验证的自动识别。本篇我们开启一个新的章节,来学习一下快速、高层次的屏幕抓取和web抓取框架Scrapy。

一、Scrapy框架的背景和特点 Scrapy框架是一个为了爬取网站数…

scrapy_redis实战去哪儿旅游信息爬虫(分布式爬虫实例)

前言

在这个信息爆炸的时代,网络上充斥着大量的旅游信息,而其中关于景区的介绍和评论更是琳琅满目。然而,对于想要获取特定景区信息并了解其真实评价的人来说,筛选和获取准确、有用的数据可能是一项极具挑战性的任务。为了解决这…

scrapy快加构造并发送请求

scrapy数据建模与请求

学习目标:

应用 在scrapy项目中进行建模应用 构造Request对象,并发送请求应用 利用meta参数在不同的解析函数中传递数据 1. 数据建模 通常在做项目的过程中,在items.py中进行数据建模 1.1 为什么建模

定义item即提前…

python爬虫进阶篇:scrapy爬虫框架的依赖库搭建和项目创建

一、前言

上篇我们记录了Scrapy的各个组件功能,这篇我们来动手scrapy爬虫框架的依赖库搭建和项目创建,开始进入进阶实战。

二、环境搭建

安装依赖库

pip install lxml4.9.2

pip install parsel1.6.0

pip install Twisted21.2.0

pip install pyOpenSS…

在scrapy 使用selenium模拟登录获取cookie

前言

最近有一点点爬虫需求,想总结一下scrapy框架的一些基本使用方法,加深印象,自己一直习惯使用一些脚本文件运行爬虫,面对数据量非常大,稳定性要求比较高的,效率需求比较高的情况下还是用scrapy较为合适…

scrapy_redis概念作用和流程

scrapy_redis概念作用和流程

学习目标

了解 分布式的概念及特点了解 scarpy_redis的概念了解 scrapy_redis的作用了解 scrapy_redis的工作流程 在前面scrapy框架中我们已经能够使用框架实现爬虫爬取网站数据,如果当前网站的数据比较庞大, 我们就需要使用分布式来更快的爬取数…

python爬虫进阶篇:Scrapy中使用Selenium模拟Firefox火狐浏览器爬取网页信息

一、前言

接着上一篇的笔记,Scrapy爬取普通无反爬、静态页面的网页时可以顺利爬取我们要的信息。但是大部分情况下我们要的数据所在的网页它是动态加载出来的(ajax请求后传回前端页面渲染、js调用function等)。这种情况下需要使用selenium进…

爬虫工作量由小到大的思维转变---<第二十一章 Scrapy日志设置与Python的logging模块对比>

前言:

在开发爬虫程序时,日志记录对于调试和故障排除至关重要。Scrapy是一个强大的Python爬虫框架,提供了自己的日志设置功能。然而,与Python的标准库logging模块相比,Scrapy的日志设置有其独特的优势和用法。

正文:

Scrapy中的…

爬虫工作量由小到大的思维转变---<第二十二章 Scrapy开始很快,越来越慢(诊断篇)>

前言:

相信很多朋友在scrapy跑起来看到速度200/min开心的不得了;可是,越跑到后面,发现速度变成了10-/min;刚开始以为是ip代理的问题,结果根本不得法门...

新手跑3000 ~ 5000左右数据,我相信大多数人没有问题,也不会发现问题;

可一旦数据量上了10W,你是不是就能明显感觉到速度…

Python:Scrapy+Selenium相关依赖包记录

存到txt文件中,在python环境中运行 pip install -r xxx.txt安装

attrs23.1.0

Automat22.10.0

certifi2023.11.17

cffi1.16.0

constantly23.10.4

cryptography2.8

cssselect1.2.0

filemagic1.6

hyperlink21.0.0

idna3.6

incremental22.10.0

jmespath1.0.1

lxml4.9.2…

【Python从入门到进阶】45、Scrapy框架核心组件介绍

接上篇《44、Scrapy的基本介绍和安装》 上一篇我们学习了Scrapy框架的基础介绍以及环境的搭建,本篇我们来学习一下Scrapy框架的核心组件的使用。

下面的核心组件的介绍,仍是基于这幅图的机制,大家可以再回顾一下: 注:…

爬虫工作量由小到大的思维转变---<第三十章 Scrapy Redis 第一步(配置同步redis)>

前言:

要迈向scrapy-redis进行编写了;首要的一步是,如何让他们互通?也就是让多台电脑连一个任务(这后面会讲); 现在来做一个准备工作,配置好redis的同步!!

针对的是windows版本的redis同步,实现主服务和从服务共享一个redis库; 正文:

正常的redis for windows 的安装这里就…

爬虫工作量由小到大的思维转变---<第三十五章 Scrapy 的scrapyd+Gerapy 部署爬虫项目>

前言:

项目框架没有问题大家布好了的话,接着我们就开始部署scrapy项目(没搭好架子的话,看我上文爬虫工作量由小到大的思维转变---<第三十四章 Scrapy 的部署scrapydGerapy>-CSDN博客) 正文:

1.创建主机:

首先gerapy的架子,就相当于部署服务器上的;所以…

如何使用Scrapy提取和处理数据

目录

一、安装和设置Scrapy

二、创建爬虫

三、提取数据

四、处理数据

五、存储数据

六、进阶操作

七、注意事项

总结 Scrapy是一个强大且灵活的Python库,用于创建网页爬虫,提取和处理数据。本文将为您深入讲解如何使用Scrapy进行数据处理&#x…

5-爬虫-打码平台、打码平台自动登录打码平台、selenium爬取京东商品信息、scrapy介绍安装、scrapy目录结构

1 打码平台 1.1 案例 2 打码平台自动登录打码平台 3 selenium爬取京东商品信息 4 scrapy介绍安装 5 scrapy目录结构 1 打码平台

# 1 登录某些网站,会有验证码---》想自动破解-数字字母:python模块:ddddocr-计算题,成语题…

探索Scrapy中间件:自定义Selenium中间件实例解析

简介

Scrapy是一个强大的Python爬虫框架,可用于从网站上抓取数据。本教程将指导你创建自己的Scrapy爬虫。其中,中间件是其重要特性之一,允许开发者在爬取过程中拦截和处理请求与响应,实现个性化的爬虫行为。

本篇博客将深入探讨…

Python爬虫---scrapy shell 调试

Scrapy shell是Scrapy提供的一个交互式shell工具,它可以帮助我们进行爬虫的开发和调试。可以使用它来测试xpath或css表达式,查看它们是如何工作的,以及它们从你试图抓取的网页中提取的数据。它允许你在编写spider时交互地测试表达式ÿ…

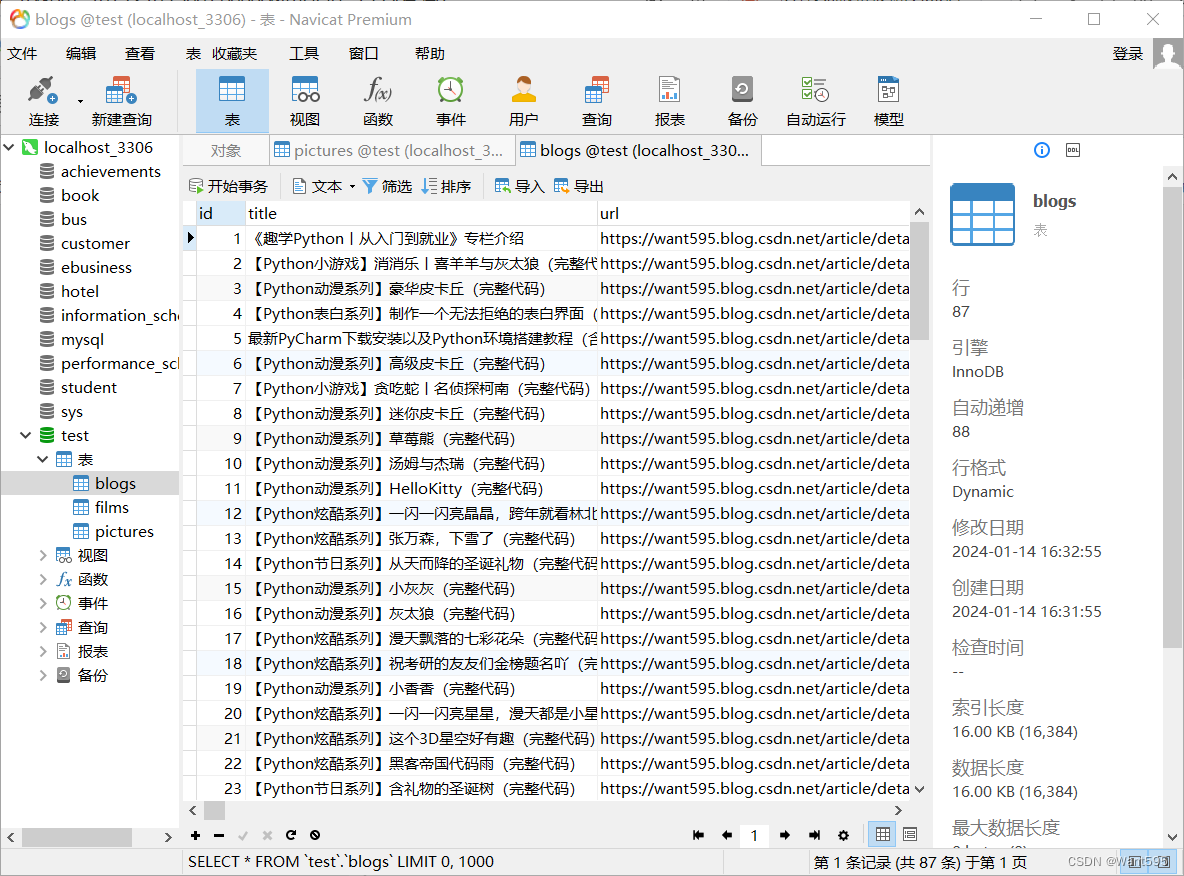

网络爬虫丨基于scrapy+mysql爬取博客信息并保存到数据库中

文章目录 写在前面实验描述实验框架实验需求 实验内容1.安装依赖库2.创建Scrapy项目3.配置系统设置4.配置管道文件5.连接数据库6.分析要爬取的内容7.编写爬虫文件 运行结果写在后面 写在前面

本期内容:基于scrapymysql爬取博客信息并保存到数据库中

实验需求

ana…

【Python从入门到进阶】47、Scrapy Shell的了解与应用

接上篇《46、58同城Scrapy项目案例介绍》 上一篇我们学习了58同城的Scrapy项目案例,并结合实际再次了项目结构以及代码逻辑的用法。本篇我们来学习Scrapy的一个终端命令行工具Scrapy Shell,并了解它是如何帮助我们更好的调试爬虫程序的。

一、Scrapy Sh…

scrapy的基本使用介绍

创建项目

### 1. 创建虚拟环境

conda create -n spiderScrapy python3.9

### 2. 安装scrapy

pip install scrapy2.8.0 -i https://pypi.tuna.tsinghua.edu.cn/simple### 3. 生成一个框架

scrapy startproject my_spider### 4. 生成项目

scrapy genspider baidu https://www.b…

使用scrapy爬取蜻蜓FM

创建框架和项目

### 1. 创建虚拟环境

conda create -n spiderScrapy python3.9

### 2. 安装scrapy

pip install scrapy2.8.0 -i https://pypi.tuna.tsinghua.edu.cn/simple### 3. 生成一个框架并进入框架

scrapy startproject my_spider

cd my_spider### 4. 生成项目

scrapy …

【Scrapy】京东商品数据可视化

【Scrapy】京东商品数据可视化 文章目录 【Scrapy】京东商品数据可视化 👉引言💎一、爬取数据:1.1 scrapy爬虫库简介:1.2 技术实现:1.2.1搭建框架结构1.2.2 分析网页结构 二、数据保存:三、数据读取以及…

【Python从入门到进阶】50、当当网Scrapy项目实战(三)

接上篇《49、当当网Scrapy项目实战(二)》 上一篇我们讲解了的Spider与item之间的关系,以及如何使用item,以及使用pipelines管道进行数据下载的操作,本篇我们来讲解Scrapy的多页面下载如何实现。

一、多页面下载原理分…

【爬虫框架Scrapy】02 Scrapy入门案例

接下来介绍一个简单的项目,完成一遍 Scrapy 抓取流程。通过这个过程,我们可以对 Scrapy 的基本用法和原理有大体了解。

1. 本节目标

本节要完成的任务如下。 创建一个 Scrapy 项目。 创建一个 Spider 来抓取站点和处理数据。 通过命令行将抓取的内容…

爬虫实战四、PyCharm+Scrapy爬取数据并存入MySQL

注意:此博客衔接爬虫实战三、PyCharm搭建Scrapy开发调试环境,参考此博客之前请详细阅读爬虫实战三、PyCharm搭建Scrapy开发调试环境

#一、创建爬虫项目

注意:不能直接使用PyCharm创建Scrapy项目,所以需要在爬虫实战三、PyCharm搭…

Python爬虫之分布式爬虫

分布式爬虫

1.详情介绍 分布式爬虫是指将一个爬虫任务分解成多个子任务,在多个机器上同时执行,从而加快数据的抓取速度和提高系统的可靠性和容错性的技术。 传统的爬虫是在单台机器上运行,一次只能处理一个URL,而分布式爬虫通过将…

爬虫实战三、PyCharm搭建Scrapy开发调试环境

#一、环境准备 Python开发环境以及Scrapy框架安装,参考:爬虫实战一、Scrapy开发环境(Win10Anaconda)搭建 PyCharm安装和破解,参考:爬虫实战二、2019年PyCharm安装(激活到2100年)

…

爬虫实战一、Scrapy开发环境(Win10+Anaconda3)搭建

#前言 在这儿推荐使用Anaconda进行安装,并不推荐大家用pythonpip安装,因为pythonpip的坑实在是太多了。

#一、环境中准备:

Win10(企业版)Anaconda3-5.0.1-Windows-x86_64,下载地址,如果打不开…

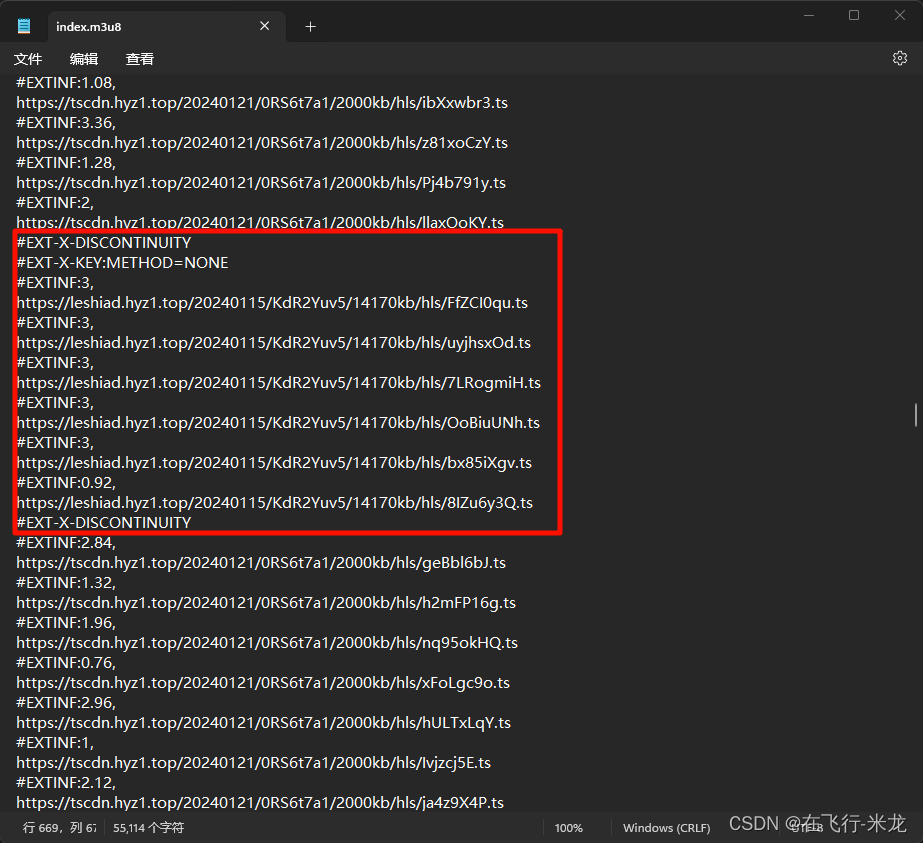

Scrapy 爬取m3u8视频

Scrapy 爬取m3u8视频

【一】效果展示

爬取ts文件样式 合成的MP4文件 【二】分析m3u8文件路径

视频地址:[在线播放我独自升级 第03集 - 高清资源](https://www.physkan.com/ph/175552-8-3.html)

【1】找到m3u8文件

这里任务目标很明确 就是找m3u8文件 打开浏览器…

Python爬虫之增量式爬虫

相关介绍 增量式爬虫是一种用于爬取网页信息的技术,它与全量式爬虫相比具有更高效和节省资源的特点。

增量式爬虫的基本原理是通过比较已爬取的数据和新爬取的数据,只爬取和更新最新的数据。它会记录上一次爬取的状态,将新爬取的数据和已有的…

网络爬虫框架Scrapy之Scrapyd部署Scrapy项目

Scrapyd部署Scrapy项目 scrapyd服务器端客户端 scrapy项目部署配置需要部署的项目部署项目到scrapyd Web API调度Scrapy爬虫启动爬虫停止爬虫获取项目列表获取项目所有爬虫列表获取项目爬虫任务的列表获取爬虫运行日志获取守护进程状态信息使用requests模块调度Scrapy爬虫 scra…

Python爬虫之Scrapy框架基础

Scrapy爬虫框架介绍 文档 英文文档中文文档 什么是scrapy 基于twisted搭建的异步爬虫框架. scrapy爬虫框架根据组件化设计理念和丰富的中间件, 使其成为了一个兼具高性能和高扩展的框架 scrapy提供的主要功能 具有优先级功能的调度器去重功能失败后的重试机制并发限制ip使用次…

Scrapy IP()类 编程指南(基础)

Scrapy IP()类 编程指南(基础)

IP简介